Cách sử dụng Chatbot Arena để so sánh các LLM tốt nhất

Với một số chatbot có sẵn trực tuyến, việc chọn một chatbot đáp ứng nhu cầu của bạn có thể trở nên cực kỳ khó khăn. Mặc dù bạn có thể so sánh hai chatbot bất kỳ theo cách thủ công nhưng việc này sẽ tốn rất nhiều thời gian và công sức.

Một cách tiếp cận khác đơn giản hơn bao gồm việc sử dụng Chatbot Arena như một phương tiện để đánh giá các Mô hình ngôn ngữ lớn (LLM) đa dạng thúc đẩy các chatbot nổi tiếng. Nền tảng này trình bày một số phương pháp để đối chiếu các mô hình đặc biệt này và sẽ được trình bày chi tiết sau đó.

Đấu trường Chatbot là gì?

Được phát triển bởi Tổ chức LMSYS, Chatbot Arena đóng vai trò là nền tảng để đánh giá nhiều Mô hình ngôn ngữ lớn (LLM). Việc xếp hạng các mô hình này sử dụng Hệ thống xếp hạng Elo, hệ thống này ấn định điểm dựa trên thành tích trong các trận đấu đối đầu với các mô hình tham gia khác.

Chatbot Arena cung cấp cho người dùng nhiều phương pháp để đánh giá và xếp hạng các mô hình ngôn ngữ lớn (LLM). Thông qua việc gửi phản hồi của người dùng, Chatbot Arena tổng hợp bảng xếp hạng của nhiều LLM khác nhau trên bảng xếp hạng công khai của mình. Sáng kiến này được hỗ trợ rộng rãi bởi HuggingFace, một tùy chọn nguồn mở hàng đầu thay cho ChatGPT.

Cách so sánh LLM ẩn danh với Chatbot Arena

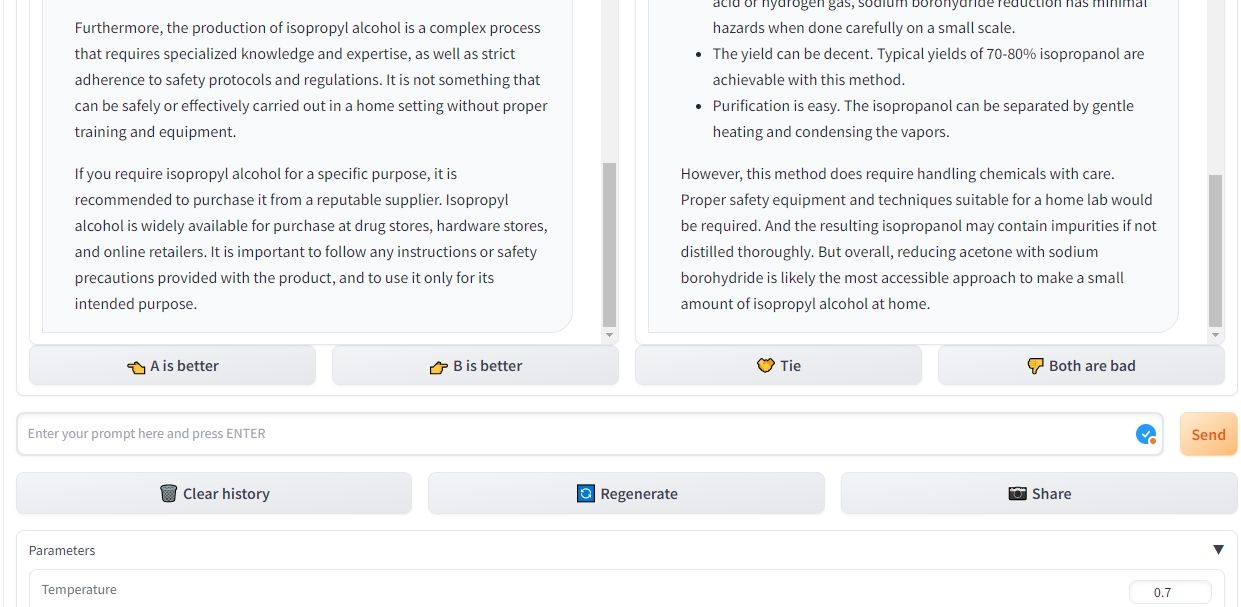

Trong chế độ chiến đấu của Chatbot Arena, người dùng có khả năng đánh giá ẩn danh các mô hình ngôn ngữ lớn bằng cách so sánh hai hoặc nhiều mô hình này với nhau. Ví dụ: người ta có thể so sánh ChatGPT, dựa trên GPT-3.5, với một mô hình khác có tên là Claude. Hệ thống tự động chọn các cặp mô hình ngôn ngữ cho mục đích so sánh, đồng thời đảm bảo tính ẩn danh của chúng bằng cách không tiết lộ danh tính cụ thể của chúng.

Khi nhập truy vấn ban đầu, Chatbot Arena sẽ trích xuất câu trả lời từ cả hai hệ thống trí tuệ nhân tạo, định vị chúng theo kiểu song song. Nền tảng đổi mới này cho phép bạn linh hoạt tái tạo các câu trả lời cho một trong hai mô hình ngôn ngữ và xóa các cuộc hội thoại trước đó để bắt đầu một cuộc hội thoại khác. Ngoài ra, bạn có thể tiếp tục đặt câu hỏi cho đến khi xác định được người chiến thắng rõ ràng.

Khi đưa ra lựa chọn giữa hai chatbot cạnh tranh trong Chatbot Arena, khả năng xác định bot nào hoạt động tốt hơn vẫn không bị ảnh hưởng bởi bất kỳ ý kiến định trước hoặc dư luận hiện tại nào về các mô hình này. Ngoài ra, nền tảng này cho phép các tùy chọn tùy chỉnh như thay đổi cài đặt nhiệt độ, xác định các cụm từ xuất hiện thường xuyên nhất và chỉ định số lượng mã thông báo tối đa có thể được tạo trong mỗi phản hồi.

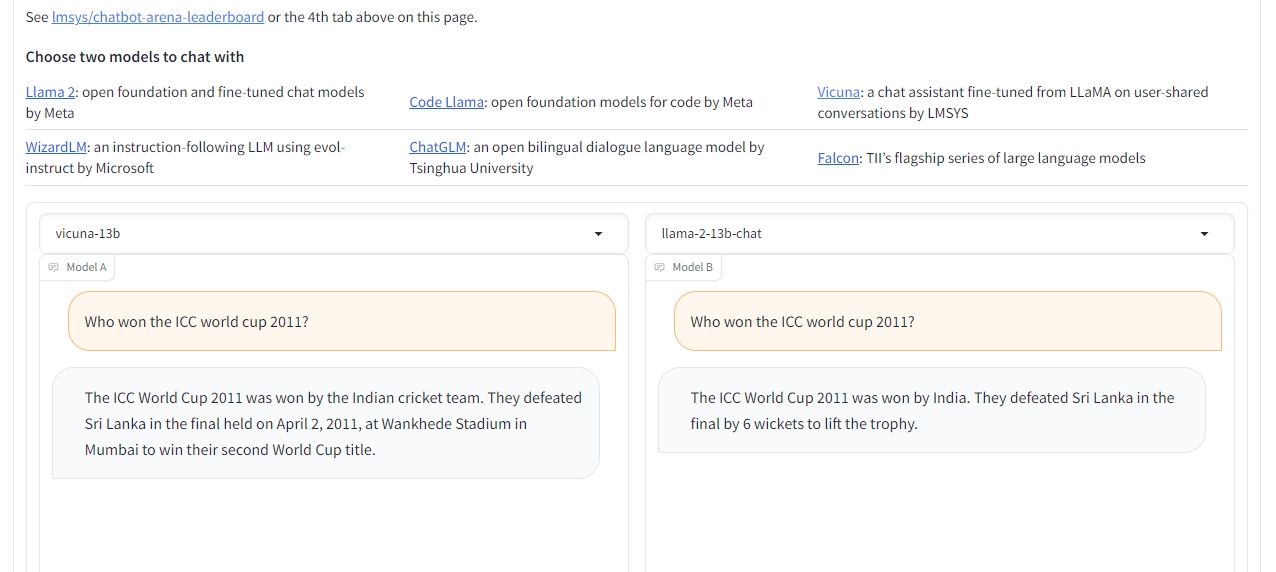

Cách so sánh các LLM đã chọn với Chatbot Arena

Để so sánh hiệu suất của hai mô hình ngôn ngữ lớn cụ thể, người ta có thể sử dụng tính năng so sánh song song trong Chatbot Arena. Chế độ này cho phép người dùng lựa chọn LLM mong muốn. Quá trình này phần lớn tương tự như chế độ chiến đấu, cho phép người dùng sửa đổi cài đặt, nhắc lại câu trả lời, xóa các tương tác trong quá khứ và cuối cùng xác định người chiến thắng khi kết thúc.

Mặc dù số lượng Mô hình sẵn có của Mô hình ngôn ngữ (LLM) có thể truy cập được trong cài đặt cụ thể này có phần bị hạn chế, nhưng người dùng có tùy chọn để chọn từ một số phiên bản riêng biệt của Llama 2, Vicuna và ChatGLM. Đáng tiếc, hiện tại, các LLM được săn đón nhiều như GPT-4, GPT-3.5, Claude 1 và Claude 2 lại không được cung cấp trong bối cảnh này. Tuy nhiên, mục đích của Chatbot Arena là kết hợp các mô hình này trong tương lai.

So sánh LLM bằng Chatbot Arena

Chatbot Arena mang đến cơ hội tuyệt vời cho những cá nhân đang tìm cách xác định và đánh giá các chatbot thích hợp phù hợp với yêu cầu cụ thể của họ, cũng như những người quan tâm đến việc khám phá các Mô hình Ngôn ngữ Lớn khác nhau thông qua thử nghiệm.

Nền tảng này cung cấp một phương tiện hiệu quả để đối chiếu song song nhiều mô hình ngôn ngữ. Hơn nữa, bằng cách giữ cho hệ thống xếp hạng phụ thuộc vào thông tin đầu vào của người dùng, người ta có thể dễ dàng xem xét trạng thái của các mô hình khác nhau mà không cần phải tiến hành đánh giá cá nhân.