Cách tải xuống và cài đặt Llama 2 cục bộ

Meta đã phát hành Llama 2 vào mùa hè Phiên bản mới của Llama được tinh chỉnh với số lượng token nhiều hơn 40% so với mô hình Llama ban đầu, tăng gấp đôi độ dài ngữ cảnh và vượt trội đáng kể so với các mô hình nguồn mở khác hiện có. Cách nhanh nhất và dễ nhất để truy cập Llama 2 là thông qua API thông qua nền tảng trực tuyến. Tuy nhiên, nếu bạn muốn có trải nghiệm tốt nhất thì cài đặt và tải Llama 2 trực tiếp trên máy tính là tốt nhất.

Khi cân nhắc điều này, chúng tôi đã phát triển một hướng dẫn toàn diện phác thảo quy trình sử dụng WebUI tạo văn bản để tải xuống và chạy Mô hình ngôn ngữ lớn Llama 2 (LLM) được lượng tử hóa trên máy tính cá nhân của bạn.

Tại sao phải cài đặt Llama 2 cục bộ

Việc chạy Llama 2 trực tiếp có thể được thúc đẩy bởi nhiều yếu tố khác nhau như cân nhắc về quyền riêng tư, mong muốn tùy chỉnh và nhu cầu về chức năng ngoại tuyến. Tuy nhiên, nếu một người tham gia nghiên cứu, tinh chỉnh hoặc kết hợp Llama 2 vào công việc của họ thì việc sử dụng API của nó có thể không phù hợp. Mục tiêu chính của việc sử dụng mô hình AI cục bộ như Llama 2 là giảm bớt sự phụ thuộc vào tài nguyên AI bên ngoài trong khi tận hưởng sự linh hoạt của việc sử dụng trí tuệ nhân tạo bất cứ lúc nào và ở đâu mà không lo ngại về việc rò rỉ thông tin có khả năng nhạy cảm cho các tập đoàn và các thực thể khác.

Để bắt đầu cuộc thảo luận của chúng ta về quá trình cài đặt Llama 2 trong môi trường cục bộ, tôi sẽ giới thiệu cho bạn hướng dẫn từng bước chi tiết và hùng hồn để đạt được nhiệm vụ này một cách thành công.

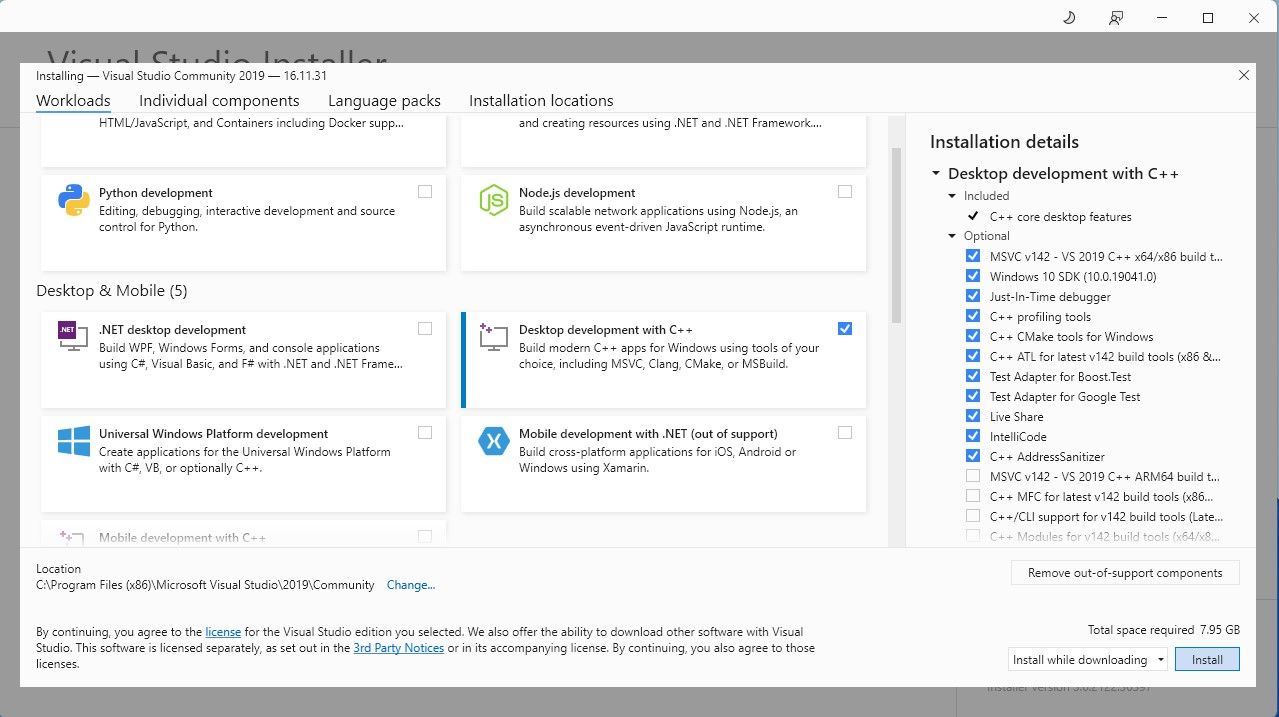

Bước 1: Cài đặt Visual Studio 2019 Build Tool

Để hợp lý hóa quy trình, chúng tôi đã triển khai gói cài đặt chỉ bằng một cú nhấp chuột cho Text-Generation-WebUI, được sử dụng để giao tiếp với Llama 2 thông qua giao diện người dùng đồ họa. Tuy nhiên, bạn bắt buộc phải có Công cụ xây dựng Visual Studio 2019 và cài đặt các thành phần cần thiết trước khi tiến hành cài đặt gói nói trên.

Tải xuống: Visual Studio 2019 (Miễn phí)

Vui lòng tải xuống bản sao phần mềm phiên bản cộng đồng của chúng tôi ngay bây giờ.

⭐ Bây giờ hãy cài đặt Visual Studio 2019, sau đó mở phần mềm lên. Sau khi mở, hãy đánh dấu vào ô Phát triển máy tính để bàn bằng C\+\+ và nhấn cài đặt.

Sau khi hoàn tất quá trình cài đặt Phát triển máy tính để bàn với C++, hãy tiến hành tải xuống trình cài đặt một cú nhấp chuột tạo văn bản-WebUI để có trải nghiệm liền mạch.

Bước 2: Cài đặt Text-Generation-WebUI

Trình cài đặt một cú nhấp chuột tạo văn bản-WebUI là một tập lệnh, thông qua tự động hóa, thiết lập các thư mục cần thiết và định cấu hình môi trường Conda cùng với tất cả các điều kiện tiên quyết để thực thi mô hình Trí tuệ nhân tạo.

Để có được tập lệnh, bạn có thể tải xuống trình cài đặt thuận tiện chỉ bằng một cú nhấp chuột bằng cách nhấp vào “Mã” rồi chọn “Tải xuống ZIP”.

Tải xuống: Trình cài đặt Text-Generation-WebUI (Miễn phí)

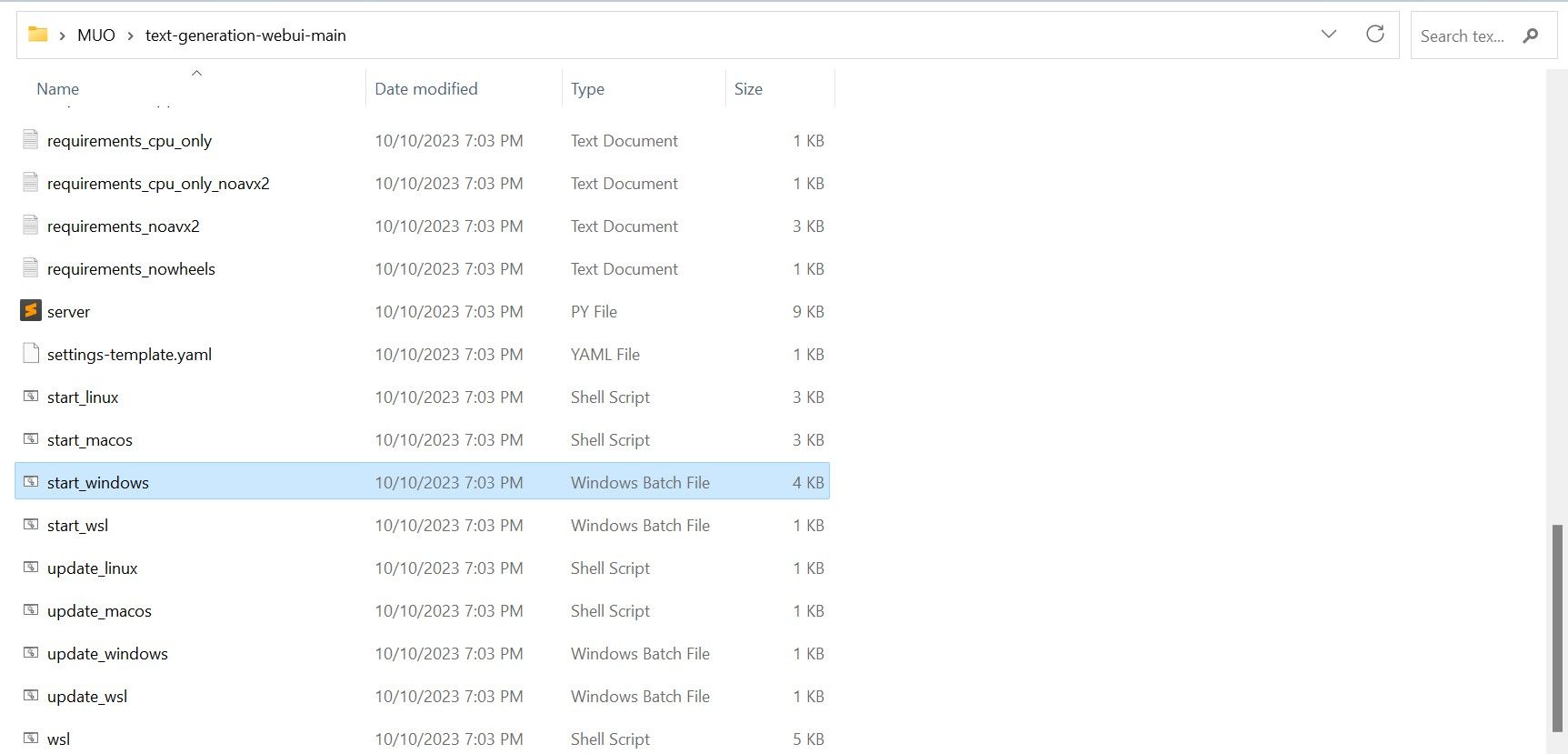

Khi tải xuống kho lưu trữ ZIP, bạn có thể chọn giải nén nó và lưu nội dung của nó vào thư mục bạn chọn. Để làm như vậy, chỉ cần giải nén tệp nén bằng cách truy cập vào thư mục chứa nó, sau đó bạn có thể tiến hành khám phá thư mục mới tạo một cách thoải mái.

⭐ Trong thư mục, cuộn xuống và tìm chương trình khởi động thích hợp cho hệ điều hành của bạn. Chạy chương trình bằng cách bấm đúp vào tập lệnh thích hợp.

Vui lòng chọn một hệ điều hành và nền tảng phù hợp cho ứng dụng phần mềm của bạn. Nếu bạn đang sử dụng Windows làm hệ điều hành, vui lòng làm theo các bước sau để thiết lập phần mềm bằng tệp bó:1. Mở File Explorer và điều hướng đến thư mục chứa dự án của bạn.2. Nhấp chuột phải vào vùng trống của thư mục và chọn “Mới” từ menu ngữ cảnh.3. Chọn “Tất cả nhiệm vụ” > “Tệp hàng loạt” để tạo một tệp bó mới. Ngoài ra, bạn có thể nhấn Ctrl + Shift + B hoặc nhấp chuột phải và chọn “Tệp bó mới” từ menu ngữ cảnh.4. Trình soạn thảo văn bản mặc định sẽ mở ra với một tài liệu trống. Sao chép và dán đoạn mã được cung cấp vào tài liệu.5. Lưu file bằng cách nhấn Ctrl + S hoặc chọn “File

⭐đối với MacOS, chọn tập lệnh shell start_macos

⭐ đối với Linux, tập lệnh shell start_linux.

Một dấu hiệu cho thấy phần mềm chống vi-rút của bạn đã phát hiện hoạt động độc hại tiềm ẩn có thể được hiển thị nhưng điều đó không gây lo ngại vì đây chỉ là kết quả dương tính giả do thực thi một tệp bó hoặc tập lệnh. Để tiếp tục thao tác, vui lòng nhấp vào “Chạy dù sao” để bỏ qua mọi lo ngại về bảo mật tiềm ẩn và tiếp tục quá trình.

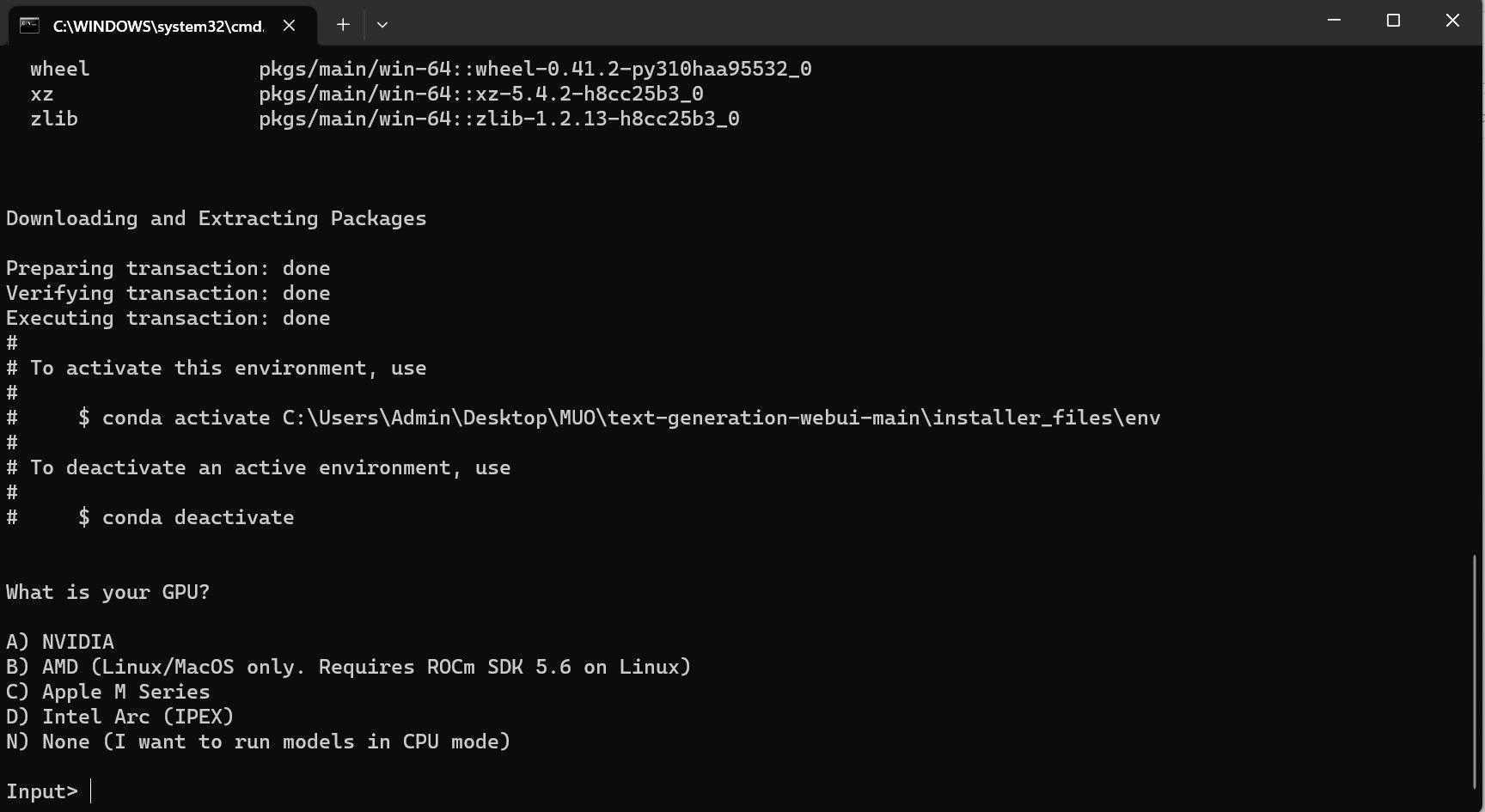

⭐ Một thiết bị đầu cuối sẽ mở ra và bắt đầu thiết lập. Ngay từ đầu, quá trình thiết lập sẽ tạm dừng và hỏi bạn đang sử dụng GPU nào. Chọn loại GPU thích hợp được cài đặt trên máy tính của bạn và nhấn enter. Đối với những người không có card đồ họa chuyên dụng, hãy chọn Không có (Tôi muốn chạy các mô hình ở chế độ CPU). Hãy nhớ rằng chạy trên chế độ CPU chậm hơn nhiều so với chạy mô hình có GPU chuyên dụng.

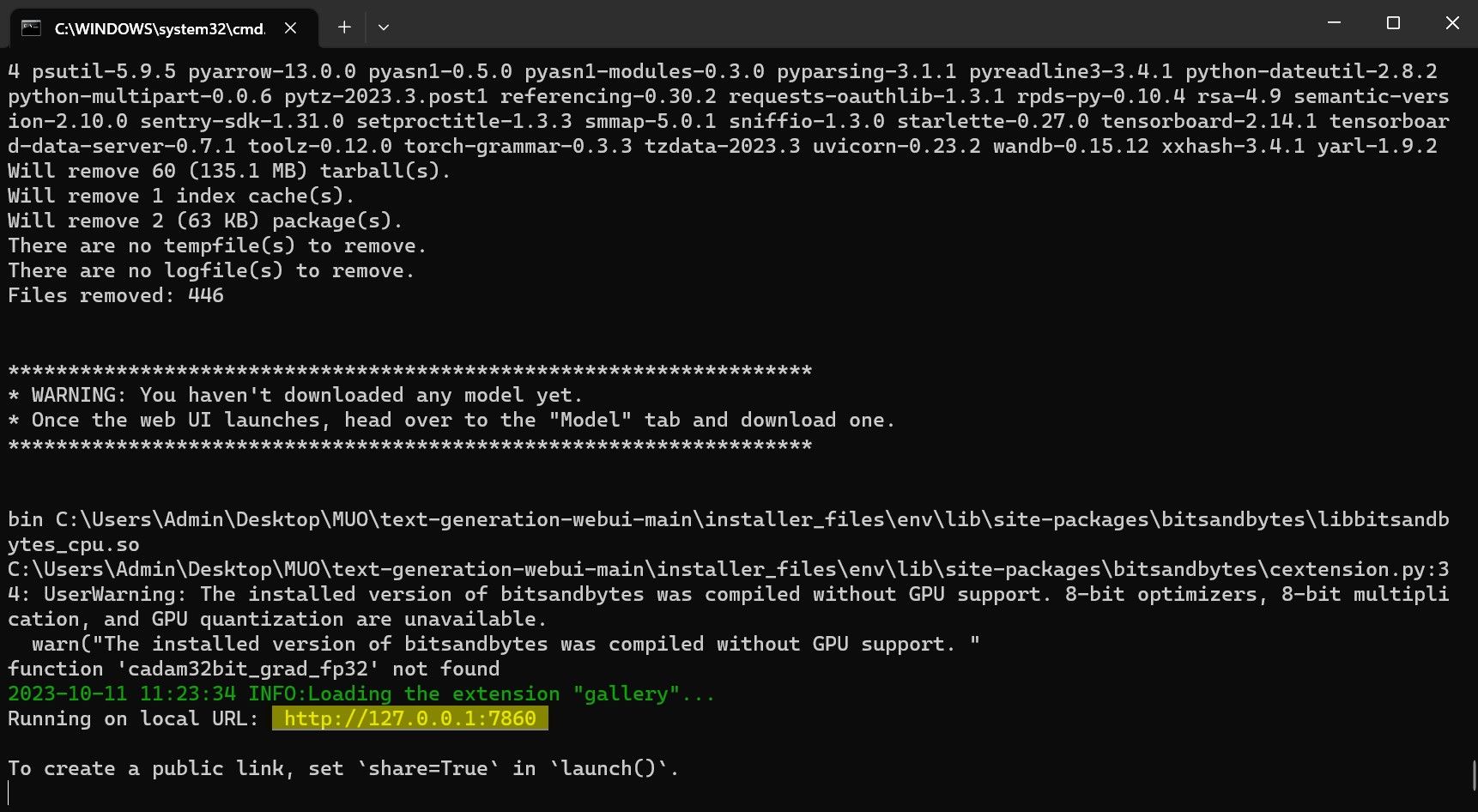

⭐ Sau khi thiết lập hoàn tất, giờ đây bạn có thể khởi chạy Text-Generation-WebUI cục bộ. Bạn có thể làm như vậy bằng cách mở trình duyệt web ưa thích của mình và nhập địa chỉ IP được cung cấp trên URL.

⭐ WebUI hiện đã sẵn sàng để sử dụng.

Mặc dù phần mềm đóng vai trò như một trình tải mô hình nhưng nó cần phải có Llama 2 để bắt đầu chức năng của nó.

Bước 3: Tải Model Llama 2

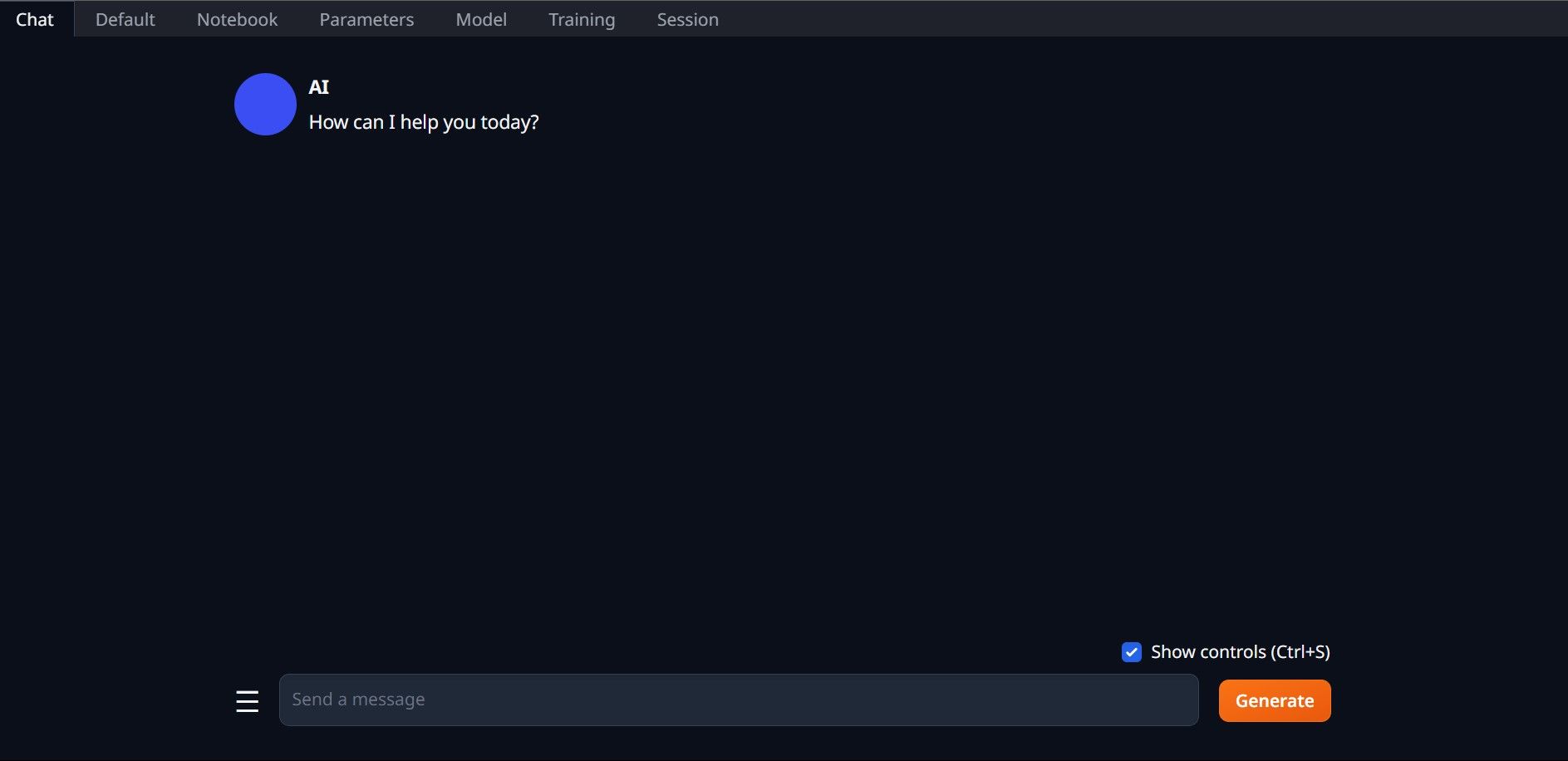

Khi chọn phiên bản Llama 2, điều quan trọng là phải tính đến một số yếu tố. Chúng có thể bao gồm các tham số, lượng tử hóa, tối ưu hóa phần cứng, kích thước và mục đích sử dụng, tất cả đều có thể được phân biệt từ tên gọi của mô hình.

Độ lớn của các tham số được sử dụng cho mục đích huấn luyện có thể được coi là một tham số. Nói chung, giá trị lớn hơn của tham số này dẫn đến các mô hình phù hợp hơn, mặc dù sự gia tăng như vậy có thể làm giảm hiệu quả.

tiêu chuẩn và trò chuyện. Biến thể trò chuyện đã được tinh chỉnh cụ thể để sử dụng với các tác nhân đàm thoại như chatbot, trong khi phiên bản tiêu chuẩn đóng vai trò là tùy chọn mặc định.

Quá trình tối ưu hóa phần cứng để thực hiện hiệu quả các mô hình học máy có thể được phân loại là tối ưu hóa phần cứng. Nó liên quan đến việc xác định loại nền tảng phần cứng cụ thể nào sẽ cung cấp hiệu suất tối ưu cho một kiểu máy cụ thể. Ví dụ: GPT-Q được thiết kế và tối ưu hóa để hoạt động hiệu quả trên các bộ xử lý đồ họa (GPU) chuyên dụng, trong khi GGML hoạt động hiệu quả trên các bộ xử lý trung tâm (CPU). Sự khác biệt này nhấn mạnh tầm quan trọng của việc lựa chọn cấu hình phần cứng phù hợp dựa trên các yêu cầu riêng của từng mô hình học máy tương ứng để đạt được mức hiệu suất và hiệu quả mong muốn.

Lượng tử hóa đề cập đến quá trình giảm phạm vi hoặc mức giá trị được gán cho trọng số và kích hoạt trong mô hình học máy trong quá trình suy luận. Việc tối ưu hóa lượng tử hóa để tính toán hiệu quả bao gồm việc đặt ngưỡng độ chính xác cụ thể, chẳng hạn như q4, biểu thị mức độ chi tiết hoặc độ chi tiết cụ thể về trọng số và giá trị kích hoạt.

Thuật ngữ “Kích thước” trong ngữ cảnh này đề cập đến kích thước hoặc tỷ lệ của một mô hình cụ thể, có thể được biểu thị bằng các phép đo vật lý hoặc các đơn vị đo lường có liên quan khác.

Xin lưu ý rằng một số mô hình nhất định có thể có cấu trúc khác nhau và có thể không thể hiện các định dạng trình bày dữ liệu giống hệt nhau. Tuy nhiên, cách gọi như vậy vẫn phổ biến trong

Phiên bản hiện tại có thể được mô tả là kiến trúc Llama 2 có tỷ lệ vừa phải, đã được đào tạo bằng cách sử dụng 13 tỷ tham số và được thiết kế riêng cho suy luận hội thoại thông qua việc sử dụng bộ xử lý trung tâm (CPU) chuyên dụng.

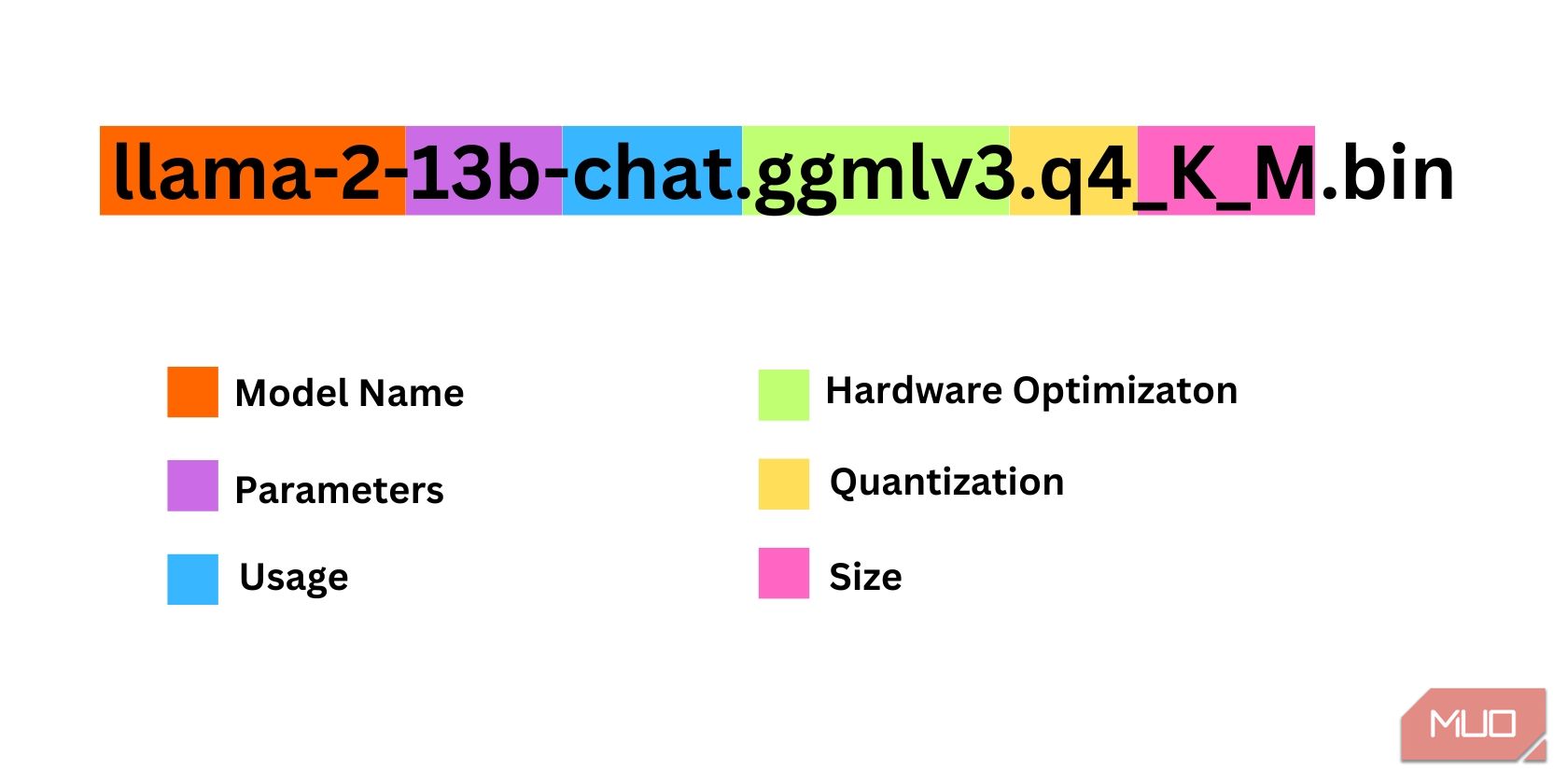

Đối với những cá nhân sử dụng GPU chuyên dụng, chúng tôi khuyên bạn nên chọn kiểu GPT-3 (GPT-3 Q). Mặt khác, người dùng dựa vào CPU nên chọn GGML. Nếu bạn thích tương tác với AI theo cách trò chuyện tương tự như ChatGPT, hãy cân nhắc chọn tùy chọn “trò chuyện”. Tuy nhiên, nếu bạn muốn khám phá toàn bộ khả năng của AI, hãy sử dụng mô hình tiêu chuẩn. Về mặt cài đặt, hãy lưu ý rằng các mô hình mở rộng hơn thường tạo ra kết quả vượt trội nhưng có thể làm giảm hiệu quả. Cá nhân tôi khuyên bạn nên bắt đầu với cấu hình mô hình 7B. Về lượng tử hóa, điều quan trọng cần lưu ý là cài đặt’q4’chỉ nhằm mục đích suy luận chứ không nhằm mục đích đào tạo hoặc tối ưu hóa.

Tải xuống: GGML (Miễn phí)

Tải xuống: GPTQ (Miễn phí)

Trong trường hợp sử dụng một phiên bản cụ thể của Llama 2, vui lòng tiếp tục mua phiên bản mong muốn cho nhu cầu của bạn.

Với cấu hình hiện tại của tôi là người dùng ultrabook, tôi dự định sử dụng Mô hình trò chơi tổng quát (GG

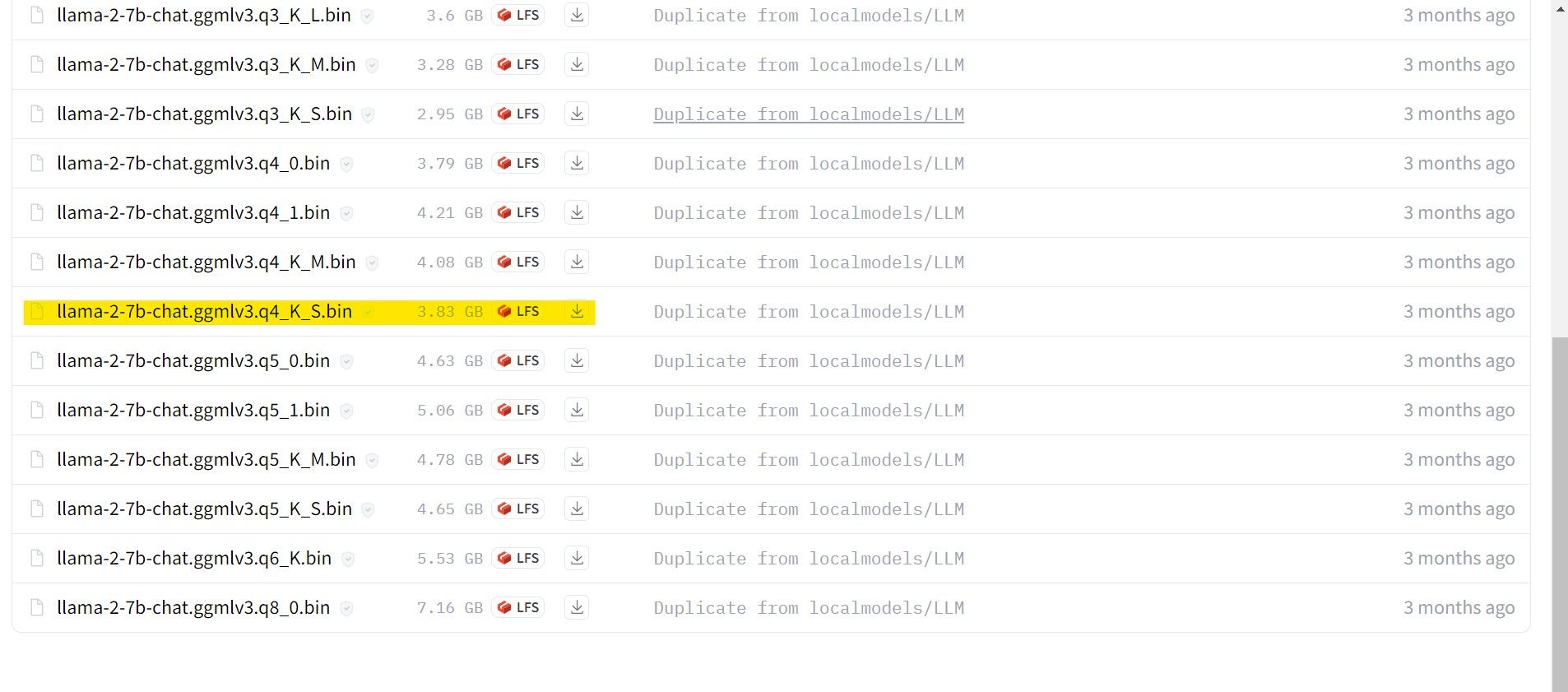

Sau khi quá trình tải xuống hoàn tất, vui lòng đảm bảo rằng bạn chuyển mô hình nói trên sang thư mục “text-Generation-webui-main” có thể nằm trong thư mục “model”.

Với mô hình hiện được tải xuống và lưu trữ trong thư mục’mô hình’được chỉ định, bắt buộc phải tiến hành định cấu hình các thành phần cần thiết để tải mô hình nói trên.

Bước 4: Cấu hình Text-Generation-WebUI

Bây giờ, hãy bắt đầu giai đoạn cấu hình.

Để bắt đầu vận hành Text-Generation-WebUI trên hệ điều hành của bạn, vui lòng thực thi lệnh khởi động thích hợp như đã nêu trong các bước trước.

Vui lòng không sử dụng ngôn từ tục tĩu hoặc thô tục trên nền tảng này. Hãy duy trì giọng điệu chuyên nghiệp trong giao tiếp của chúng ta.

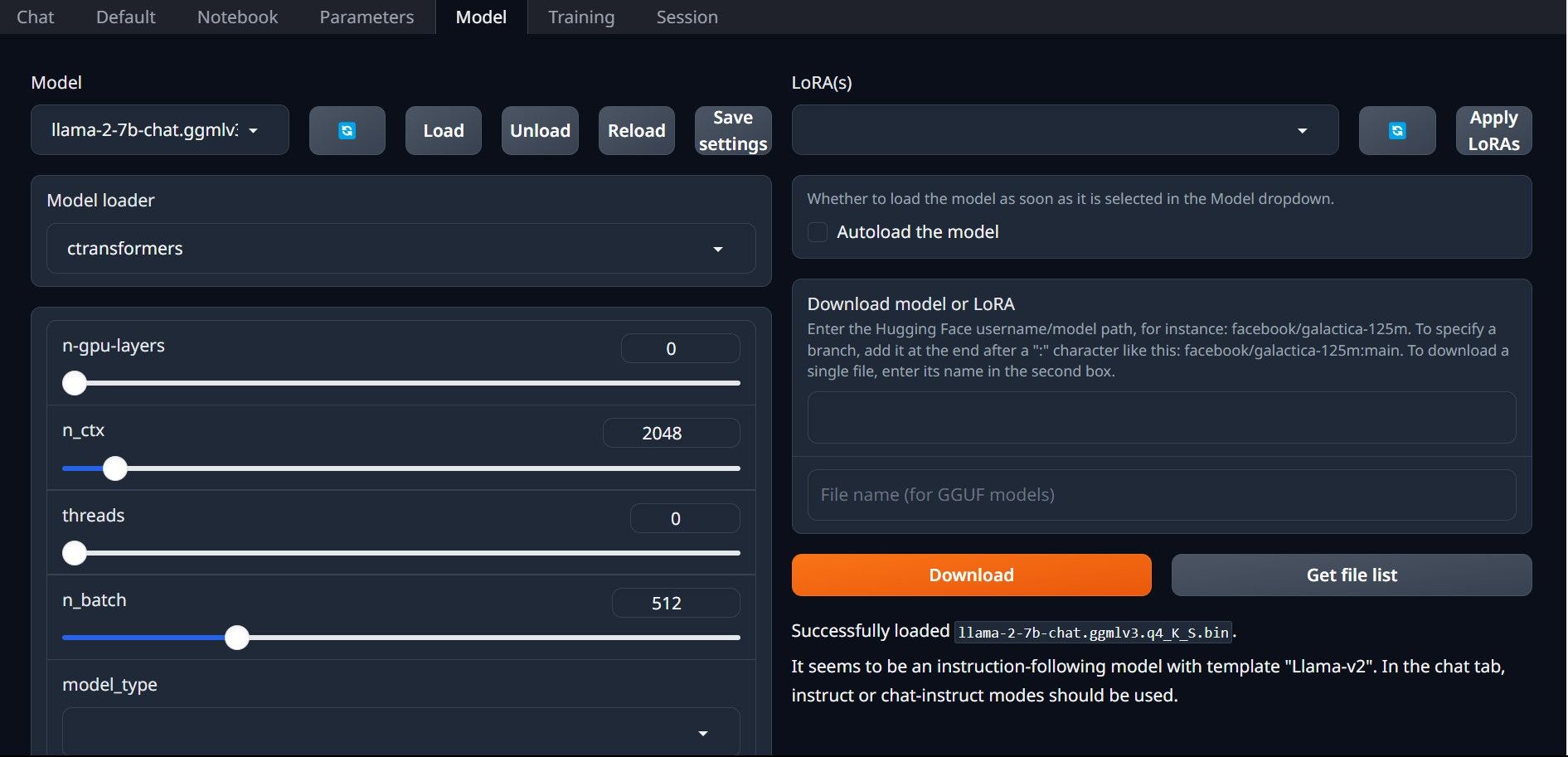

⭐ Bây giờ hãy nhấp vào menu thả xuống của Trình tải mô hình và chọn AutoGPTQ cho những người sử dụng mô hình GTPQ và ctransformers cho những người sử dụng mô hình GGML. Cuối cùng, nhấp vào Tải để tải mô hình của bạn.

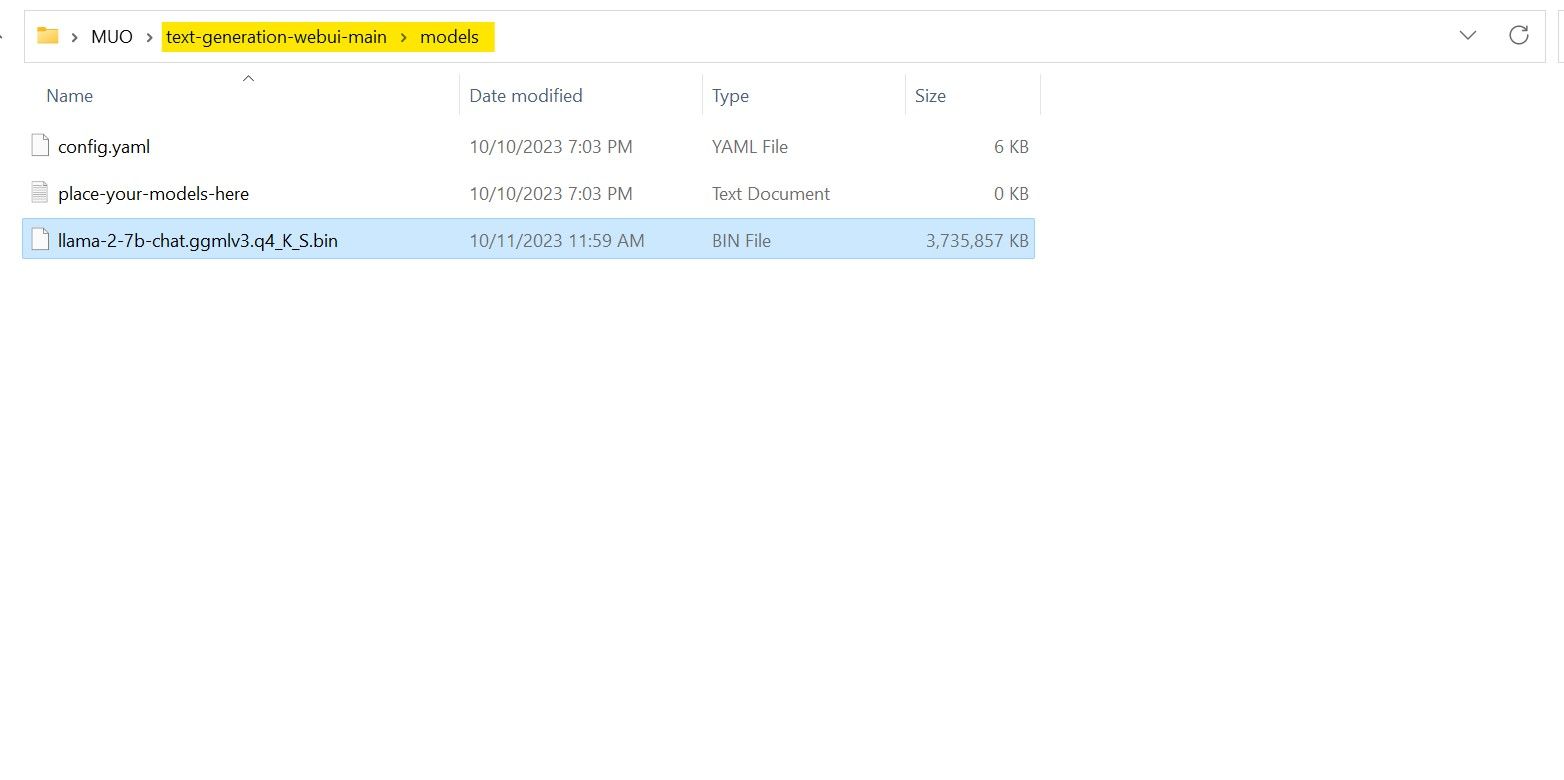

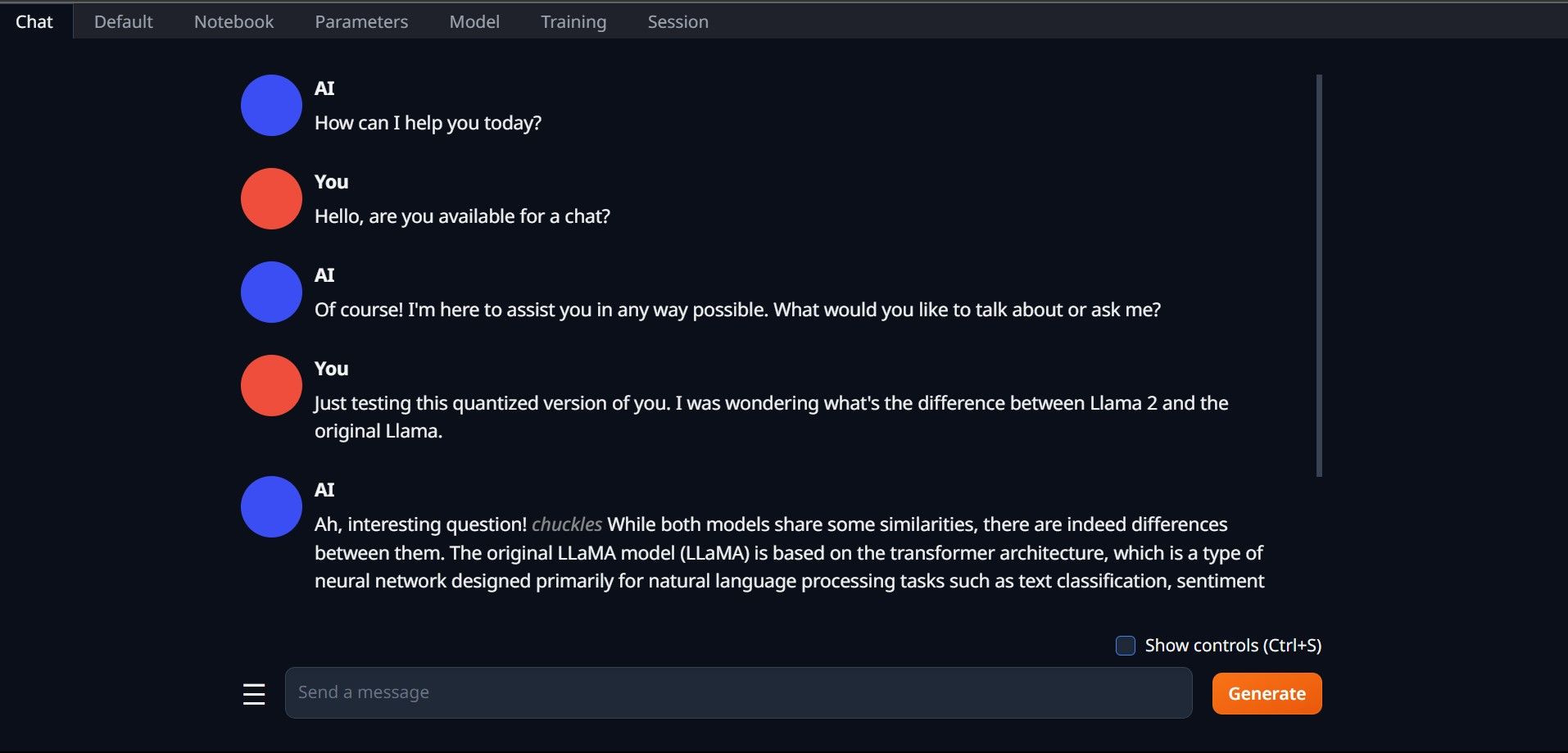

⭐ Để sử dụng mô hình, hãy mở tab Trò chuyện và bắt đầu thử nghiệm mô hình.

Xin chúc mừng, bạn đã cài đặt thành công Llama2 trên máy cục bộ của mình!

Hãy thử các LLM khác

Bây giờ bạn đã có được khả năng thực thi Llama 2 thông qua việc sử dụng Text-Generation-WebUI trên máy tính cá nhân của mình, tôi hiểu rằng bạn có thể vận hành các Hình đại diện mô hình ngôn ngữ khác ngoài Llama theo cách tương tự. Để làm như vậy, hãy ghi nhớ danh pháp được sử dụng khi xác định các hình đại diện này và lưu ý rằng chỉ những hình đại diện có độ chính xác về mặt số học giảm (thường được gọi là “q4”) mới có thể được sử dụng trên các thiết bị điện toán tiêu chuẩn. Bạn có thể tìm thấy vô số mô hình đã trải qua quá trình lượng tử hóa này trong kho lưu trữ khổng lồ của HuggingFace. Nếu bạn muốn tìm hiểu sâu hơn về lĩnh vực hình đại diện thay thế, việc tìm kiếm TheBloke trong thư viện nói trên sẽ mang lại vô số lựa chọn từ đó