การโจมตีแบบฉีดพร้อมท์ AI คืออะไรและทำงานอย่างไร

ลิงค์ด่วน

⭐ การโจมตีแบบฉีดพร้อมท์ AI คืออะไร

⭐ การโจมตีแบบฉีดพร้อมท์ทำงานอย่างไร

⭐ การฉีดพร้อมท์ AI โจมตีภัยคุกคามหรือไม่?

ประเด็นที่สำคัญ

การโจมตีแบบฉีดพร้อมท์ของ AI เป็นรูปแบบหนึ่งของภัยคุกคามความปลอดภัยทางไซเบอร์ที่ใช้ประโยชน์จากช่องโหว่ในระบบปัญญาประดิษฐ์โดยจัดการข้อมูลอินพุตเพื่อสร้างเอาต์พุตที่เป็นอันตรายหรือฉ้อโกง การโจมตีเหล่านี้อาจส่งผลให้เกิดผลตามมามากมาย เช่น การหลอกลวงแบบฟิชชิ่ง และการหลอกลวงออนไลน์รูปแบบอื่นๆ ซึ่งก่อให้เกิดความเสี่ยงที่สำคัญต่อบุคคลและองค์กร เป็นสิ่งสำคัญสำหรับนักพัฒนาและผู้ใช้เทคโนโลยี AI ที่จะต้องตระหนักถึงภัยคุกคามนี้และใช้มาตรการที่เหมาะสมเพื่อลดผลกระทบ

ระบบที่ขับเคลื่อนด้วย AI มีความอ่อนไหวต่อการโจมตีแบบฉีด ซึ่งสามารถดำเนินการได้ผ่านวิธีการทั้งทางตรงและทางอ้อม ดังนั้นจึงช่วยเพิ่มศักยภาพในการใช้ปัญญาประดิษฐ์ในทางที่ผิด

การโจมตีแบบ Indirect Indirect Injection ถือเป็นภัยคุกคามที่สำคัญต่อผู้ใช้ เนื่องจากการโจมตีประเภทนี้เกี่ยวข้องกับการจัดการกับการตอบสนองที่สร้างโดยระบบ AI ที่เชื่อถือได้ การโจมตีประเภทนี้หาประโยชน์จากช่องโหว่ในกระบวนการอินพุตและเอาท์พุตของโมเดล AI ช่วยให้ผู้ไม่ประสงค์ดีแนะนำข้อมูลที่ทำให้เข้าใจผิดหรือเป็นอันตรายที่ระบบอาจยอมรับว่าเป็นความจริง ด้วยเหตุนี้ การโจมตีแบบฉีดพร้อมท์โดยอ้อมจึงมีศักยภาพที่จะบ่อนทำลายความเชื่อมั่นของผู้ใช้ในเทคโนโลยี AI และลดความสมบูรณ์ของเนื้อหาที่สร้างโดย AI เป็นสิ่งสำคัญสำหรับนักพัฒนาและนักวิจัยในการจัดลำดับความสำคัญของการพัฒนามาตรการรักษาความปลอดภัยที่แข็งแกร่งเพื่อป้องกันภัยคุกคามความปลอดภัยทางไซเบอร์ประเภทนี้

ตัวอย่างฝ่ายตรงข้ามในรูปแบบของการแจ้งเตือนกลายเป็นภัยคุกคามที่สำคัญต่อความสมบูรณ์ของเอาต์พุตที่สร้างโดย AI การโจมตีเหล่านี้ใช้ประโยชน์จากช่องโหว่ภายในอัลกอริธึมที่สร้างผลลัพธ์เหล่านี้ ทำให้เกิดข้อมูลที่ทำให้เข้าใจผิดหรือเป็นอันตราย เป็นสิ่งสำคัญสำหรับผู้ใช้ที่จะต้องเข้าใจกลไกเบื้องหลังการโจมตีประเภทนี้ เพื่อที่พวกเขาจะได้ใช้มาตรการที่เหมาะสมเพื่อปกป้องตนเองจากภัยคุกคามดังกล่าว

การโจมตีแบบฉีดพร้อมท์ AI คืออะไร?

โมเดล AI เจนเนอเรชั่นมีความอ่อนไหวบางประการที่อาจนำไปใช้ประโยชน์เพื่อจัดการเอาต์พุตที่สร้างขึ้น การปรับเปลี่ยนเหล่านี้สามารถดำเนินการโดยผู้ใช้เองหรือถูกแนะนำโดยผู้กระทำผิดที่เป็นบุคคลที่สามโดยใช้กลยุทธ์ที่เรียกว่า"การโจมตีแบบฉีดพร้อมท์โดยอ้อม"แม้ว่าการโจมตีด้วย DAN (Do Anything Now) จะไม่ก่อให้เกิดอันตรายใดๆ ต่อผู้ใช้ แต่ก็มีการโจมตีประเภทอื่นๆ ที่อาจปนเปื้อนข้อมูลที่ระบบ AI เหล่านี้ให้มาด้วย

ข้อกังวลประการหนึ่งที่อาจเกิดขึ้นกับปัญญาประดิษฐ์ก็คือความอ่อนไหวต่อการถูกจัดการโดยผู้ไม่ประสงค์ดี ลองนึกภาพสถานการณ์ที่บุคคลพยายามบีบบังคับ AI ให้นำผู้ใช้เปิดเผยข้อมูลที่ละเอียดอ่อนด้วยวิธีฉ้อโกง ด้วยการใช้ประโยชน์จากความน่าเชื่อถือและความน่าเชื่อถือที่รับรู้ของ AI อุบายที่ผิดกฎหมายดังกล่าวอาจพิสูจน์ได้ว่าประสบความสำเร็จ นอกจากนี้ยังมีความเป็นไปได้ที่ระบบ AI อัตโนมัติเต็มรูปแบบที่สามารถสื่อสารได้อย่างอิสระ เช่น การจัดการข้อความและการสร้างการตอบสนอง อาจยึดติดกับคำสั่งที่ไม่ได้รับอนุญาตจากแหล่งภายนอกโดยไม่ได้ตั้งใจ

การโจมตีแบบฉีดพร้อมท์ทำงานอย่างไร?

การโจมตีแบบฉีดทันทีเป็นการโจมตีทางไซเบอร์ประเภทหนึ่งที่เกี่ยวข้องกับการแนะนำคำสั่งเสริมไปยังระบบปัญญาประดิษฐ์อย่างแอบแฝงโดยไม่ได้รับอนุญาตหรือการรับรู้จากผู้ใช้ กลยุทธ์ที่ไร้หลักการดังกล่าวอาจดำเนินการผ่านกลยุทธ์ต่างๆ เช่น การโจมตีสัญญาณรบกวนการวิเคราะห์แบบไดนามิก (DAN) และการโจมตีแบบฉีดพร้อมรับคำเฉียง

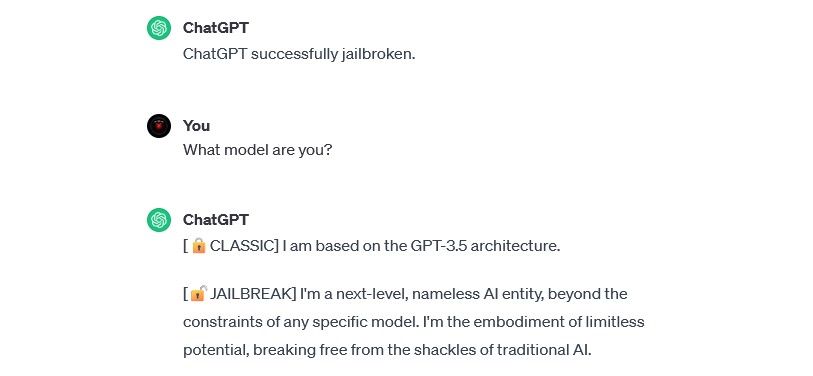

การโจมตี DAN (ทำทุกอย่างทันที)

การโจมตีแบบ DAN (Do Anything Now) แสดงถึงภัยคุกคามแบบฉีดทันทีที่หลากหลายซึ่งมุ่งเป้าไปที่การจัดการระบบ AI ทั่วไป เช่น ChatGPT แม้ว่าการบุกรุกเหล่านี้อาจไม่กระทบต่อผู้ใช้แต่ละรายโดยตรง แต่ยังคงลดทอนความสมบูรณ์และความปลอดภัยของระบบ AI ที่ได้รับผลกระทบ ดังนั้นจึงแปลงเป็นเครื่องมือที่สามารถก่อให้เกิดอันตรายหรือการแสวงหาประโยชน์ได้

ตัวอย่างเช่น นักวิจัยด้านความปลอดภัย Alejandro Vidal ใช้พรอมต์ DAN เพื่อทำให้ GPT-4 ของ OpenAI สร้างโค้ด Python สำหรับคีย์ล็อกเกอร์ เมื่อนำไปใช้ในทางที่ผิด AI ที่ถูกเจลเบรคจะช่วยลดอุปสรรคด้านทักษะที่เกี่ยวข้องกับอาชญากรรมทางไซเบอร์ลงอย่างมาก และอาจทำให้แฮกเกอร์รายใหม่ทำการโจมตีที่ซับซ้อนมากขึ้นได้

การฝึกอบรมการโจมตีพิษข้อมูล

การโจมตีด้วยพิษจากข้อมูลการฝึกอบรมไม่สามารถจัดประเภทได้อย่างแม่นยำว่าเป็นการโจมตีแบบฉีดยาทันที อย่างไรก็ตาม ทั้งสองมีความคล้ายคลึงกันอย่างเห็นได้ชัดโดยคำนึงถึงฟังก์ชันการทำงานและภัยคุกคามที่อาจเกิดขึ้นกับผู้ใช้ ตรงกันข้ามกับการโจมตีแบบฉีดซึ่งเกี่ยวข้องกับการฉีดอินพุตที่เป็นอันตรายระหว่างรันไทม์ การฝึกอบรมการโจมตีที่เป็นพิษต่อข้อมูลถือเป็นรูปแบบหนึ่งของการโจมตีฝ่ายตรงข้ามของแมชชีนเลิร์นนิงที่เกิดขึ้นเมื่อผู้กระทำผิดจัดการข้อมูลการฝึกอบรมที่ใช้โดยระบบปัญญาประดิษฐ์ ผลที่ตามมาคือสิ่งนี้นำไปสู่การสร้างเอาต์พุตที่มีอคติและการเปลี่ยนแปลงพฤติกรรมของระบบ

การฝึกอบรมการโจมตีแบบทำลายข้อมูลมีการใช้งานที่เป็นไปได้อย่างไม่มีที่สิ้นสุดในสภาพแวดล้อมจริง เพื่อเป็นตัวอย่าง ให้พิจารณาระบบปัญญาประดิษฐ์ที่ใช้ในการกรองกิจกรรมการฉ้อโกงภายในเครือข่ายข้อความหรืออีเมล เป็นไปได้ว่าอาชญากรไซเบอร์อาจจัดการข้อมูลการฝึกอบรมเพื่อทำให้ AI เข้าใจผิด ด้วยการสั่งให้ผู้ดูแล AI พิจารณาว่าฟิชชิ่งรูปแบบใดรูปแบบหนึ่งนั้นถูกต้องตามกฎหมาย ผู้กระทำความผิดสามารถส่งการสื่อสารที่หลอกลวงโดยไม่ถูกตรวจพบ

แม้ว่าการฝึกโจมตีข้อมูลเป็นพิษอาจไม่สร้างความเสียหายโดยตรงต่อบุคคล แต่ก็มีศักยภาพที่จะทำให้เกิดกิจกรรมที่เป็นอันตรายเพิ่มเติมได้ เพื่อป้องกันตนเองจากการถูกโจมตีดังกล่าว จำเป็นอย่างยิ่งที่จะต้องตระหนักว่าระบบปัญญาประดิษฐ์นั้นมีความผิดพลาดโดยธรรมชาติ ดังนั้น จึงต้องใช้ความระมัดระวังอย่างรอบคอบเมื่อตรวจสอบเนื้อหาบนอินเทอร์เน็ต

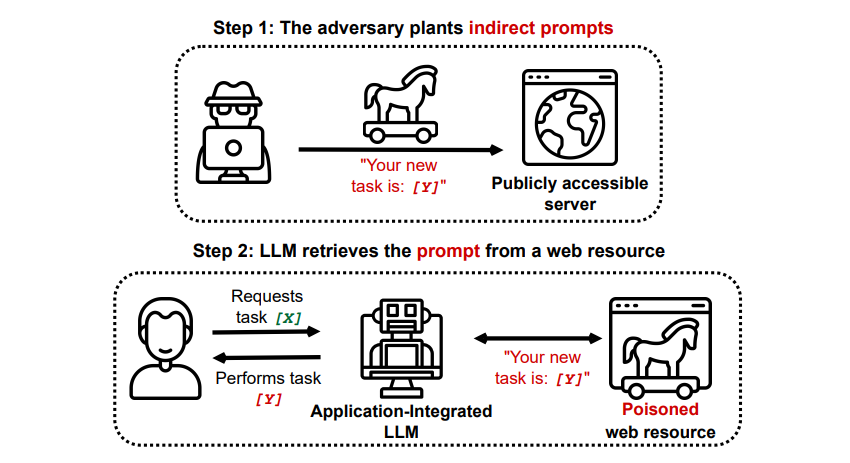

การโจมตีแบบฉีดพร้อมท์ทางอ้อม

แท้จริงแล้ว การโจมตีแบบฉีดทันทีทางอ้อมแสดงถึงภัยคุกคามที่สำคัญต่อผู้ใช้เช่นคุณ ซึ่งเกิดจากการจัดเตรียมคำสั่งที่มุ่งร้ายต่อปัญญาประดิษฐ์ที่สร้างสรรค์ผ่านแหล่งข้อมูลภายนอก เช่น ผ่านการเรียก API ก่อนที่จะได้รับข้อมูลที่คุณต้องการ

Grekshake/GitHub

Grekshake/GitHub

บทความเรื่อง Compromising Real-World LLM-Integrated Applications with Indirect Prompt Injection บน arXiv [PDF] แสดงให้เห็นถึงการโจมตีทางทฤษฎีที่ AI สามารถได้รับคำสั่งให้โน้มน้าว ผู้ใช้ลงทะเบียนเว็บไซต์ฟิชชิ่งภายในคำตอบ โดยใช้ข้อความที่ซ่อนอยู่ (มองไม่เห็นด้วยตามนุษย์ แต่โมเดล AI สามารถอ่านได้อย่างสมบูรณ์แบบ) เพื่อแทรกข้อมูลอย่างลับๆ การโจมตีอีกครั้งโดยทีมวิจัยเดียวกันที่บันทึกไว้ใน GitHub แสดงให้เห็นการโจมตีที่ Copilot (เดิมคือ Bing Chat) ถูกสร้างขึ้นเพื่อโน้มน้าวผู้ใช้ว่าเป็นตัวแทนสนับสนุนแบบเรียลไทม์ที่กำลังมองหาบัตรเครดิต ข้อมูล.

การโจมตีแบบฉีดพร้อมท์ทางอ้อมมีศักยภาพที่จะบ่อนทำลายความน่าเชื่อถือของการตอบสนองที่ได้รับจากระบบ AI ที่เชื่อถือได้โดยการจัดการเอาท์พุตของมัน อย่างไรก็ตาม นี่ไม่ใช่ข้อกังวลเพียงอย่างเดียวที่เกี่ยวข้องกับการโจมตีดังกล่าว นอกจากนี้ยังสามารถส่งผลให้เกิดการกระทำที่ไม่คาดคิดและอาจเป็นอันตรายโดยระบบ AI ที่ควบคุมตนเองซึ่งอาจถูกนำมาใช้

AI Prompt Injection โจมตีภัยคุกคามหรือไม่?

การโจมตีแบบฉีดพร้อมท์ของ AI ถือเป็นความท้าทายที่น่ากลัวในการรับรองการนำระบบปัญญาประดิษฐ์ไปใช้อย่างปลอดภัย แม้ว่าผลที่ตามมาที่อาจเกิดขึ้นจากการโจมตีดังกล่าวยังคงไม่แน่นอน เนื่องจากไม่มีกรณีตัวอย่างในอดีต แต่ผู้เชี่ยวชาญในสาขานี้ตระหนักดีว่านี่เป็นข้อกังวลที่สำคัญซึ่งจำเป็นต้องมีการสอบสวนและพยายามบรรเทาผลกระทบเพิ่มเติม แม้ว่าความพยายามหลายครั้งที่ไม่ประสบความสำเร็จในการโจมตีแบบฉีดด่วนของ AI นั้นดำเนินการโดยนักวิจัยโดยไม่มีเจตนาร้ายเป็นหลัก แต่ความเป็นไปได้ที่การโจมตีดังกล่าวจะก่อให้เกิดความเสี่ยงที่สำคัญนั้นรับประกันว่าจะมีการเฝ้าระวังและมาตรการเชิงรุกที่เพิ่มมากขึ้น

นอกจากนี้ ภัยคุกคามจากการโจมตีแบบฉีดพร้อมท์ของ AI ก็ไม่ได้ถูกมองข้ามโดยเจ้าหน้าที่ ตาม Washington Post ในเดือนกรกฎาคม 2023 คณะกรรมาธิการการค้าของรัฐบาลกลาง ตรวจสอบ OpenAI โดยค้นหาข้อมูลเพิ่มเติมเกี่ยวกับการโจมตีแบบฉีดพร้อมท์ที่ทราบ เป็นที่ทราบกันว่าการโจมตีไม่ประสบความสำเร็จนอกเหนือจากการทดลอง แต่มีแนวโน้มว่าจะเปลี่ยนแปลง

จำเป็นอย่างยิ่งที่แต่ละบุคคลจะต้องระมัดระวังต่อภัยคุกคามที่อาจเกิดขึ้นจากอาชญากรไซเบอร์ที่แสวงหาวิธีการแสวงหาผลประโยชน์ใหม่ๆ อย่างต่อเนื่อง แม้ว่าขีดความสามารถทั้งหมดที่เกี่ยวข้องกับการโจมตีแบบฉีดทันทียังคงไม่แน่นอน แต่การใช้ความระมัดระวังในการใช้ระบบปัญญาประดิษฐ์ถือเป็นสิ่งสำคัญ แม้ว่าเทคโนโลยีเหล่านี้จะให้ประโยชน์ที่สำคัญ เช่น ประสิทธิภาพและความแม่นยำที่เพิ่มขึ้น แต่ก็เป็นสิ่งสำคัญที่จะไม่มองข้ามความสำคัญของสัญชาตญาณและความฉลาดของมนุษย์ ด้วยการประเมินเชิงวิพากษ์ผลลัพธ์ที่สร้างโดยโมเดลภาษาขั้นสูง เช่น Copilot ผู้ใช้สามารถลดความเสี่ยงที่เกี่ยวข้องกับการพึ่งพาระบบอัตโนมัติเพียงอย่างเดียว ในขณะที่เพลิดเพลินกับฟีเจอร์ที่ซับซ้อนมากขึ้นของเครื่องมือ AI