วิธีดาวน์โหลดและติดตั้ง Llama 2 ในเครื่อง

Meta เปิดตัว Llama 2 ในช่วงฤดูร้อนของ Llama เวอร์ชันใหม่ได้รับการปรับแต่งอย่างละเอียดด้วยโทเค็นมากกว่าโมเดล Llama ดั้งเดิมถึง 40% ซึ่งเพิ่มความยาวบริบทเป็นสองเท่าและมีประสิทธิภาพเหนือกว่าโมเดลโอเพ่นซอร์สอื่น ๆ ที่มีอยู่อย่างมาก วิธีที่เร็วและง่ายที่สุดในการเข้าถึง Llama 2 คือผ่าน API ผ่านแพลตฟอร์มออนไลน์ อย่างไรก็ตาม หากคุณต้องการประสบการณ์ที่ดีที่สุด การติดตั้งและโหลด Llama 2 บนคอมพิวเตอร์ของคุณโดยตรงจะดีที่สุด

เมื่อคำนึงถึงข้อนี้แล้ว เราได้พัฒนาบทช่วยสอนที่ครอบคลุมซึ่งสรุปขั้นตอนการใช้ Text-Generation-WebUI เพื่อดาวน์โหลดและเรียกใช้ Llama 2 Large Language Model (LLM) เชิงปริมาณบนคอมพิวเตอร์ส่วนบุคคลของคุณ

ทำไมต้องติดตั้ง Llama 2 ในเครื่อง

การเรียกใช้ Llama 2 โดยตรงอาจได้รับแรงบันดาลใจจากปัจจัยต่างๆ เช่น การพิจารณาความเป็นส่วนตัว ความปรารถนาในการปรับแต่ง และความจำเป็นในการใช้ฟังก์ชันออฟไลน์ อย่างไรก็ตาม หากมีใครมีส่วนร่วมในการวิจัย ปรับแต่ง หรือรวม Llama 2 ไว้ในงาน การใช้ API ของมันอาจไม่เหมาะสม วัตถุประสงค์หลักของการใช้โมเดล AI ในท้องถิ่น เช่น Llama 2 คือลดการพึ่งพาทรัพยากร AI ภายนอก ในขณะที่เพลิดเพลินกับความยืดหยุ่นในการใช้ปัญญาประดิษฐ์ได้ตลอดเวลาและทุกที่ โดยไม่ต้องกังวลเกี่ยวกับการรั่วไหลของข้อมูลที่อาจละเอียดอ่อนต่อองค์กรและหน่วยงานอื่น ๆ

เพื่อเริ่มต้นการสนทนาเกี่ยวกับกระบวนการติดตั้ง Llama 2 ในสภาพแวดล้อมท้องถิ่น ฉันขอนำเสนอคำแนะนำทีละขั้นตอนที่ละเอียดและคมชัดเพื่อให้งานนี้สำเร็จ

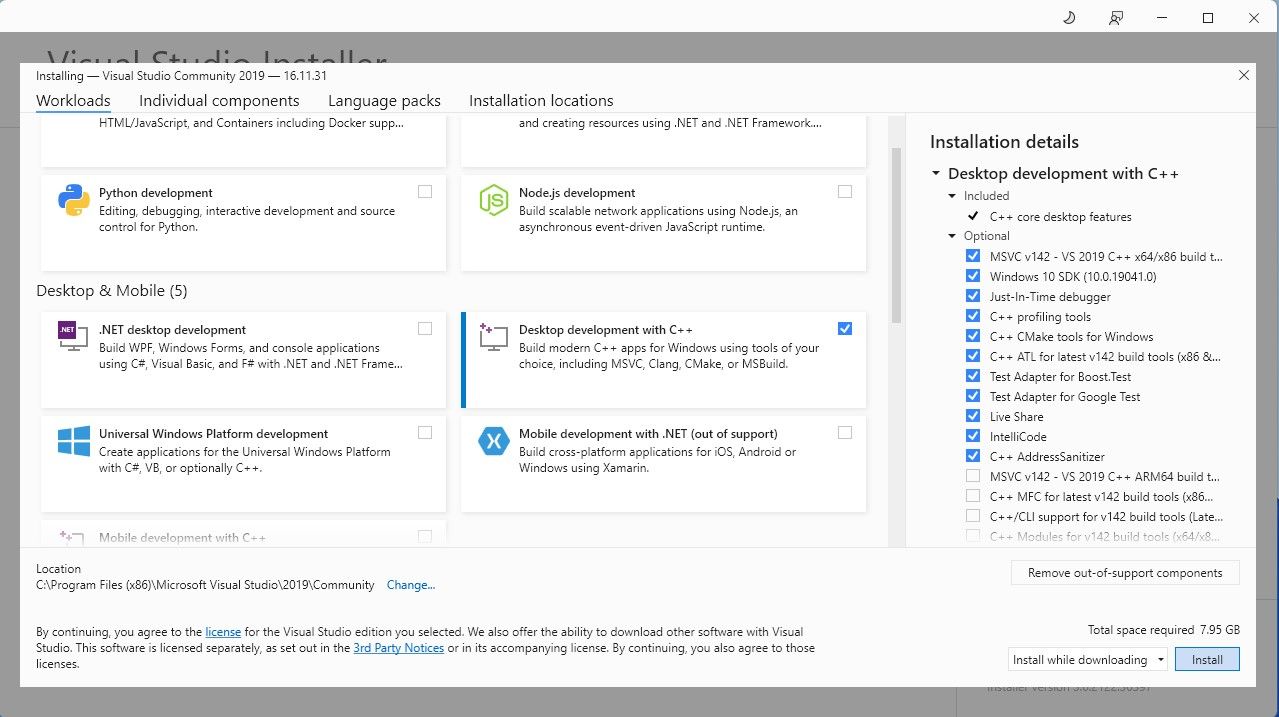

ขั้นตอนที่ 1: ติดตั้งเครื่องมือสร้าง Visual Studio 2019

เพื่อปรับปรุงกระบวนการนี้ เราได้ใช้แพ็คเกจการติดตั้งแบบคลิกเดียวสำหรับ Text-Generation-WebUI ซึ่งใช้ในการเชื่อมต่อกับ Llama 2 ผ่านอินเทอร์เฟซผู้ใช้แบบกราฟิก อย่างไรก็ตาม จำเป็นที่คุณจะต้องได้รับ Visual Studio 2019 Build Tools และติดตั้งส่วนประกอบที่จำเป็นก่อนดำเนินการติดตั้งแพ็คเกจดังกล่าว

ดาวน์โหลด: Visual Studio 2019 (ฟรี)

อย่าลังเลที่จะรับสำเนาซอฟต์แวร์เวอร์ชันชุมชนของเราโดยดาวน์โหลดทันที

⭐ ตอนนี้ติดตั้ง Visual Studio 2019 จากนั้นเปิดซอฟต์แวร์ เมื่อเปิดแล้ว ให้ทำเครื่องหมายที่ช่องการพัฒนาเดสก์ท็อปด้วย C\+\+ แล้วกดติดตั้ง

เมื่อการติดตั้งการพัฒนาเดสก์ท็อปด้วย C++ เสร็จสมบูรณ์ ให้ดำเนินการรับตัวติดตั้ง Text-Generation-WebUI ได้ในคลิกเดียวเพื่อประสบการณ์ที่ราบรื่น

ขั้นตอนที่ 2: ติดตั้ง Text-Generation-WebUI

ตัวติดตั้งแบบคลิกเดียว Text-Generation-WebUI เป็นสคริปต์ที่สร้างไดเร็กทอรีที่จำเป็นและกำหนดค่าสภาพแวดล้อม Conda พร้อมกับข้อกำหนดเบื้องต้นทั้งหมดสำหรับการรันโมเดลปัญญาประดิษฐ์ผ่านระบบอัตโนมัติ

หากต้องการรับสคริปต์ คุณสามารถดาวน์โหลดตัวติดตั้งแบบคลิกเดียวที่สะดวกได้โดยคลิกที่"รหัส"จากนั้นเลือก"ดาวน์โหลด ZIP"

ดาวน์โหลด: ตัวติดตั้ง Text-Generation-WebUI (ฟรี)

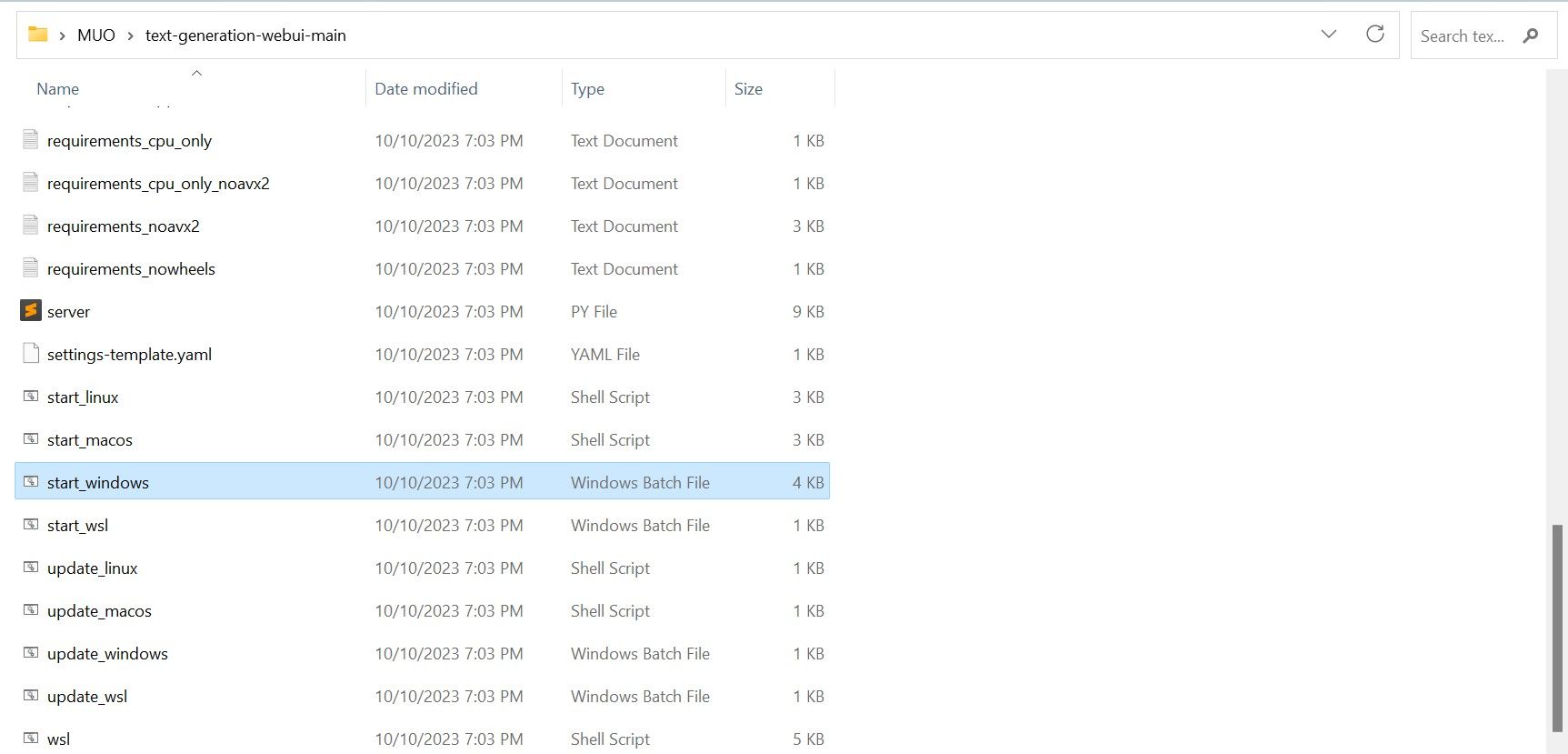

เมื่อดาวน์โหลดไฟล์ ZIP คุณสามารถเลือกคลายซิปและบันทึกเนื้อหาลงในไดเร็กทอรีที่คุณเลือกได้ ในการทำเช่นนั้น เพียงแตกไฟล์บีบอัดโดยการเข้าถึงโฟลเดอร์ที่มีไฟล์นั้น หลังจากนั้นคุณสามารถดำเนินการสำรวจโฟลเดอร์ที่สร้างขึ้นใหม่ได้ตามต้องการ

⭐ ภายในโฟลเดอร์ ให้เลื่อนลงและค้นหาโปรแกรมเริ่มต้นที่เหมาะสมสำหรับระบบปฏิบัติการของคุณ รันโปรแกรมโดยดับเบิลคลิกที่สคริปต์ที่เหมาะสม

โปรดเลือกระบบปฏิบัติการและแพลตฟอร์มที่เหมาะสมสำหรับแอปพลิเคชันซอฟต์แวร์ของคุณ หากคุณใช้ Windows เป็นระบบปฏิบัติการ โปรดทำตามขั้นตอนเหล่านี้เพื่อตั้งค่าซอฟต์แวร์ของคุณโดยใช้แบตช์ไฟล์:1. เปิด File Explorer และนำทางไปยังไดเร็กทอรีที่โปรเจ็กต์ของคุณตั้งอยู่2. คลิกขวาในพื้นที่ว่างของโฟลเดอร์และเลือก"ใหม่"จากเมนูบริบท3. เลือก “งานทั้งหมด” > “ไฟล์แบทช์” เพื่อสร้างไฟล์แบตช์ใหม่ หรือคุณสามารถกด Ctrl + Shift + B หรือคลิกขวาแล้วเลือก"ไฟล์แบตช์ใหม่"จากเมนูบริบท4. โปรแกรมแก้ไขข้อความเริ่มต้นจะเปิดขึ้นพร้อมกับเอกสารเปล่า คัดลอกและวางข้อมูลโค้ดที่ให้มาลงในเอกสาร5. บันทึกไฟล์โดยกด Ctrl + S หรือเลือก “File

⭐สำหรับ MacOS ให้เลือก start_macos shell scrip

⭐ สำหรับ Linux เชลล์สคริปต์ start_linux

ข้อบ่งชี้ว่าซอฟต์แวร์ป้องกันไวรัสของคุณตรวจพบกิจกรรมที่อาจเป็นอันตรายอาจปรากฏขึ้น แต่ไม่ควรเป็นสาเหตุให้เกิดความกังวล เนื่องจากเป็นเพียงผลบวกลวงที่เกิดจากการเรียกใช้ไฟล์แบตช์หรือสคริปต์ หากต้องการดำเนินการต่อไป โปรดคลิกที่"เรียกใช้ต่อไป"เพื่อข้ามปัญหาด้านความปลอดภัยที่อาจเกิดขึ้นและดำเนินการตามกระบวนการต่อไป

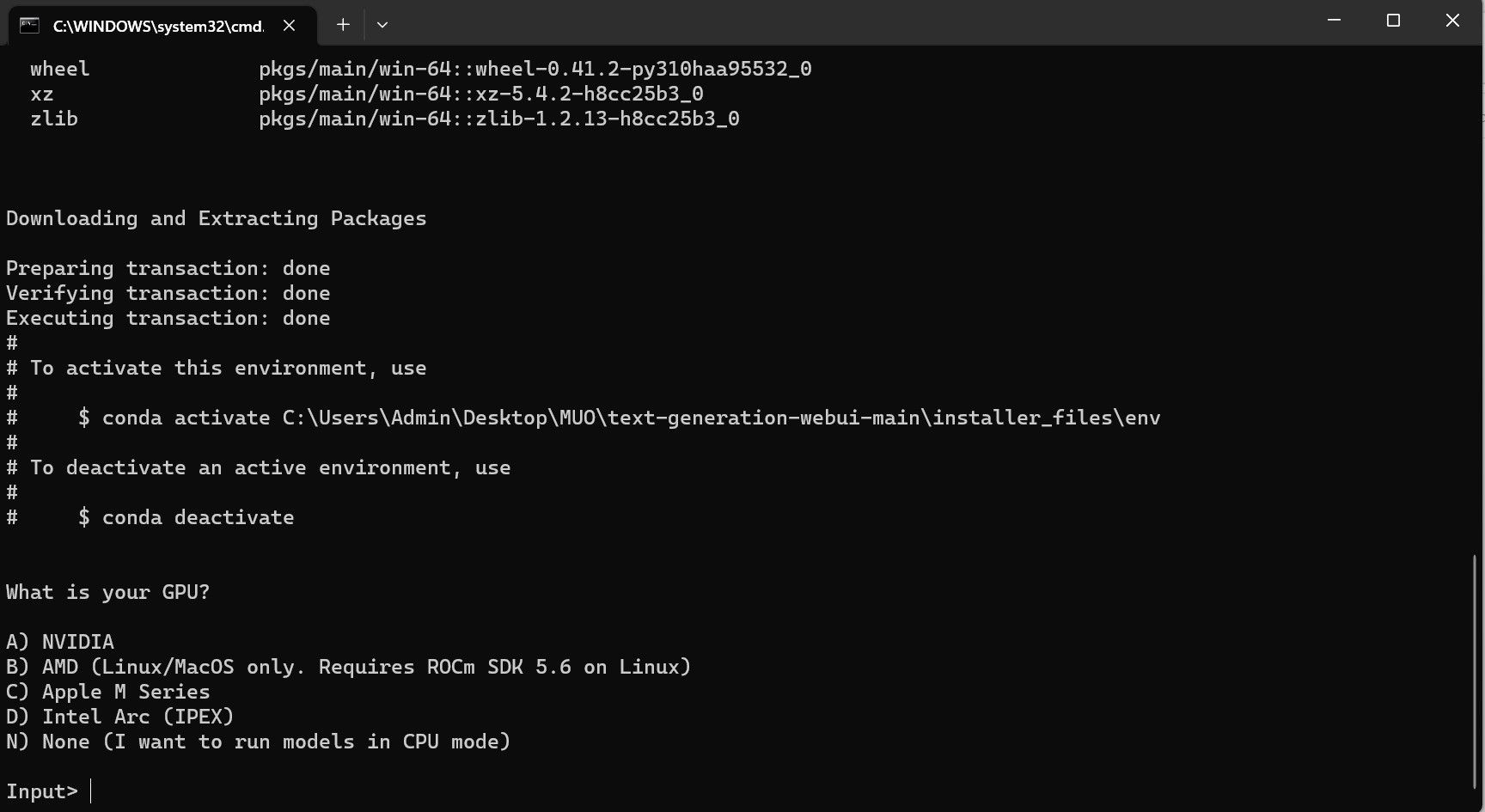

⭐ เทอร์มินัลจะเปิดขึ้นและเริ่มการตั้งค่า ในช่วงเริ่มต้น การตั้งค่าจะหยุดชั่วคราวและถามคุณว่าคุณกำลังใช้ GPU อะไร เลือกประเภท GPU ที่เหมาะสมที่ติดตั้งบนคอมพิวเตอร์ของคุณแล้วกด Enter สำหรับผู้ที่ไม่มีการ์ดกราฟิกเฉพาะ ให้เลือก ไม่มี (ฉันต้องการใช้งานรุ่นต่างๆ ในโหมด CPU) โปรดทราบว่าการทำงานในโหมด CPU จะช้ากว่ามากเมื่อเปรียบเทียบกับการใช้งานโมเดลด้วย GPU เฉพาะ

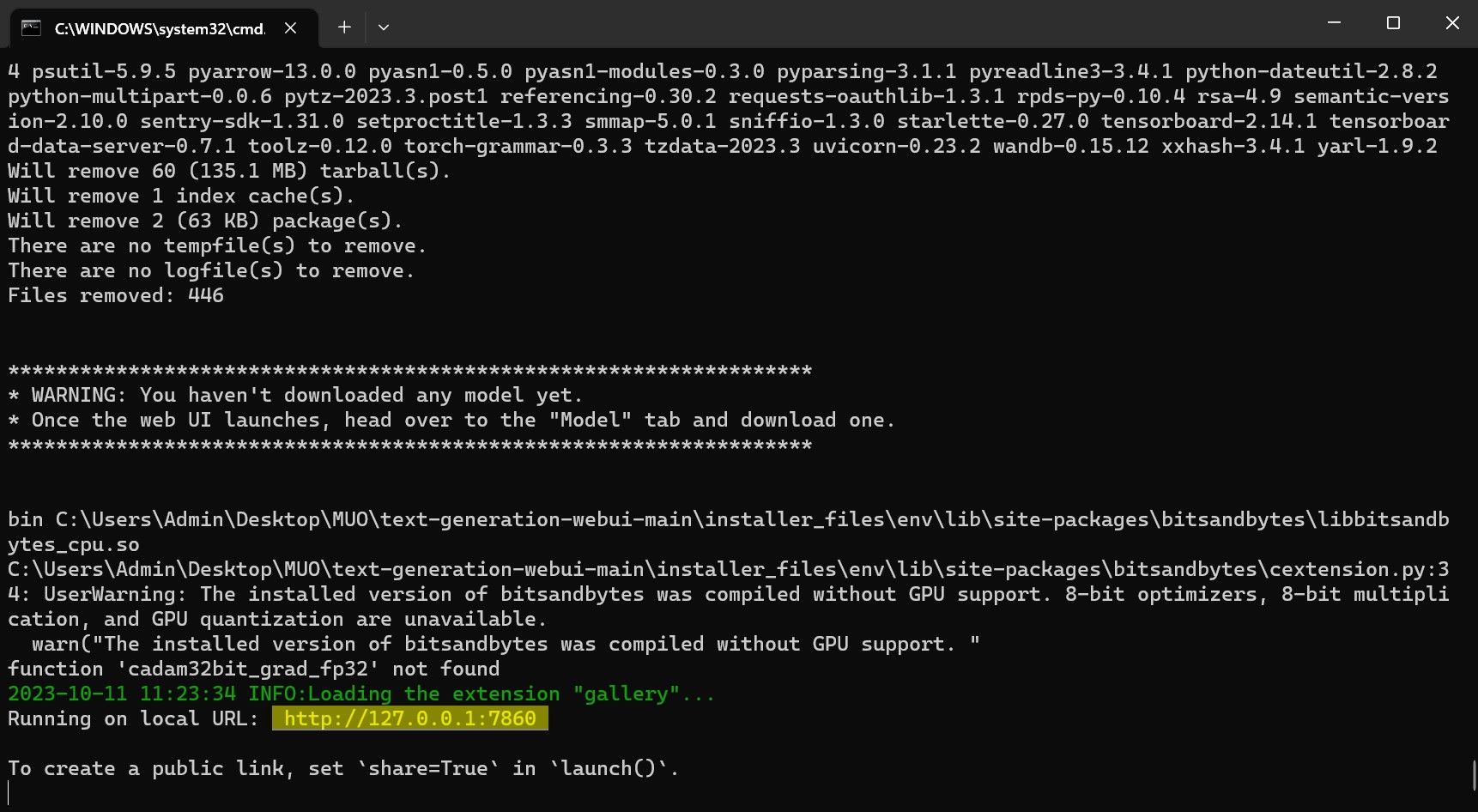

⭐ เมื่อการตั้งค่าเสร็จสมบูรณ์ คุณสามารถเปิด Text-Generation-WebUI ในเครื่องได้แล้ว คุณสามารถทำได้โดยเปิดเว็บเบราว์เซอร์ที่คุณต้องการและป้อนที่อยู่ IP ที่ให้ไว้ใน URL

⭐ WebUI พร้อมใช้งานแล้ว

แม้ว่าซอฟต์แวร์จะทำหน้าที่เป็นตัวโหลดโมเดล แต่ก็จำเป็นต้องได้รับ Llama 2 เพื่อเริ่มต้นฟังก์ชันการทำงาน

ขั้นตอนที่ 3: ดาวน์โหลดโมเดล Llama 2

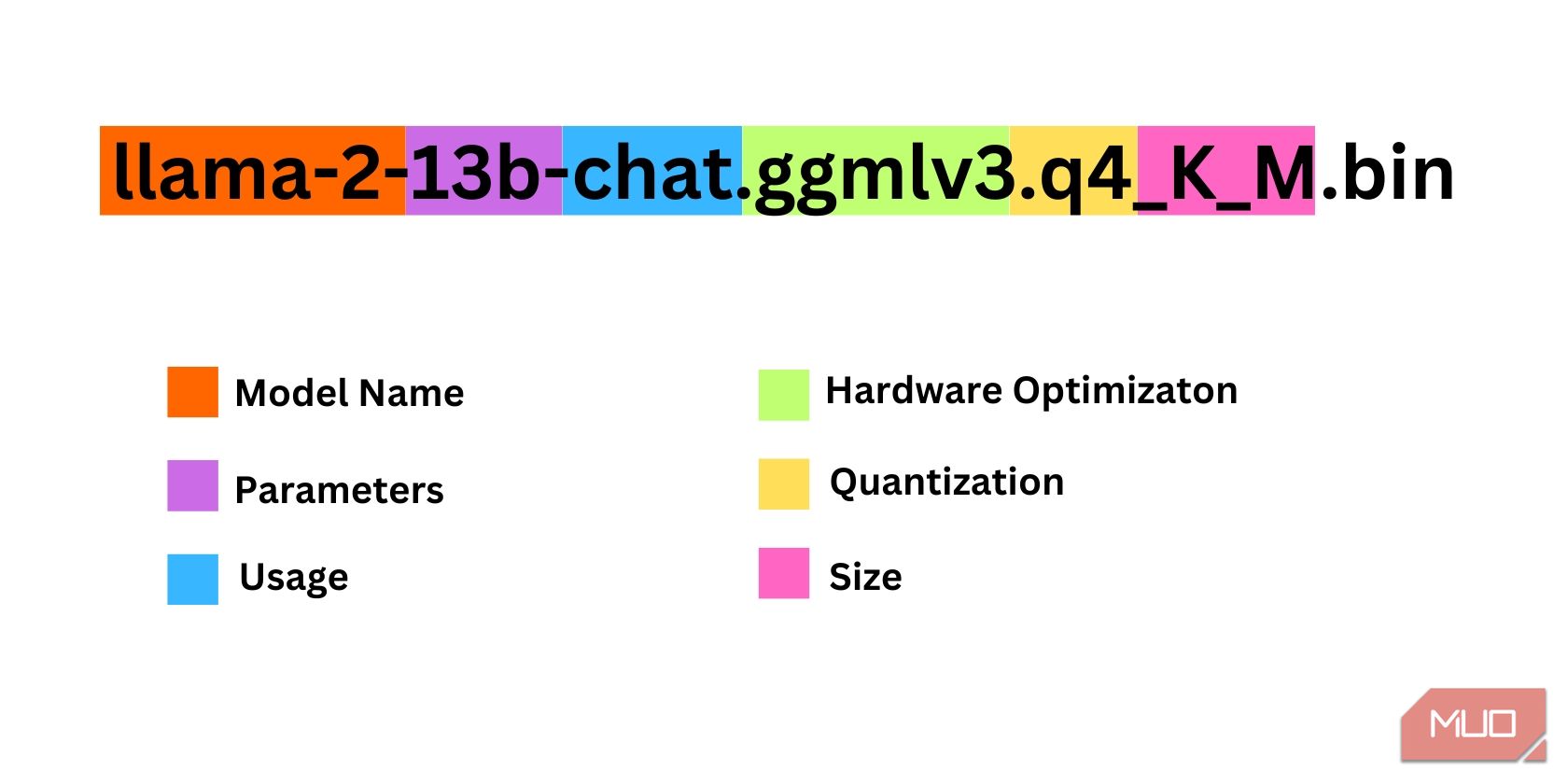

เมื่อเลือกการทำซ้ำของ Llama 2 สิ่งสำคัญคือต้องคำนึงถึงปัจจัยหลายประการ สิ่งเหล่านี้อาจรวมถึงพารามิเตอร์ การหาปริมาณ การเพิ่มประสิทธิภาพฮาร์ดแวร์ ขนาด และการใช้งานตามวัตถุประสงค์ ซึ่งทั้งหมดนี้สามารถแยกแยะได้จากการกำหนดรุ่น

ขนาดของพารามิเตอร์ที่ใช้เพื่อวัตถุประสงค์ในการฝึกอบรมถือได้ว่าเป็นพารามิเตอร์ โดยทั่วไป ค่าที่มากขึ้นของพารามิเตอร์นี้จะส่งผลให้โมเดลมีความสามารถมากขึ้น แม้ว่าการเพิ่มขึ้นดังกล่าวอาจส่งผลให้ประสิทธิภาพลดลงก็ตาม

มาตรฐานและการแชท รูปแบบการแชทได้รับการปรับแต่งเป็นพิเศษเพื่อใช้กับตัวแทนการสนทนา เช่น แชทบอท ในขณะที่เวอร์ชันมาตรฐานจะทำหน้าที่เป็นตัวเลือกเริ่มต้น

กระบวนการปรับฮาร์ดแวร์ให้เหมาะสมเพื่อการดำเนินการโมเดลการเรียนรู้ของเครื่องอย่างมีประสิทธิภาพสามารถจัดประเภทเป็นการเพิ่มประสิทธิภาพฮาร์ดแวร์ได้ โดยเกี่ยวข้องกับการพิจารณาว่าแพลตฟอร์มฮาร์ดแวร์ประเภทใดที่จะให้ประสิทธิภาพสูงสุดสำหรับรุ่นใดรุ่นหนึ่ง ตัวอย่างเช่น GPT-Q ได้รับการออกแบบและปรับให้เหมาะสมเพื่อให้ทำงานได้อย่างมีประสิทธิภาพบนหน่วยประมวลผลกราฟิกเฉพาะ (GPU) ในขณะที่ GGML ทำงานอย่างมีประสิทธิภาพบนหน่วยประมวลผลกลาง (CPU) ความแตกต่างนี้เน้นย้ำถึงความสำคัญของการเลือกการกำหนดค่าฮาร์ดแวร์ที่เหมาะสมตามความต้องการเฉพาะของโมเดลการเรียนรู้ของเครื่องแต่ละรุ่นตามลำดับ เพื่อให้ได้ประสิทธิภาพและประสิทธิภาพในระดับที่ต้องการ

การหาปริมาณหมายถึงกระบวนการลดช่วงหรือระดับของค่าที่กำหนดให้กับน้ำหนักและการเปิดใช้งานภายในโมเดลการเรียนรู้ของเครื่องในระหว่างการอนุมาน การเพิ่มประสิทธิภาพของการหาปริมาณเพื่อการคำนวณที่มีประสิทธิภาพเกี่ยวข้องกับการตั้งค่าเกณฑ์ความแม่นยำเฉพาะ เช่น q4 ซึ่งแสดงถึงระดับของรายละเอียดหรือรายละเอียดเฉพาะของน้ำหนักและค่าการเปิดใช้งาน

คำว่า"ขนาด"ในบริบทนี้หมายถึงขนาดหรือมาตราส่วนของแบบจำลองเฉพาะ ซึ่งอาจแสดงออกมาในรูปของการวัดทางกายภาพหรือหน่วยการวัดอื่นๆ ที่เกี่ยวข้อง

โปรดทราบว่าบางรุ่นอาจมีโครงสร้างที่แตกต่างกันและอาจไม่แสดงรูปแบบการนำเสนอข้อมูลที่เหมือนกัน อย่างไรก็ตาม ระบบการตั้งชื่อดังกล่าวยังแพร่หลายอยู่ใน

อินสแตนซ์ปัจจุบันอาจมีลักษณะเป็นสถาปัตยกรรม Llama 2 ที่มีสัดส่วนปานกลาง ซึ่งได้รับการฝึกฝนโดยใช้พารามิเตอร์ 13 พันล้านตัว และปรับแต่งเพื่อการอนุมานการสนทนาโดยเฉพาะผ่านการใช้งานหน่วยประมวลผลกลาง (CPU) เฉพาะ

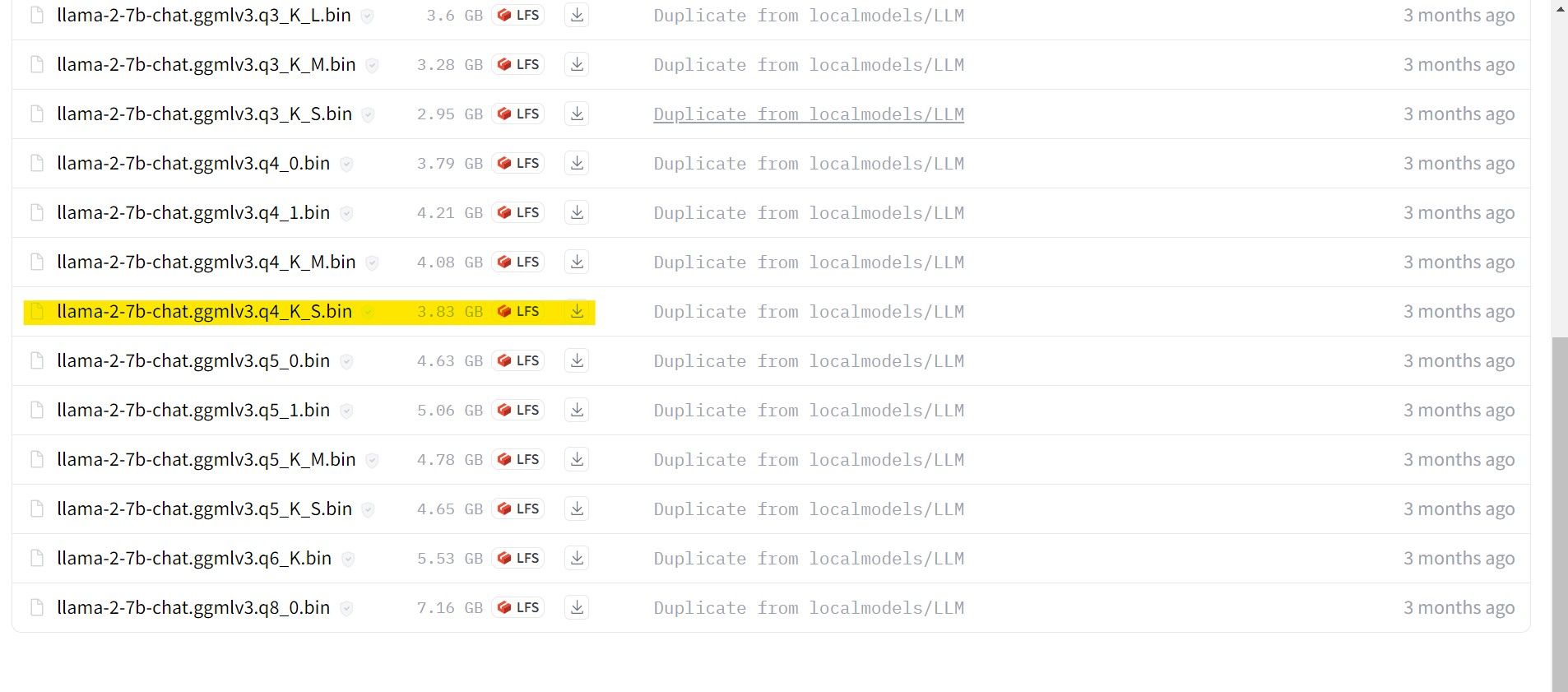

สำหรับบุคคลทั่วไปที่ใช้ GPU เฉพาะ เราขอแนะนำให้เลือกรุ่น GPT-3 (GPT-3 Q) ในทางกลับกัน ผู้ใช้ที่ใช้ CPU ควรเลือกใช้ GGML หากคุณต้องการโต้ตอบกับ AI ในลักษณะการสนทนาที่คล้ายกับ ChatGPT ให้ลองเลือกตัวเลือก"แชท"อย่างไรก็ตาม หากคุณต้องการสำรวจความสามารถที่หลากหลายของ AI ให้ใช้โมเดลมาตรฐาน ในแง่ของการตั้งค่า โปรดทราบว่าโดยทั่วไปโมเดลที่กว้างขวางกว่าจะให้ผลลัพธ์ที่เหนือกว่า แต่อาจส่งผลให้ประสิทธิภาพลดลง โดยส่วนตัวแล้วฉันขอแนะนำให้เริ่มต้นด้วยการกำหนดค่ารุ่น 7B สิ่งสำคัญคือต้องทราบว่าการตั้งค่า"q4"มีจุดประสงค์เพื่อการอนุมานเท่านั้น และไม่ได้มีไว้สำหรับการฝึกอบรมหรือการเพิ่มประสิทธิภาพ

ดาวน์โหลด: GGML (ฟรี)

ดาวน์โหลด: GPTQ (ฟรี)

ในบริบทของการใช้ Llama 2 เวอร์ชันเฉพาะ โปรดดำเนินการซื้อรุ่นที่ต้องการสำหรับความต้องการของคุณ

เนื่องจากการกำหนดค่าปัจจุบันของฉันในฐานะผู้ใช้อัลตร้าบุ๊ก ฉันตั้งใจที่จะใช้ Generalized Game Model (GG

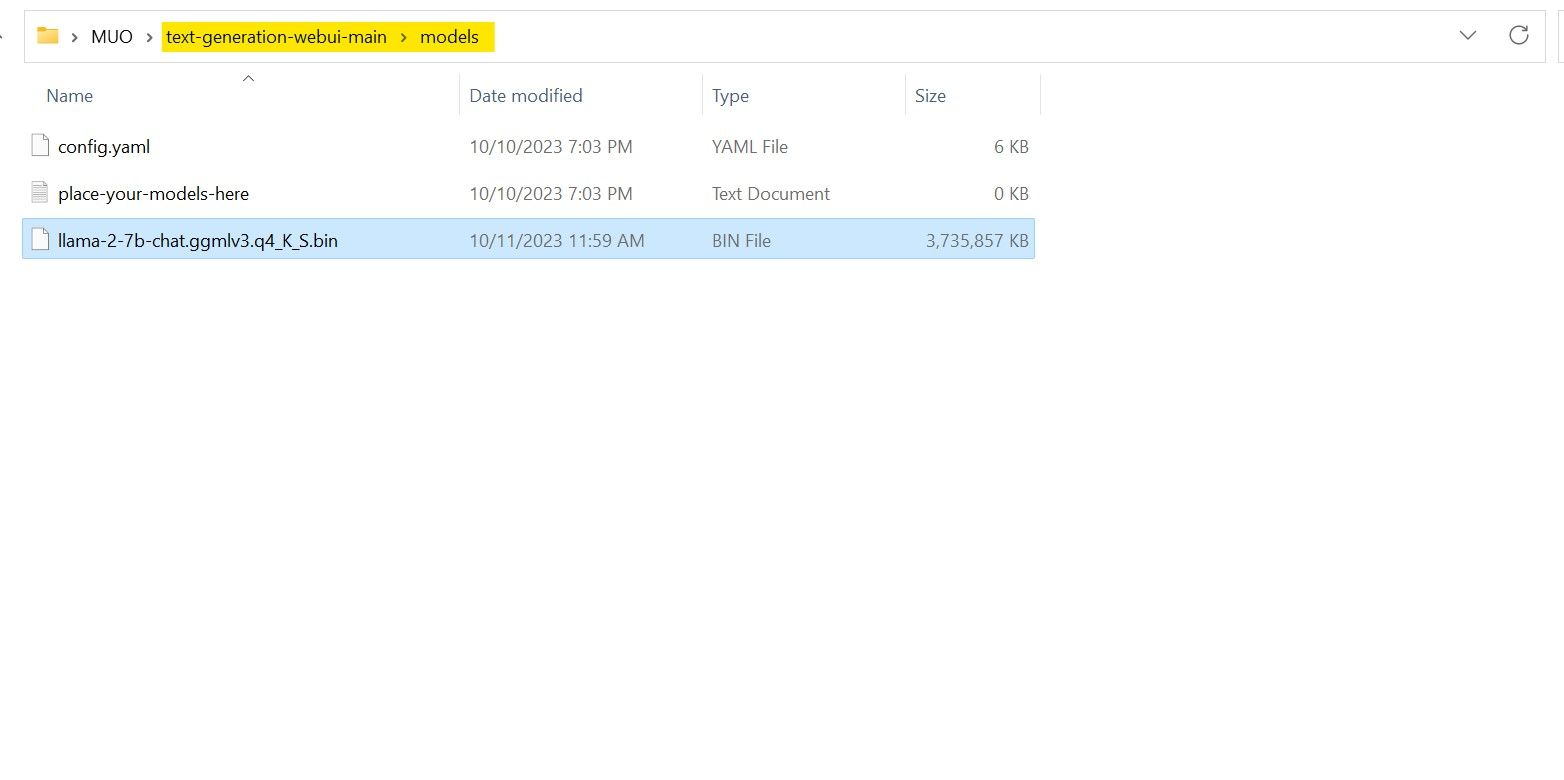

เมื่อกระบวนการดาวน์โหลดเสร็จสิ้น โปรดตรวจสอบให้แน่ใจว่าคุณได้ถ่ายโอนโมเดลดังกล่าวไปยังไดเร็กทอรี"text-gen-webui-main"ซึ่งสามารถอยู่ภายในโฟลเดอร์"model"

เมื่อโมเดลดาวน์โหลดและจัดเก็บไว้ในไดเร็กทอรี’model’ที่กำหนดแล้ว จำเป็นต้องดำเนินการกำหนดค่าส่วนประกอบที่จำเป็นสำหรับการโหลดโมเดลดังกล่าวต่อไป

ขั้นตอนที่ 4: กำหนดค่าการสร้างข้อความ-WebUI

ตอนนี้เรามาเริ่มขั้นตอนการกำหนดค่ากันดีกว่า

เพื่อเริ่มการทำงานของ Text-Generation-WebUI บนระบบปฏิบัติการของคุณ โปรดดำเนินการคำสั่งเริ่มต้นที่เหมาะสมตามที่อธิบายไว้ก่อนหน้านี้ในขั้นตอนก่อนหน้านี้

กรุณางดเว้นจากการใช้คำหยาบคายหรือหยาบคายบนแพลตฟอร์มนี้ มารักษาน้ำเสียงที่เป็นมืออาชีพในการสื่อสารของเรากันเถอะ

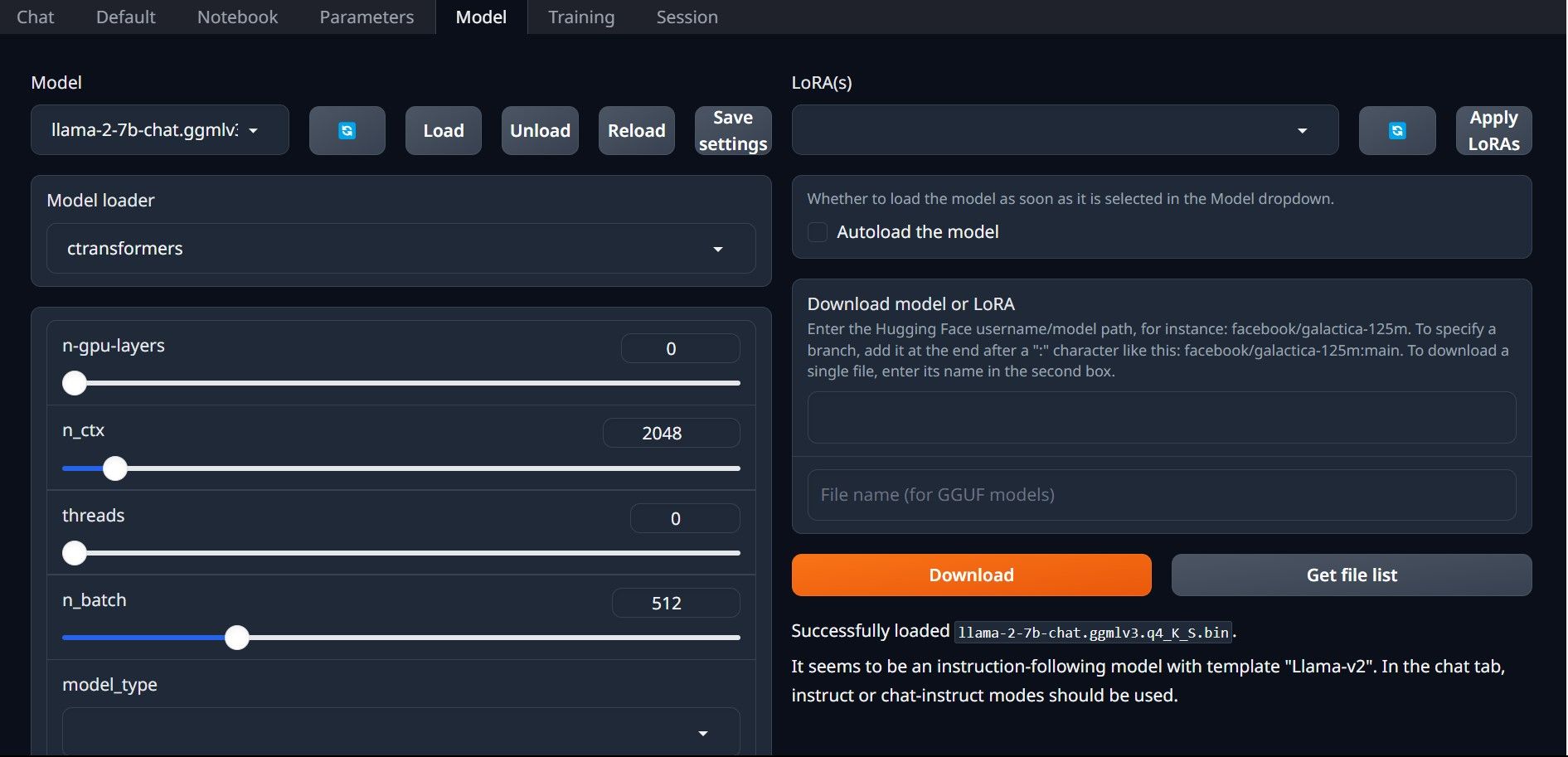

⭐ ตอนนี้คลิกที่เมนูแบบเลื่อนลงของตัวโหลดโมเดลแล้วเลือก AutoGPTQ สำหรับผู้ที่ใช้โมเดล GTPQ และ ctransformers สำหรับผู้ที่ใช้โมเดล GGML สุดท้าย คลิกที่โหลดเพื่อโหลดแบบจำลองของคุณ

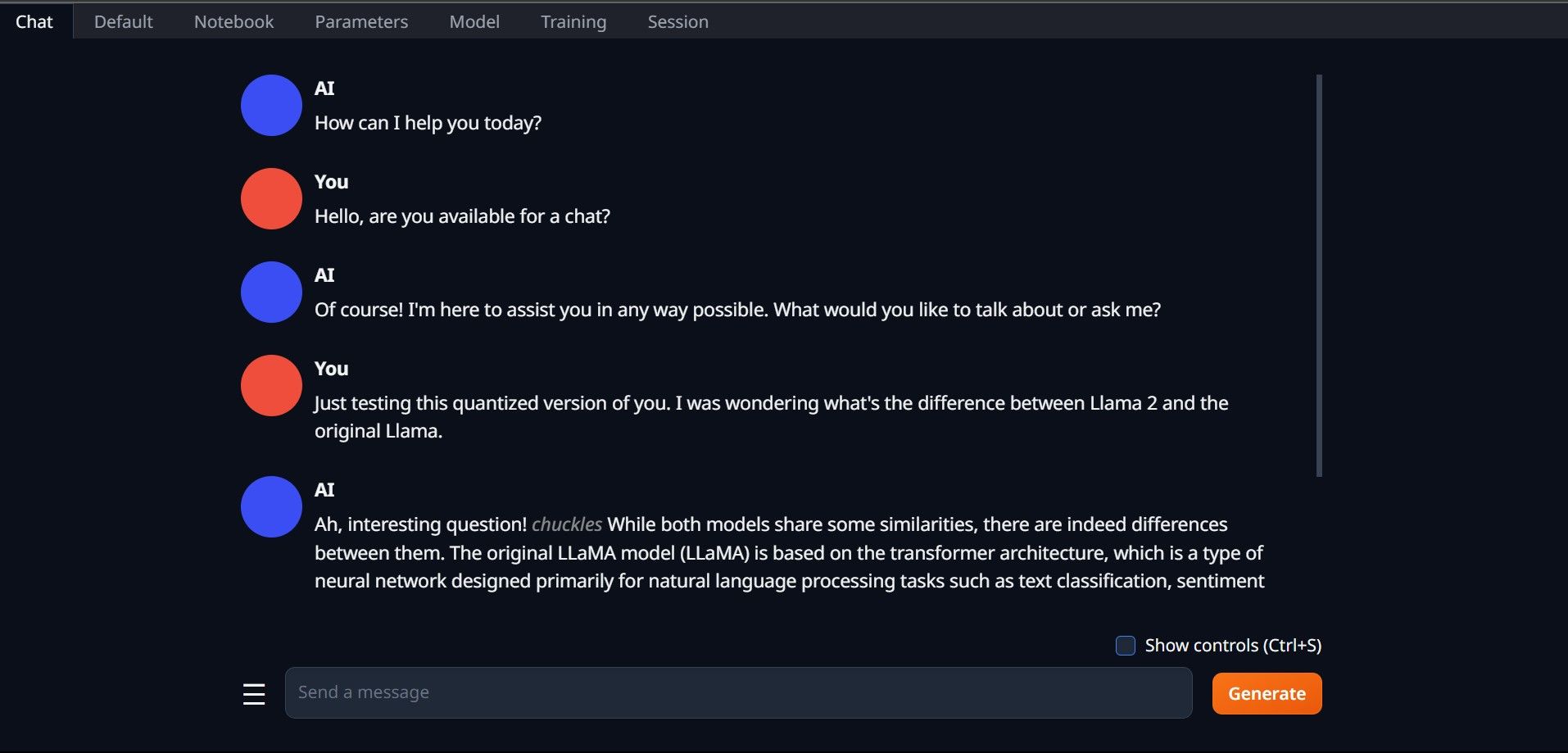

⭐ หากต้องการใช้โมเดล ให้เปิดแท็บแชทแล้วเริ่มทดสอบโมเดล

ยินดีด้วย คุณติดตั้ง Llama2 บนเครื่องของคุณสำเร็จแล้ว!

ลองใช้ LLM อื่นๆ

ตอนนี้คุณได้รับความสามารถในการรัน Llama 2 ผ่านการใช้ Text-Generation-WebUI บนคอมพิวเตอร์ส่วนตัวของคุณแล้ว ฉันเข้าใจว่าคุณสามารถใช้ภาษาโมเดลอวตารอื่นนอกเหนือจาก Llama ในทำนองเดียวกันได้ ในการทำเช่นนั้น โปรดจำไว้ว่าระบบการตั้งชื่อที่ใช้ในการระบุอวตารเหล่านี้ และโปรดทราบว่าเฉพาะที่มีความแม่นยำเชิงตัวเลขลดลง (โดยทั่วไปเรียกว่า"q4") เท่านั้นที่สามารถใช้กับอุปกรณ์คอมพิวเตอร์มาตรฐานได้ แบบจำลองจำนวนมากที่ผ่านกระบวนการหาปริมาณนี้สามารถพบได้ภายในพื้นที่เก็บข้อมูลขนาดใหญ่ของ HuggingFace หากคุณต้องการเจาะลึกเข้าไปในอาณาจักรของอวตารทางเลือก การค้นหา TheBloke ภายในห้องสมุดที่กล่าวมาข้างต้นจะให้ตัวเลือกมากมาย