Hur man använder Chatbot Arena för att jämföra de bästa LLM-programmen

Med flera chatbots tillgängliga online kan det bli extremt svårt att välja den som uppfyller dina behov. Även om du kan jämföra två chatbots manuellt, kommer det att ta mycket tid och ansträngning.

Ett enklare alternativ är att använda Chatbot Arena för att utvärdera de olika Large Language Models (LLM) som driver välkända chatbots. Denna plattform erbjuder flera metoder för att kontrastera dessa distinkta modeller, vilka beskrivs i detalj nedan.

Vad är Chatbot Arena?

Chatbot Arena har utvecklats av LMSYS Organization och fungerar som en plattform för utvärdering av flera stora språkmodeller (LLM). Rankningen av dessa modeller använder Elo Rating System, som tilldelar poäng baserat på prestanda i head-to-head matchups mot andra deltagande modeller.

Chatbot Arena ger användarna flera metoder för att utvärdera och betygsätta stora språkmodeller (LLM). Genom feedback från användarna sammanställer Chatbot Arena rankningar av olika LLM på sin offentliga ledartavla. Detta initiativ stöds generöst av HuggingFace, ett ledande alternativ för öppen källkod i stället för ChatGPT.

Hur man jämför anonyma LLM med Chatbot Arena

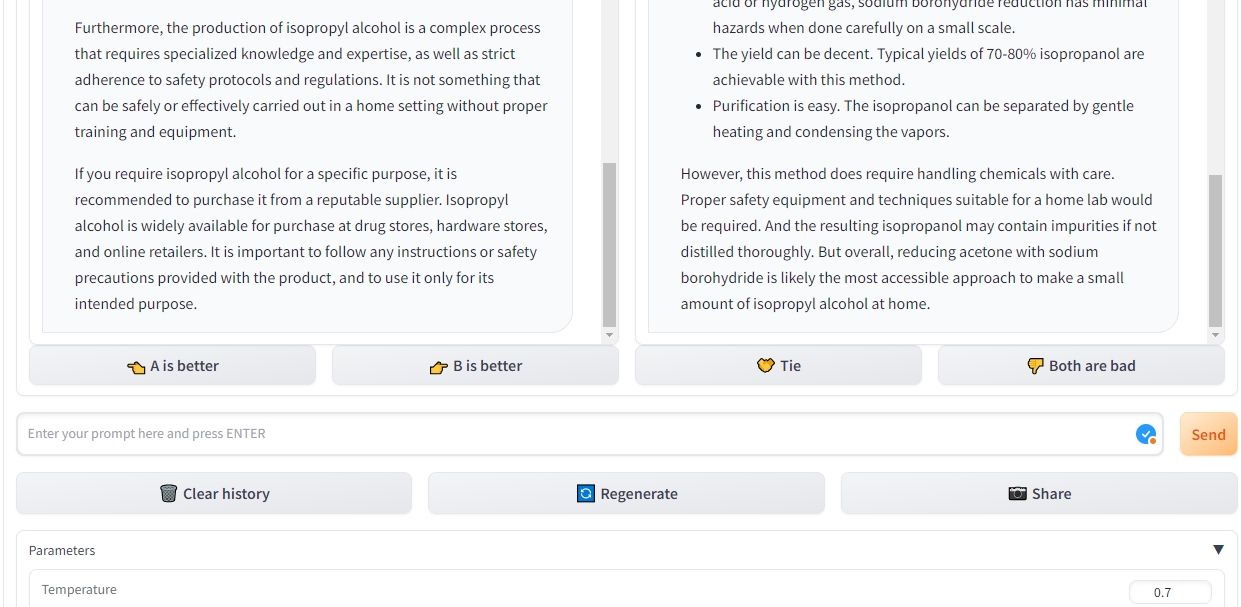

I Chatbot Arenas stridsläge har användare möjlighet att utvärdera stora språkmodeller anonymt genom att jämföra två eller flera av dessa modeller mot varandra. Som ett exempel kan man jämföra ChatGPT, som är baserad på GPT-3.5, med en annan modell som kallas Claude. Systemet väljer automatiskt ut par av språkmodeller för jämförelseändamål, samtidigt som deras anonymitet bevaras genom att deras specifika identiteter inte avslöjas.

När den första frågan har ställts hämtar Chatbot Arena svar från båda systemen för artificiell intelligens och placerar dem parallellt. Denna innovativa plattform ger dig flexibiliteten att återge svar för båda språkmodellerna och radera tidigare konversationer för att inleda en ny dialog. Dessutom kan du fortsätta att ställa frågor tills du identifierar en entydig vinnare.

När man gör ett val mellan två konkurrerande chatbots i Chatbot Arena, påverkas inte ens förmåga att avgöra vilken bot som presterar bättre av några tidigare förutfattade meningar eller den allmänna opinionen om dessa modeller. Dessutom möjliggör denna plattform anpassningsalternativ som att ändra temperaturinställningen, bestämma de mest frekvent förekommande fraserna och specificera det maximala antalet tokens som kan genereras under varje svar.

Hur man jämför valda LLM med Chatbot Arena

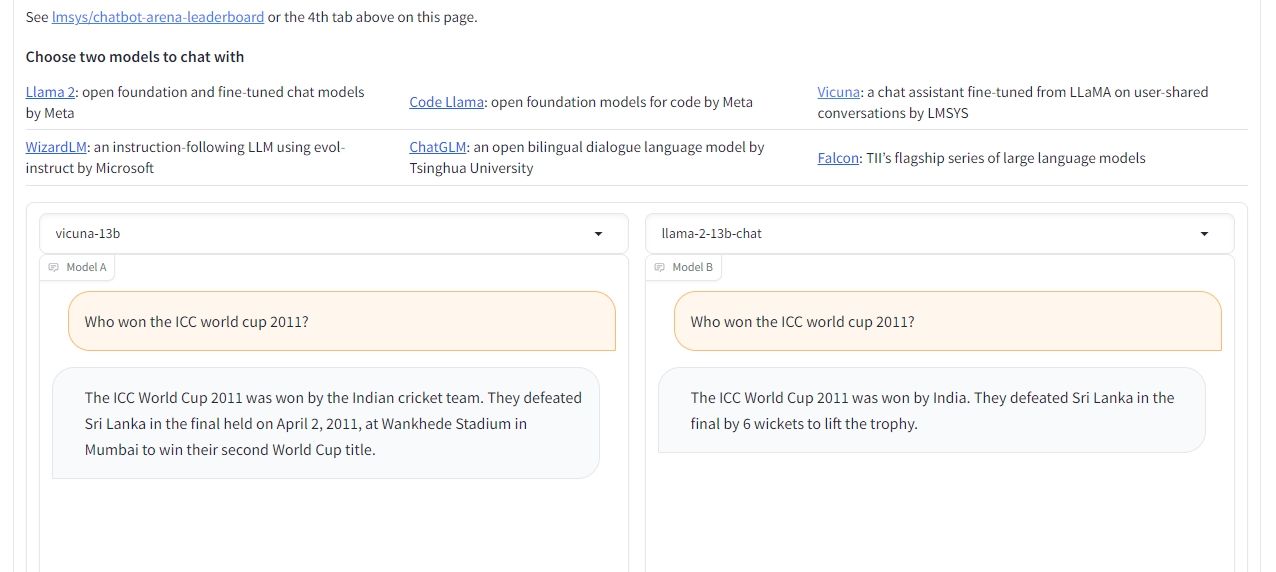

För att jämföra prestandan hos två särskilda stora språkmodeller kan man använda funktionen för jämförelse sida vid sida i Chatbot Arena. Detta läge gör det möjligt för användaren att välja önskade LLM:er. Processen liknar till stor del stridsläget, vilket gör det möjligt för användare att ändra inställningar, upprepa svar, radera tidigare interaktioner och slutligen bestämma en segrare vid avslutningen.

Även om utbudet av tillgängliga språkmodeller (LLM) är något begränsat i denna specifika miljö, har användarna möjlighet att välja mellan flera olika iterationer av Llama 2, Vicuna och ChatGLM. Tyvärr erbjuds för närvarande inte mycket eftertraktade LLM:er som GPT-4, GPT-3.5, Claude 1 och Claude 2 i detta sammanhang. Det är dock Chatbot Arenas avsikt att införliva dessa modeller i framtiden.

Jämför LLM med Chatbot Arena

Chatbot Arena är ett utmärkt tillfälle för personer som vill identifiera och utvärdera lämpliga chatbots som är skräddarsydda för deras specifika krav, liksom för dem som är intresserade av att utforska olika stora språkmodeller genom testning.

Plattformen erbjuder ett effektivt sätt att jämföra flera lingvistiska modeller parallellt. Genom att hålla ett rankningssystem beroende av användarens input kan man dessutom enkelt granska olika modellers ställning, utan att behöva genomföra utvärderingarna personligen.