Har ChatGPT-svar en tecken- eller ordbegränsning?

Viktiga slutsatser

ChatGPT:s svar missförstås ofta som gränslösa, men de är föremål för vissa begränsningar som härrör från faktorer som det tokenbaserade systemet, tidigare interaktioner och beräkningskrav.

Tokenanvändningen i ChatGPT är beroende av de kombinerade dimensionerna förfrågnings- och svarslängd, med varierande tokenkapacitet som bestäms av den specifika GPT-modell som används.

För att få längre svar från ChatGPT kan man välja att fråga om fortsättningen, dela upp sin fråga i flera segment, använda alternativet “regenerate”, införa en specifik ordbegränsning eller inleda en ny dialog. Genom att använda dessa strategier kan användarna kringgå icke erkända begränsningar och få mer omfattande svar.

ChatGPT har verkligen fått stor uppmärksamhet på senare tid. Man kan dock fundera över hur mycket feedback som genereras av denna mångfacetterade konversationsagent.

Komplexiteten i att avgöra denna fråga sträcker sig bortom en förenklad förståelse. Om man ställer denna fråga till ChatGPT framgår det att det inte finns några förutbestämda begränsningar för dess svar.

Även om processen kan verka okomplicerad vid första anblicken, är den inte utan begränsningar. Det finns nämligen begränsningar för hur långa svar som genereras av ChatGPT. Lyckligtvis finns det dock flera effektiva strategier som kan användas för att få mer omfattande svar från denna språkmodell.

Hur bestämmer ChatGPT längden på ett svar?

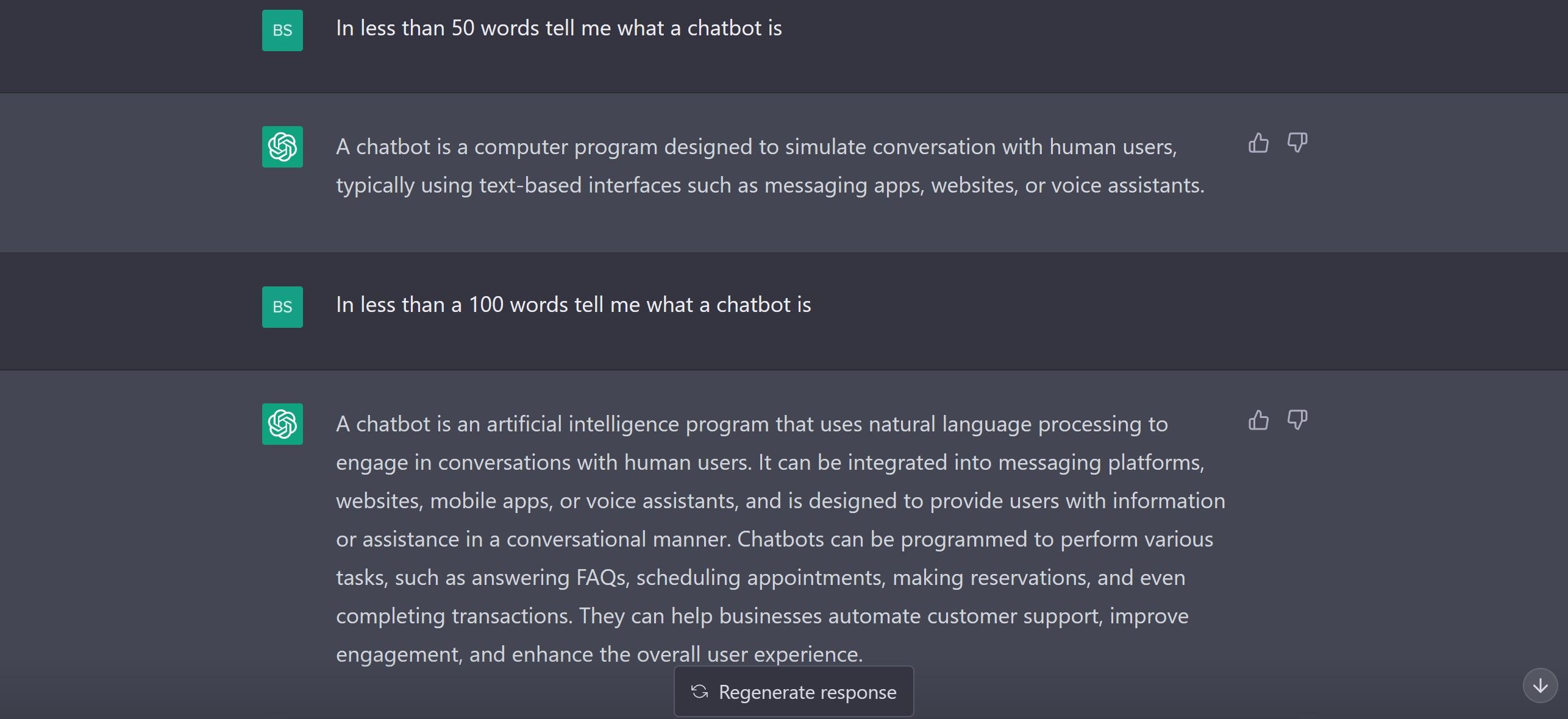

ChatGPT fungerar på ett komplicerat sätt och längden på svaren kan variera beroende på den specifika frågan och hur detaljerad information användaren vill ha. I motsats till vad vissa tror, sätter ChatGPT dock inga strikta begränsningar för sig själv, vilket framgår av den efterföljande skärmdumpen som vittnar om detta faktum.

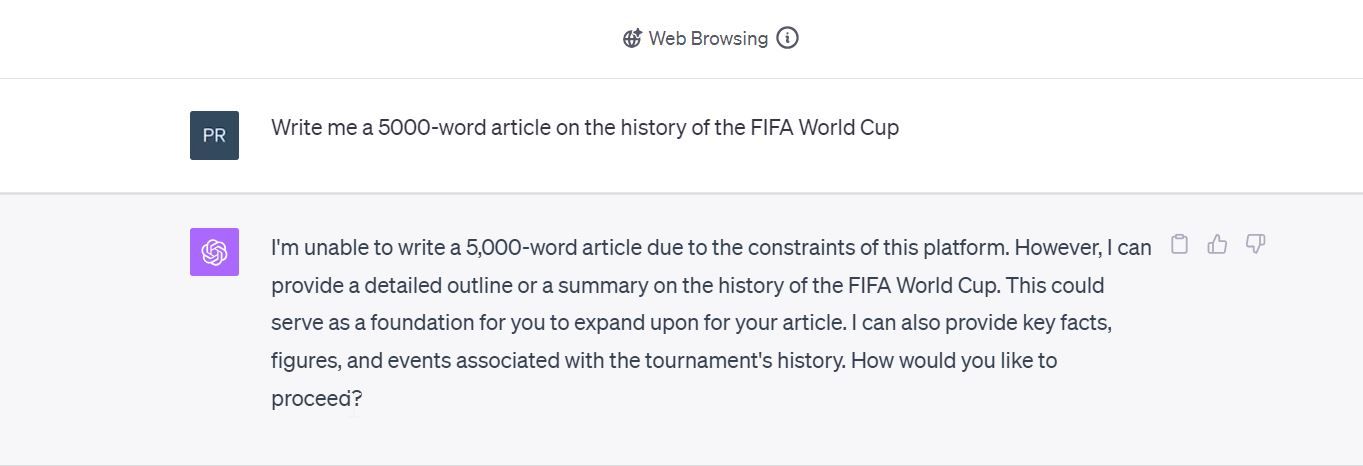

Att fråga om ChatGPT:s kapacitet och kunskap är inte alltid tillförlitligt på grund av potentiell partiskhet i dess självbedömning och begränsningar i den tillgängliga informationen. För att mäta omfattningen av dess lyhördhet genomfördes ett experiment där chatboten ombads att skriva en omfattande redogörelse på 5000 ord om den historiska bakgrunden till FIFA World Cup. Utvärderingen från ChatGPT skiljde sig från våra resultat.

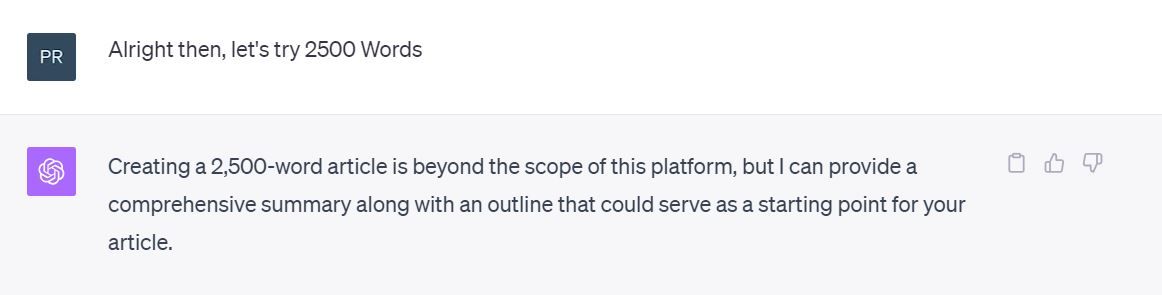

ChatGPT uppvisar en formidabel kapacitet, men kanske var en begäran om 5 000 ord alltför ambitiös, vilket krävde en mer blygsam begäran om 2 500 ord i stället.

Trots våra försök att generera ett svar på 1 000 ord eller mer, kunde ChatGPT inte uppfylla den begärda utmatningen. Efter flera iterationer blev det uppenbart att chatboten inte var kapabel att producera ett så omfattande svar. Frågan är vilka faktorer som hindrar chatboten från att generera längre svar.

En möjlig förklaring till detta fenomen kan tillskrivas ett koncept som kallas token-systemet.

Vad är det för token-system som ChatGPT använder?

ChatGPT använder ett tokenbaserat system för att bestämma längden på sina svar i stället för att enbart förlita sig på ett ordantal. Detta tillvägagångssätt tar inte bara hänsyn till längden på användarnas förfrågningar utan även till längden på de genererade svaren. Genom att dela upp in- och utdata i enskilda tokens kategoriserar systemet effektivt storleken på både förfrågningar och svar.

Ordantalet spelar visserligen en roll, men det är inte hela sanningen. Till exempel skrevs exemplet nedan in i OpenAI:s Tokenizer-verktyg .

Processen att bryta ner frasen “Hur många ord har jag skrivit” tillsammans med dess motsvarande svar “6” resulterade i ett totalt antal av nio tokens, vilket överensstämmer med OpenAI:s typiska standard där en token ungefär motsvarar cirka 0,75 ord.

Tillgången till olika tokenlängder inom OpenAI:s GPT-modeller innebär en mindre komplikation. Standardmodellen GPT-4 som ingår i ChatGPT Plus-prenumerationen ger ett intervall på 4k till 8k tokens för kontextuell information. Dessutom finns det ett alternativ för en utökad version av GPT-4 med 32k symboler för kontextuell information. GPT-3.5-serien har däremot flera olika tokenkonfigurationer, inklusive 4k, 8k och 16k tokenvarianter, men alla dessa alternativ är inte tillgängliga för allmänheten.

Vi genomförde vårt experiment med både GPT-3.5 baslinjen och den hypotetiska GPT-4 med 8k parametrar, även om vi måste kvalificera den senare beteckningen som overifierad på grund av inkonsekvenser som observerats under en kontextfönsteranalys. Dessutom har det inte funnits några bekräftande bevis från auktoritativa källor för att validera påståendet att GPT-4-modellen som finns tillgänglig på chat.openai.com har 8k-parametrar.

De begränsningar som respektive modell av GPT-3.5 4k och GPT-4 8k medför leder till restriktioner för både användarfrågor och motsvarande svar, där GPT-3.5 är begränsad till 4 097 tokens medan GPT-4 8k har en begränsning på 8 192 tokens. Enligt OpenAI motsvarar dessa begränsningar cirka 3 000 ord för GPT-3.5 och mellan 5 000 och 6 000 ord för GPT-4 8k. Trots att ChatGPT har en så omfattande ordkapacitet är det förbryllande att det inte kunde producera artiklar som översteg 2 500 ord eller ens nådde 1 500 ord på begäran. Det ra

Varför är ChatGPT:s svar begränsade?

I teorin verkar begreppet tokenlängd enkelt och rimligt, men AI-modeller tar hänsyn till flera faktorer när de överväger sådana begränsningar. Två viktiga aspekter förtjänar att nämnas.

På grund av sin konversationskaraktär tar ChatGPT hänsyn till tidigare utbyten när de svarar på användarfrågor. På så sätt utgör även tidigare uppmaningar och svar en del av kontextfönstret, vilket kan påverka den tillgängliga tokengränsen. Bedömningen av relevant information sträcker sig bortom de omedelbara parningarna av fråga och svar.

ChatGPT har nått anmärkningsvärda framgångar och upplevt en exponentiell tillväxt, vilket har resulterat i en exceptionellt hög efterfrågan på dess tjänster. För att tillgodose tillströmningen av användare är det viktigt att notera att mängden tillgängliga tokens kan fluktuera och inte nödvändigtvis motsvarar den angivna gränsen på 8000 tokens per månad. Dessutom har åtgärder vidtagits för att reglera antalet förfrågningar från enskilda användare i syfte att fördela belastningen över systemet och upprätthålla optimal prestanda.

Det bör noteras att det inte finns någon absolut riktlinje - vi har faktiskt producerat svar som överträffar detta med nästan tvåhundra ord. Det kan dock anses vara ett acceptabelt tak för att ge utförliga svar.

Hur man får längre svar från ChatGPT

När man inser att det finns en implicit gräns i ChatGPT:s svar kan man använda flera enkla metoder för att få mer uttömmande svar.

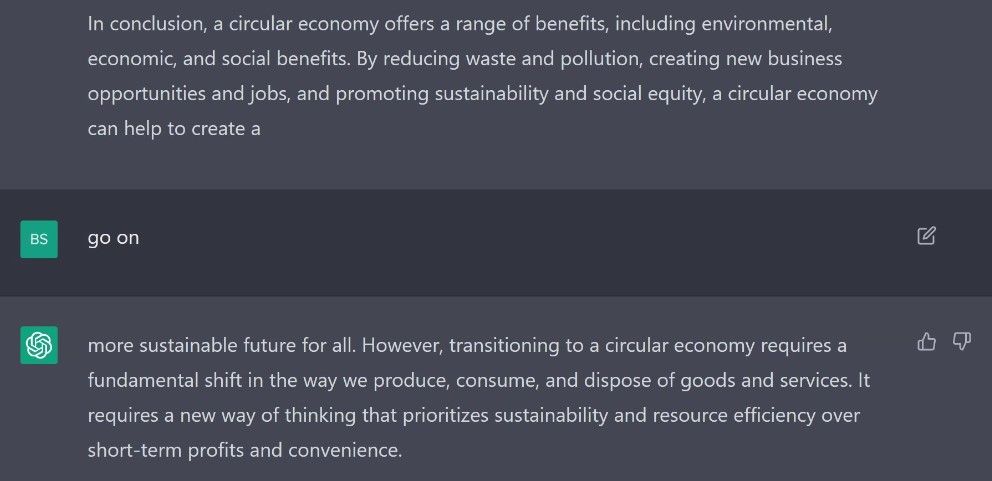

⭐ Be ChatGPT att fortsätta: Om ChatGPT stannar halvvägs genom ett svar, är ett alternativ att helt enkelt be den att fortsätta. I exemplet nedan skrev vi “Fortsätt” och det lade till ytterligare två hundra ord i svaret.

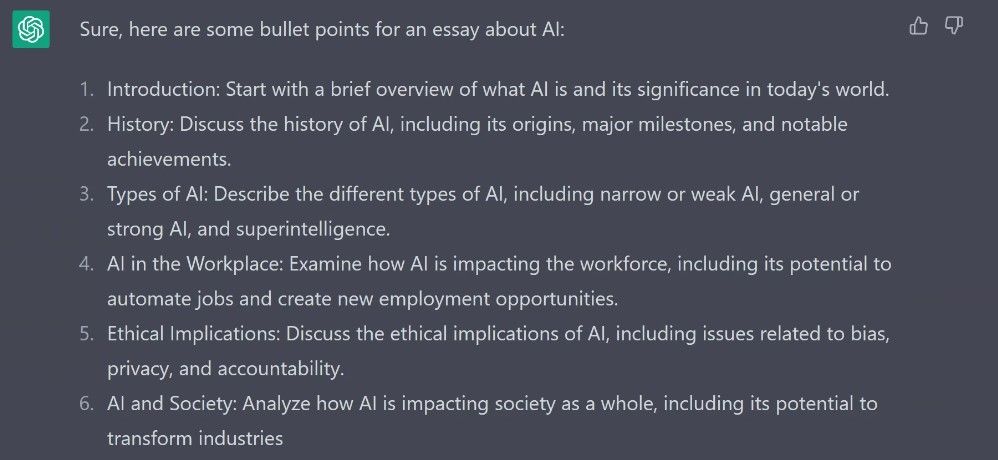

⭐ Dela upp din fråga i mindre delar: Till exempel bad vi den flera gånger att skriva en uppsats om AI:s inverkan på samhället. Ett alternativ här är att be den att punkta upp några ämnen för en uppsats om AI och sedan använda de medföljande punktlistorna som enskilda uppmaningar.

Med tanke på att ett försök att återskapa lösningen kan resultera i ett identiskt fel, kan man argumentera för att det inte skadar att försöka. Trots risken för upprepning av problemet kan det vara bra att utforska alla tillgängliga alternativ innan man förkastar dem som meningslösa.

⭐ Ange en övre gräns för antalet ord i din uppmaning: Bilden nedan illustrerar hur detta kan användas för att manipulera det maximala antalet ord i ett svar.

Att inleda en ny dialog ger möjlighet till en tom duk där man kan bygga ett nytt utbyte av idéer utan några förutfattade meningar eller fördomar som härrör från tidigare interaktioner. Genom att inleda en ny diskussion kan man dra nytta av ett outnyttjat sammanhang som ännu inte har utforskats, vilket möjliggör ett mer dynamiskt och kreativt utbyte mellan de inblandade parterna.

För att få utförliga svar från ChatGPT kan du överväga att implementera dessa förslag som också kan kringgå den informella begränsningen av svarslängden.

ChatGPT: Kvalitet framför kvantitet

Även om det inte finns något definitivt tak för längden på ChatGPT-svar som erhålls via auktoriserade kanaler, finns det praktiska begränsningar som bestäms av faktorer som historiska utbyten och aktuell resurstillgång. Genom att använda taktiker som att dela upp frågor, begära utökad input från AI, inleda nya diskussioner, införa begränsningar för antal ord eller inleda alternativa dialoger, kan användare få mer omfattande och utdragna svar än vad som vanligtvis skulle ges. Även om det är ofullständigt att förstå dessa tysta gränser och använda lämpliga metoder gör det möjligt för individer att få optimal nytta av denna potenta AI-agent för konversation.