Como usar o Chatbot Arena para comparar os melhores LLMs

Com vários chatbots disponíveis online, pode tornar-se extremamente difícil selecionar aquele que satisfaz as suas necessidades. Apesar de ser possível comparar dois chatbots manualmente, isso exige muito tempo e esforço.

Uma abordagem alternativa com maior simplicidade envolve a utilização da Chatbot Arena como um meio de avaliar os diversos Modelos de Linguagem Grandes (LLMs) que conduzem chatbots conhecidos. Esta plataforma apresenta vários métodos para contrastar estes modelos distintos, que são detalhados posteriormente.

O que é o Chatbot Arena?

Desenvolvido pela LMSYS Organization, o Chatbot Arena serve como uma plataforma para avaliar vários Modelos de Linguagem de Grande Porte (LLMs). A classificação destes modelos utiliza o Sistema de Classificação Elo, que atribui pontuações com base no desempenho em confrontos directos com outros modelos participantes.

O Chatbot Arena apresenta aos utilizadores vários métodos para avaliar e classificar grandes modelos de linguagem (LLMs). Através do envio de feedback dos utilizadores, o Chatbot Arena compila classificações de vários LLMs na sua tabela de classificação pública. Esta iniciativa é generosamente apoiada pelo HuggingFace, uma opção de código aberto líder no lugar do ChatGPT.

Como comparar LLMs anónimos com o Chatbot Arena

No modo de batalha do Chatbot Arena, os utilizadores têm a possibilidade de avaliar grandes modelos de linguagem anonimamente, comparando dois ou mais desses modelos entre si. Por exemplo, podemos comparar o ChatGPT, que se baseia no GPT-3.5, com outro modelo conhecido como Claude. O sistema selecciona automaticamente pares de modelos linguísticos para efeitos de comparação, preservando o seu anonimato ao não revelar as suas identidades específicas.

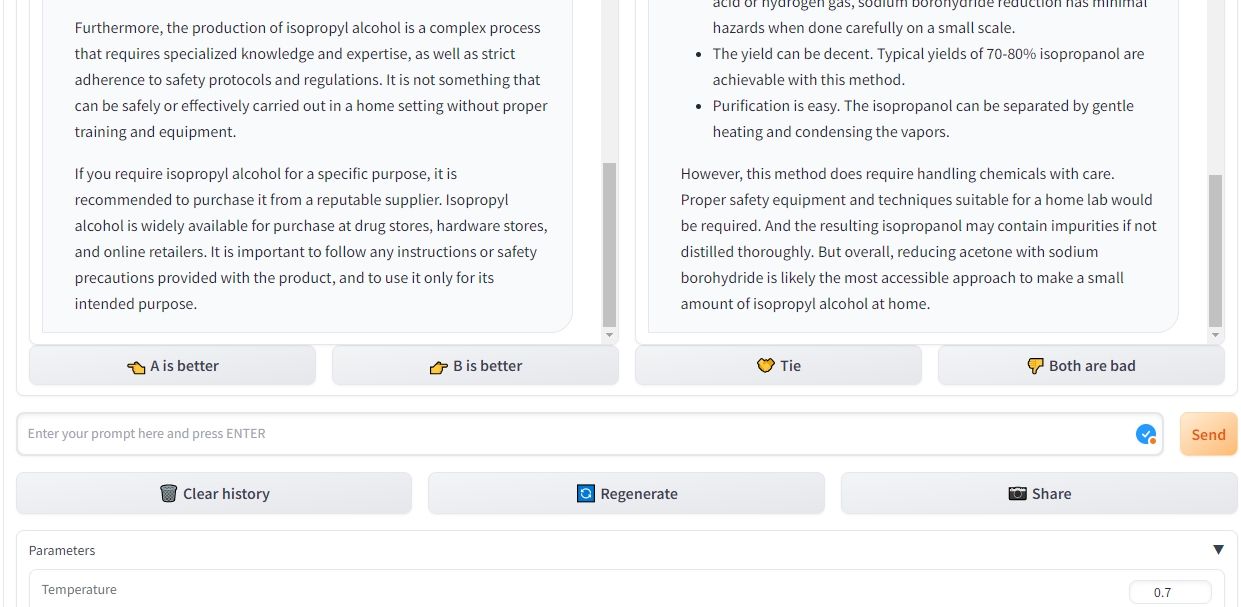

Após a introdução da consulta inicial, o Chatbot Arena extrai respostas de ambos os sistemas de inteligência artificial, posicionando-os em paralelo. Esta plataforma inovadora dá-lhe a flexibilidade de reproduzir respostas para qualquer um dos modelos linguísticos e erradicar conversas anteriores para iniciar outro diálogo. Além disso, pode continuar a colocar questões até identificar um vencedor inequívoco.

Ao fazer uma seleção entre dois chatbots concorrentes na Chatbot Arena, a capacidade de determinar qual o bot com melhor desempenho não é afetada por quaisquer opiniões pré-concebidas ou pela opinião pública atual relativamente a estes modelos. Além disso, esta plataforma permite opções de personalização, como a alteração da temperatura, a determinação das frases que aparecem com mais frequência e a especificação do número máximo de tokens que podem ser gerados durante cada resposta.

Como comparar LLMs seleccionados com o Chatbot Arena

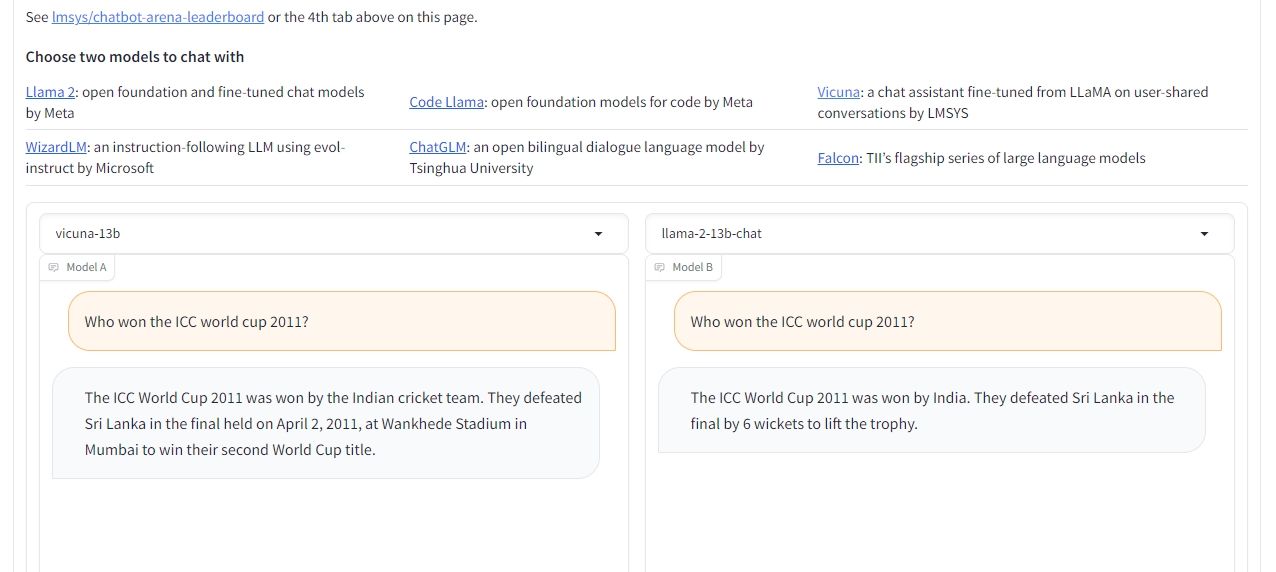

Para contrastar o desempenho de dois modelos de linguagem grandes em particular, é possível utilizar a funcionalidade de comparação lado a lado no Chatbot Arena. Este modo permite que o utilizador seleccione os LLM desejados. O processo é muito semelhante ao modo de batalha, permitindo aos utilizadores modificar definições, reiterar respostas, apagar interacções anteriores e, por fim, determinar um vencedor no final.

Embora a variedade de Modelos de Disponibilidade de Modelos Linguísticos (LLMs) acessíveis nesta configuração particular seja algo restrita, os utilizadores têm a opção de escolher entre várias iterações distintas de Llama 2, Vicuna e ChatGLM. Lamentavelmente, atualmente, os LLMs mais procurados, como o GPT-4, GPT-3.5, Claude 1 e Claude 2, não são oferecidos neste contexto. No entanto, é intenção do Chatbot Arena incorporar estes modelos no futuro.

Comparar LLMs usando o Chatbot Arena

O Chatbot Arena apresenta uma excelente oportunidade para os indivíduos que procuram identificar e avaliar chatbots apropriados e adaptados às suas necessidades específicas, bem como para os interessados em explorar vários modelos de linguagem de grande dimensão através de testes.

A plataforma oferece um meio eficiente para contrastar vários modelos linguísticos em paralelo. Além disso, ao manter um sistema de classificação dependente da entrada do utilizador, é possível examinar prontamente a posição de diversos modelos, sem ter de realizar as avaliações pessoalmente.