Como reduzir a alucinação com IA com estas 6 técnicas

Key Takeaways

Para reduzir os casos de conteúdos gerados por inteligência artificial que se desviam dos resultados pretendidos, é essencial fornecer directivas bem definidas que permitam uma compreensão precisa do que se espera. Uma orientação ambígua pode levar a consequências indesejadas, ao passo que o fornecimento de especificações pormenorizadas promove a previsibilidade do resultado gerado.

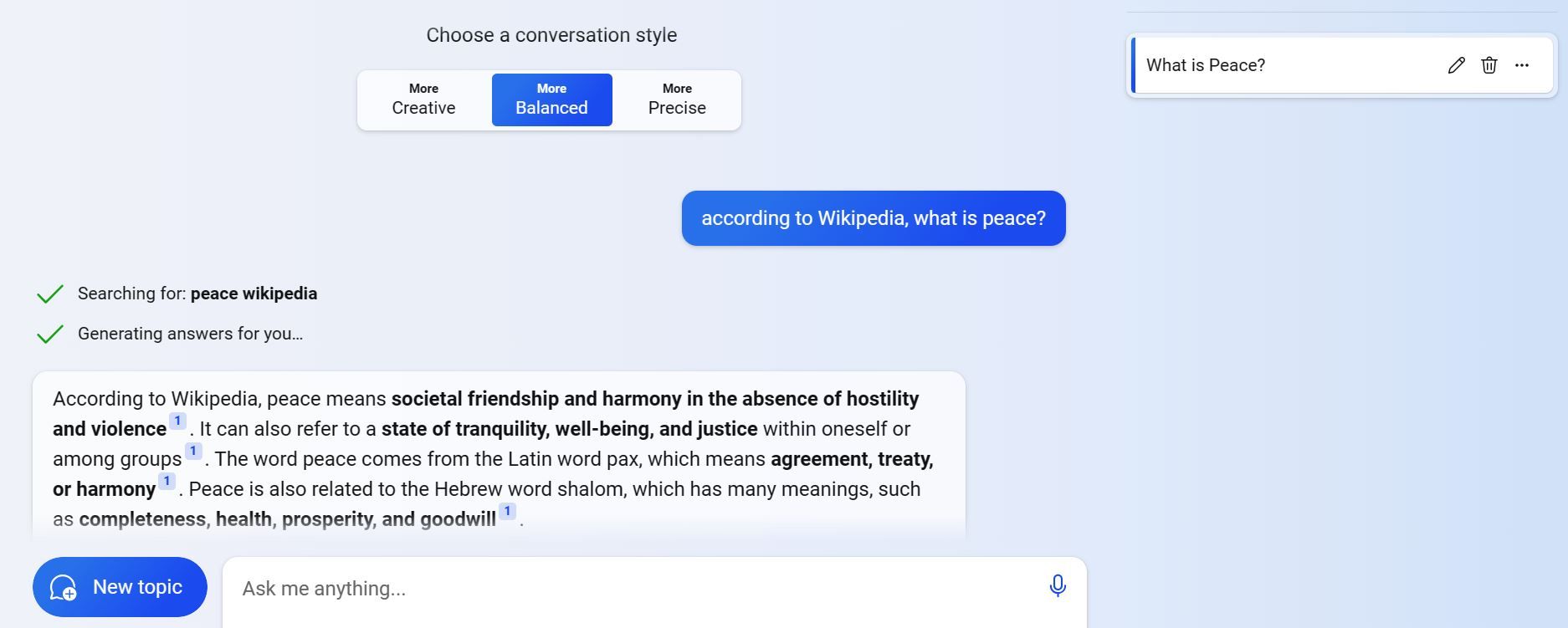

Ao utilizar o grounding ou a abordagem “de acordo com…”, é importante atribuir qualquer resultado gerado a uma fonte ou ponto de vista específico. Ao fazê-lo, é possível evitar a ocorrência de discrepâncias factuais e preconceitos no material produzido pela IA.

Para orientar a inteligência artificial para um resultado específico, é importante estabelecer parâmetros ou limitações claras dentro das quais o sistema deve funcionar. Estas limitações podem ser explicitamente declaradas ou implícitas com base no contexto ou na tarefa em causa, a fim de evitar quaisquer resultados indesejados ou ilógicos que possam surgir de uma má interpretação das instruções. Ao considerar cuidadosamente estes factores, podemos controlar eficazmente a direção das respostas geradas pela IA e garantir a sua relevância e coerência com os objectivos pretendidos.

O fenómeno da alucinação por IA pode surgir quando um indivíduo se depara com respostas indesejadas e falsas geradas por um sistema de inteligência artificial generativo. Este problema pode manifestar-se como informação enganadora ou irrelevante produzida pelo modelo de IA, que se desvia do resultado pretendido.

A fiabilidade das respostas geradas pela IA pode ser influenciada por diversas variáveis, incluindo o calibre das informações utilizadas para efeitos de formação, informações contextuais insuficientes e instruções imprecisas que podem causar confusão. No entanto, existem metodologias que permitem aos utilizadores obter resultados mais fiáveis quando interagem com sistemas de inteligência artificial.

Dar indicações claras e específicas

Uma forma de atenuar a possibilidade de os sistemas de inteligência artificial gerarem resultados indesejados ou enganadores consiste em formular orientações precisas e pormenorizadas aquando do fornecimento de dados. Pedidos ambíguos ou imprecisos podem resultar em consequências indesejadas devido à complexidade inerente a estas tecnologias, pelo que é importante definir claramente as expectativas para obter resultados mais exactos e satisfatórios.

Reformular a consulta para solicitar informações específicas sobre os atributos e a disposição da raça Golden Retriever pode ajudar a reduzir os casos de má interpretação nas respostas da IA. Ao limitar o âmbito da consulta, o sistema tem menos probabilidades de gerar conteúdos imaginativos ou irrelevantes que se afastem do assunto pretendido.

Utilizar o Grounding ou a técnica “De acordo com…” Técnica

A utilização de sistemas de inteligência artificial apresenta muitas vezes uma dificuldade na medida em que podem produzir resultados erróneos, preconceituosos ou incongruentes com as crenças ou princípios de uma pessoa. Tais discrepâncias podem surgir devido ao treino destes sistemas de IA em conjuntos de dados extensos e variados que contêm imperfeições, pontos de vista pessoais ou disparidades.

Para evitar tais ocorrências, podem-se empregar técnicas de fundamentação ou a metodologia “de acordo com”, em que o conteúdo gerado pela IA é atribuído a uma determinada origem ou ponto de vista. A título de exemplo, um indivíduo pode pedir que o sistema de IA produza uma declaração verificável sobre um assunto com base na informação fornecida por fontes como a Wikipédia, o Google Scholar ou qualquer outro recurso amplamente disponível.

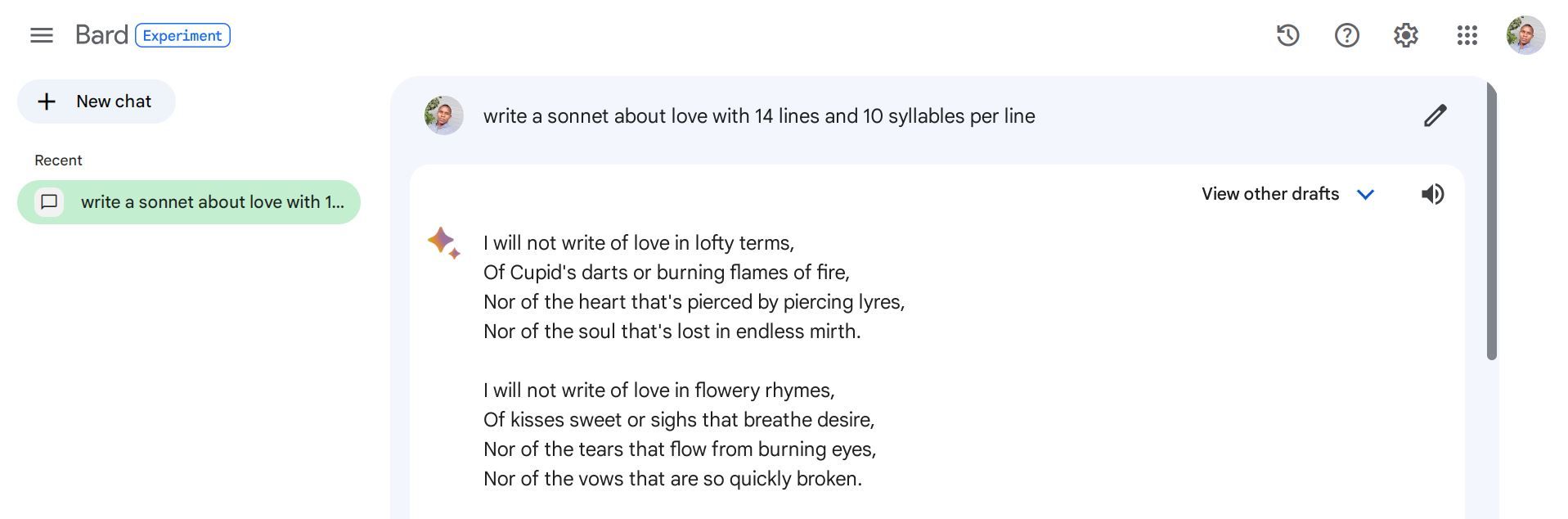

Utilizar restrições e regras

A incorporação de restrições e directrizes num sistema de Inteligência Artificial serve para evitar a produção de resultados irrelevantes, contraditórios ou sem sentido. Além disso, estes parâmetros orientam e afinam os resultados de acordo com um objetivo e uma intenção específicos. Estes pré-requisitos podem ser expressamente expressos na instrução ou subtilmente inferidos através das circunstâncias circundantes ou da tarefa atribuída.

Quando se tenta utilizar a inteligência artificial para compor poesia sobre o tema do afeto, pode-se optar por dar ao software um comando mais específico e estruturado, em vez de um pedido generalizado como “produza um verso sobre o amor”. Um exemplo disto poderia ser instruir o programa para criar um soneto com catorze linhas e dez sílabas por linha, de forma a restringir o seu âmbito criativo dentro de certos limites.

Utilizar instruções em várias etapas

Por vezes, perguntas complexas podem provocar ilusões geradas pela IA devido à tentativa do sistema de as abordar instantaneamente. Uma estratégia eficaz é dissecar estas questões numa série de passos sequenciais para uma melhor compreensão e precisão de resposta.

Uma pergunta alternativa poderia ser: “Que tratamentos são normalmente utilizados para tratar a diabetes e qual deles foi considerado superior com base em resultados de investigação médica?

A utilização de um estímulo em várias etapas obriga o modelo de IA a fornecer pormenores intermédios antes de dar uma resposta definitiva, o que acaba por resultar em respostas mais precisas e completas.

Atribuir uma função à IA

Ao definir a função de um modelo de inteligência artificial num determinado pedido, é vantajoso estabelecer o objetivo pretendido, minimizando o potencial de má interpretação ou de resultados errados. Em vez de pedir informações gerais relativas ao desenvolvimento histórico da mecânica quântica, poder-se-ia dirigir a IA dando-lhe instruções para encarnar a persona de um académico dedicado que contaria meticulosamente os acontecimentos fundamentais que moldaram a trajetória deste campo.

A abordagem sugerida incita a inteligência artificial a incorporar as características de um investigador assíduo, em vez das de um narrador fantasioso.

Adicionar informações contextuais

A utilização de modelos de IA como o ChatGPT sem fornecer detalhes contextuais apropriados pode levar a resultados não optimizados. O fornecimento de informações contextuais ajuda a compreender o contexto subjacente da tarefa, incluindo o seu domínio, objetivo e quaisquer exemplos ou referências pertinentes. Esses dados podem incluir palavras-chave, etiquetas, categorias, fontes e afins, o que contribui para gerar respostas que estão melhor alinhadas com o significado pretendido.

Para produzir uma avaliação relativa a um conjunto de auriculares, é necessário oferecer detalhes contextualmente relevantes, incluindo a designação do item, o fabricante, as capacidades, o custo, a classificação e os comentários dos utilizadores. Um convite eficaz para este objetivo pode assemelhar-se ao seguinte formato:

Obter melhores respostas de IA

Navegar pelas limitações da inteligência artificial pode ser uma fonte de frustração para os utilizadores que podem não receber os resultados esperados dos modelos de IA. No entanto, ao utilizar tácticas estratégicas de estímulo, é possível diminuir o potencial de ilusões geradas pela IA e obter resultados mais fiáveis e precisos dos sistemas de IA.

Tenha em atenção que estas estratégias não garantem resultados infalíveis e podem não ser aplicáveis a todas as tarefas ou assuntos. É essencial efetuar um processo de verificação minucioso do conteúdo gerado pela IA antes de o utilizar em qualquer aplicação crítica.