Jak wykorzystać Chatbot Arena do porównania najlepszych studiów LLM?

Przy wielu chatbotach dostępnych online, wybór tego, który spełnia Twoje potrzeby, może okazać się niezwykle trudny. Chociaż możesz porównać dowolne dwa chatboty ręcznie, zajmie to dużo czasu i wysiłku.

Alternatywne podejście o większej prostocie polega na wykorzystaniu Chatbot Arena jako środka do oceny różnych dużych modeli językowych (LLM) napędzających znane chatboty. Platforma ta przedstawia kilka metod porównywania tych charakterystycznych modeli, które zostały szczegółowo opisane poniżej.

Czym jest Chatbot Arena?

Opracowana przez organizację LMSYS, Chatbot Arena służy jako platforma do oceny wielu dużych modeli językowych (LLM). Ranking tych modeli wykorzystuje system rankingowy Elo, który przypisuje wyniki na podstawie wydajności w bezpośrednich pojedynkach z innymi uczestniczącymi modelami.

Chatbot Arena prezentuje użytkownikom wiele metod oceny i rankingu dużych modeli językowych (LLM). Poprzez przesyłanie opinii użytkowników, Chatbot Arena kompiluje rankingi różnych LLM na swojej publicznej tablicy wyników. Inicjatywa ta jest hojnie wspierana przez HuggingFace, wiodącą opcję open-source zamiast ChatGPT.

Jak porównywać anonimowe modele LLM za pomocą Chatbot Arena

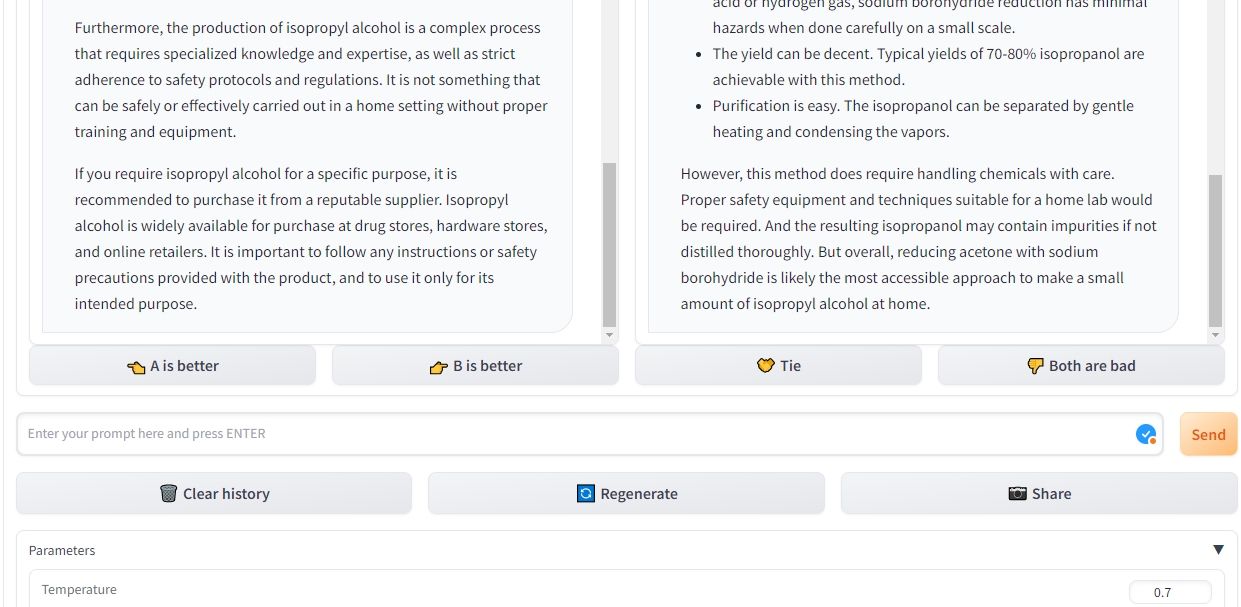

W trybie bitewnym Chatbot Arena użytkownicy mają możliwość anonimowej oceny dużych modeli językowych, porównując dwa lub więcej z nich ze sobą. Jako przykład można podać ChatGPT, który jest oparty na GPT-3.5, z innym modelem znanym jako Claude. System automatycznie wybiera pary modeli językowych do celów porównawczych, zachowując ich anonimowość i nie ujawniając ich tożsamości.

Po wprowadzeniu początkowego zapytania, Chatbot Arena wyodrębnia odpowiedzi z obu systemów sztucznej inteligencji, pozycjonując je równolegle. Ta innowacyjna platforma zapewnia elastyczność w odtwarzaniu odpowiedzi dla dowolnego modelu językowego i eliminowaniu wcześniejszych rozmów w celu zainicjowania kolejnego dialogu. Dodatkowo, możesz kontynuować zadawanie pytań, aż do zidentyfikowania jednoznacznego zwycięzcy.

Po dokonaniu wyboru między dwoma konkurującymi chatbotami na Chatbot Arena, zdolność do określenia, który bot działa lepiej, pozostaje nienaruszona przez jakiekolwiek wcześniejsze opinie lub obecną opinię publiczną na temat tych modeli. Dodatkowo platforma ta pozwala na dostosowanie opcji, takich jak zmiana ustawienia temperatury, określenie najczęściej pojawiających się fraz i określenie maksymalnej liczby tokenów, które można wygenerować podczas każdej odpowiedzi.

Jak porównać wybrane modele LLM za pomocą Chatbot Arena

Aby porównać wydajność dwóch konkretnych dużych modeli językowych, można skorzystać z funkcji porównania side-by-side w Chatbot Arena. Tryb ten pozwala na wybór pożądanych LLM przez użytkownika. Proces jest w dużej mierze podobny do trybu bitwy, umożliwiając użytkownikom modyfikowanie ustawień, powtarzanie odpowiedzi, usuwanie wcześniejszych interakcji i ostatecznie wyłonienie zwycięzcy.

Podczas gdy różnorodność modeli dostępności modeli językowych (LLM) dostępnych w tym konkretnym ustawieniu jest nieco ograniczona, użytkownicy mają możliwość wyboru spośród kilku różnych iteracji Llama 2, Vicuna i ChatGLM. Niestety, obecnie bardzo poszukiwane LLM, takie jak GPT-4, GPT-3.5, Claude 1 i Claude 2 nie są oferowane w tym kontekście. Niemniej jednak, intencją Chatbot Arena jest włączenie tych modeli w przyszłości.

Porównaj LLM za pomocą Chatbot Arena

Chatbot Arena stanowi doskonałą okazję dla osób, które chcą zidentyfikować i ocenić odpowiednie chatboty dostosowane do ich konkretnych wymagań, a także dla tych, którzy są zainteresowani badaniem różnych dużych modeli językowych poprzez testowanie.

Platforma oferuje skuteczne środki do równoległego porównywania wielu modeli językowych. Co więcej, utrzymując system rankingowy zależny od danych wprowadzanych przez użytkownika, można łatwo zapoznać się z pozycją różnych modeli, bez konieczności osobistego przeprowadzania ocen.