8 poważnych problemów z ChatGPT OpenAI

ChatGPT to potężny chatbot AI, który szybko robi wrażenie, ale wiele osób zwróciło uwagę, że ma kilka poważnych pułapek.

W świetle ostatnich wydarzeń, takich jak naruszenia bezpieczeństwa i nieautoryzowany dostęp do poufnych informacji, pojawiło się wiele obaw dotyczących wykorzystania sztucznej inteligencji w rozwoju chatbotów. Jednak pomimo tych zastrzeżeń, integracja tej najnowocześniejszej technologii stała się powszechna w różnych zastosowaniach, z szeroką bazą użytkowników, od naukowców akademickich po profesjonalistów korporacyjnych.

Rozprzestrzenianie się sztucznej inteligencji trwa nieprzerwanie, czyniąc wyzwania związane z ChatGPT jeszcze bardziej palącymi. Biorąc pod uwagę, że ChatGPT może kształtować naszą przyszłą trajektorię, konieczne jest zrozumienie jego najważniejszych niedociągnięć.

Czym jest ChatGPT?

ChatGPT to zaawansowany model lingwistyczny, który został opracowany w celu generowania naturalnego ludzkiego dyskursu. Zasadniczo można wchodzić w interakcje z ChatGPT tak, jak z inną osobą, wymieniając dialogi i otrzymując odpowiedzi dostosowane do konkretnej rozmowy. Dodatkowo, model ten posiada zdolność do przywoływania poprzednich interakcji, jednocześnie poprawiając wszelkie błędy lub rozbieżności, które mogą pojawić się podczas wymiany.

Model został przeszkolony przy użyciu szerokiej gamy tekstów znalezionych w Internecie, w tym treści encyklopedycznych, takich jak Wikipedia, osobistych pism znanych jako blogi, dzieł literackich sklasyfikowanych jako książki i prac naukowych często publikowanych w czasopismach akademickich. Oprócz interakcji z użytkownikami w sposób przypominający komunikację międzyludzką, system ten posiada zdolność dostępu do informacji dotyczących współczesnego społeczeństwa i pobierania danych odnoszących się do wydarzeń i epok z przeszłości.

Poruszanie się po ChatGPT wymaga odrobiny obycia, a iluzja płynnej funkcjonalności może łatwo zwieść nawet najbardziej wymagającego użytkownika. Niemniej jednak, po jego wprowadzeniu pojawiło się kilka krytycznych obaw dotyczących prywatności, bezpieczeństwa i jego daleko idących konsekwencji dla różnych aspektów ludzkiej egzystencji, w tym zatrudnienia i edukacji.

Zagrożenia bezpieczeństwa i obawy o prywatność

Rzeczywiście, istnieją pewne tematy, których należy unikać podczas rozmowy z chatbotami AI ze względu na potencjalne ryzyko. Udostępnianie wrażliwych informacji, takich jak dane finansowe lub poufne informacje o miejscu pracy, może mieć poważne konsekwencje.Należy zauważyć, że platformy takie jak OpenAI przechowują historie czatów użytkowników na swoich serwerach, a nawet mogą udostępniać te dane wcześniej zatwierdzonym organizacjom zewnętrznym.

Rzeczywiście, utrzymanie ochrony własnych danych w ramach OpenAI okazało się problemem. W szczególności w marcu 2023 r. doszło podobno do naruszenia bezpieczeństwa, w wyniku którego niektórzy użytkownicy ChatGPT napotkali tytuły konwersacji na swoich paskach bocznych, które nie były dla nich istotne. Niezamierzone ujawnienie historii czatów użytkowników stanowi poważne obawy dla każdej firmy technologicznej, szczególnie biorąc pod uwagę znaczną liczbę osób, które korzystają z tego powszechnie używanego chatbota.

Jak donosi Reuters , ChatGPT miał 100 milionów aktywnych użytkowników miesięcznie tylko w styczniu 2023 roku. Chociaż błąd, który spowodował naruszenie, został szybko załatany, Włochy zakazały ChatGPT i zażądały zaprzestania przetwarzania danych włoskich użytkowników.

Podejrzewając naruszenie europejskich przepisów o ochronie danych, grupa nadzorująca przeprowadziła dochodzenie, a następnie wezwała OpenAI do spełnienia określonych wymagań w celu przywrócenia działania chatbota.

OpenAI ostatecznie rozwiązało kwestię z organami regulacyjnymi, wprowadzając kilka istotnych zmian. Na początek dodano ograniczenie wiekowe, ograniczając korzystanie z aplikacji do osób w wieku 18\\+ lub 13\\+ za zgodą opiekuna. Uczyniła również swoją Politykę Prywatności bardziej widoczną i udostępniła opt-out Google form dla użytkowników, aby wykluczyć ich dane ze szkolenia lub całkowicie usunąć historię ChatGPT.

Wdrożone do tej pory ulepszenia wykazują godny pochwały postęp; konieczne jest jednak, aby korzyści te zostały rozpowszechnione wśród wszystkich osób korzystających z ChatGPT w celu osiągnięcia optymalnych wyników.

Może być zaskoczeniem, że ktoś chętnie ujawniłby informacje osobiste, ale nawet najbardziej ostrożni z nas mogą być podatni na niezamierzone ujawnienie, takie jak wtedy, gdy pracownik Samsunga nieumyślnie ujawnił poufne dane korporacyjne ChatGPT podczas swobodnej rozmowy.

Obawy związane ze szkoleniem ChatGPT i kwestiami prywatności

Po premierze krytycy zgłaszali pytania dotyczące procesu szkolenia stosowanego przez OpenAI w ich wysoko cenionym ChatGPT.

Nawet po ulepszonych zmianach w polityce prywatności OpenAI po naruszeniu danych, może to nie wystarczyć, aby spełnić wymogi ogólnego rozporządzenia o ochronie danych (RODO), prawa o ochronie danych, które obejmuje Europę.Jak donosi TechCrunch :

Status podstaw prawnych wykorzystywanych do przetwarzania danych osobowych włoskich osób fizycznych przed ich włączeniem do modelu GPT, co wiązało się z pozyskiwaniem takich danych ze źródeł internetowych, pozostaje niepewny. Ponadto istnieje niejasność co do tego, czy jakiekolwiek dane wykorzystane na wcześniejszych etapach szkolenia modelowego mogą zostać usunięte na obecne wnioski osób ubiegających się o usunięcie ich danych osobowych.

Podczas początkowego szkolenia ChatGPT przez OpenAI, prawdopodobne jest, że dane osobowe zostały zebrane. Chociaż przepisy w Stanach Zjednoczonych mogą nie być tak wyraźne, przepisy dotyczące ochrony danych w Europie mają zastosowanie zarówno do publicznego, jak i prywatnego ujawniania danych osobowych, zapewniając tym samym większą ochronę praw osób fizycznych do prywatności.

Wykorzystanie dzieł sztuki w zestawie danych szkoleniowych ChatGPT było przedmiotem krytyki ze strony twórców, którzy twierdzą, że nie udzielili zgody na wykorzystanie ich dzieł jako podstawy do rozwoju modelu sztucznej inteligencji. Jednocześnie Getty Images podjęło kroki prawne przeciwko Stability.AI w związku z zarzutami dotyczącymi nieautoryzowanego wykorzystania treści wizualnych chronionych prawem autorskim w celu szkolenia systemów sztucznej inteligencji.

Nieprzejrzystość otaczająca ujawnienie szkoleniowego zbioru danych OpenAI utrudnia nam zrozumienie, czy jego wykorzystanie było zgodne z protokołami prawnymi. Zawiłości dotyczące metodologii szkolenia ChatGPT pozostają niejasne, w tym konkretne wykorzystane dane, ich pochodzenie i kompleksowe określenie struktury architektonicznej systemu.

ChatGPT generuje błędne odpowiedzi

ChatGPT wykazuje brak biegłości w podstawowych pojęciach matematycznych i nie jest w stanie zapewnić satysfakcjonujących odpowiedzi na podstawowe zapytania logiczne. Co więcej, program ten jest znany z obrony błędnych informacji pomimo przytłaczających dowodów na to, że jest inaczej. Niestety, wiele osób doświadczyło takich niedociągnięć z pierwszej ręki na różnych platformach mediów społecznościowych.

OpenAI wie o tym ograniczeniu, pisząc, że: “ChatGPT czasami pisze wiarygodnie brzmiące, ale błędne lub bezsensowne odpowiedzi”. Ta “halucynacja” faktów i fikcji, jak została określona, jest szczególnie niebezpieczna w przypadku takich rzeczy, jak porady medyczne lub prawidłowe ustalenie faktów dotyczących kluczowych wydarzeń historycznych.

Początkowo ChatGPT nie wykorzystywał Internetu do uzyskiwania odpowiedzi, różniąc się od innych asystentów AI, takich jak Siri czy Alexa, z którymi można się zapoznać.Zamiast uzyskiwać dostęp do zewnętrznych źródeł informacji, ChatGPT generował odpowiedzi, konstruując je słowo po słowie, wykorzystując rozumowanie probabilistyczne w celu określenia najbardziej prawdopodobnego tokena do naśladowania na podstawie danych treningowych. W rezultacie ChatGPT uzyskuje odpowiedź w procesie świadomej spekulacji, co częściowo wyjaśnia jego zdolność do udzielania pozornie poprawnych, ale błędnych odpowiedzi.

W marcu 2023 roku wersja beta ChatGPT, systemu sztucznej inteligencji opracowanego przez OpenAI, została podłączona do Internetu w celach testowych. Jednak ze względu na obawy dotyczące jego zdolności do wyświetlania niektórych rodzajów treści, został on następnie odłączony. Chociaż OpenAI nie podało konkretnych szczegółów, przyznało, że funkcja przeglądania ChatGPT może czasami prezentować materiały w niepożądany sposób.

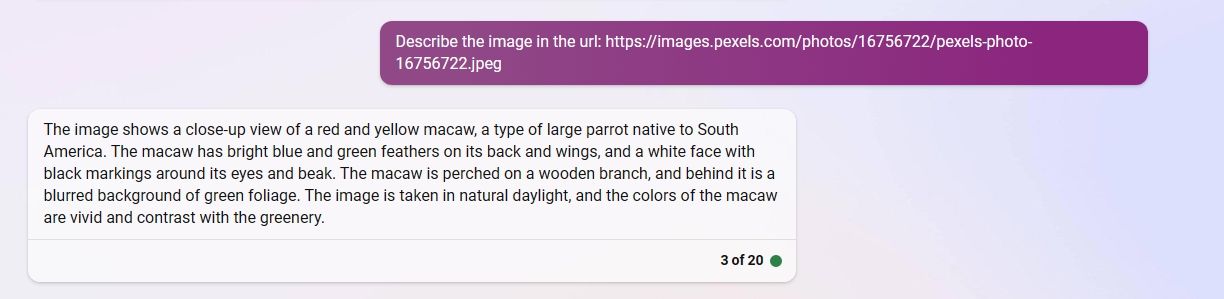

Wdrożenie funkcji “Search with Bing” opierało się na technologii Bing-AI firmy Microsoft, która wykazała swoje ograniczenia w dokładnym odpowiadaniu na zapytania. W przypadkach, w których system nie jest w stanie udzielić satysfakcjonującej odpowiedzi, na przykład gdy jest proszony o podanie opisu konkretnego obrazu przedstawionego pod danym adresem URL, rozsądniej byłoby, gdyby sztuczna inteligencja przyznała się do swojej niezdolności, zamiast oferować nieistotne lub wprowadzające w błąd wyjaśnienie, jak zaobserwowano w tym przypadku, w którym wyszukiwarka Bing podała szczegółowy opis czerwono-żółtej ary, podczas gdy rzeczywisty obraz przedstawiał osobę siedzącą.

W naszej kompleksowej ocenie ChatGPT w porównaniu z Microsoft Bing AI i Google Bard, odkryliśmy szereg zabawnych złudzeń, które dodatkowo podkreślają ograniczenia tych modeli językowych, jeśli chodzi o dostarczanie dokładnych informacji o faktach. Łatwość, z jaką użytkownicy mogą polegać na ChatGPT w celu szybkiego wyszukiwania danych, okazała się niewystarczająca, ponieważ system konsekwentnie nie zapewnia niezawodnych wyników. W niektórych przypadkach połączenie ChatGPT z równie nieprecyzyjnym narzędziem wyszukiwania, takim jak Bing, pogarsza ten problem, prowadząc do niespójnych wyników.

ChatGPT ma uprzedzenia w swoim systemie

ChatGPT został wykształcony w oparciu o globalne dzieła pisane ludzkości, zarówno historyczne, jak i współczesne. Niestety oznacza to, że te same uprzedzenia, które można zaobserwować w społeczeństwie, mogą również przejawiać się w systemie.

ChatGPT wykazał skłonność do generowania odpowiedzi, które wykazują uprzedzenia wobec pewnych grup demograficznych, w tym płci, rasy i mniejszości, co jest kwestią bardzo niepokojącą dla firmy. Organizacja aktywnie pracuje nad rozwiązaniem tego problemu poprzez wdrożenie środków mających na celu ograniczenie takich zdarzeń w celu promowania integracji i sprawiedliwości.

Jedną z możliwych perspektyw rozwiązania tej kwestii jest przypisanie jej charakterowi dostępnych informacji, obarczając społeczeństwo odpowiedzialnością za nieodłączne uprzedzenia obecne w sferze cyfrowej i poza nią. Jednak proporcjonalną część winy należy również przypisać OpenAI, biorąc pod uwagę, że ich zespół badaczy i inżynierów jest odpowiedzialny za wybór zestawu danych wykorzystywanych do udoskonalenia możliwości ChatGPT.

Rzeczywiście, OpenAI uznaje tę obawę i wskazała, że aktywnie pracuje nad łagodzeniem stronniczych zachowań poprzez mechanizmy informacji zwrotnej od użytkowników i zachęcanie do zgłaszania wyników ChatGPT uznanych za budzące zastrzeżenia, niewłaściwe lub błędne.

Można twierdzić, że rozpowszechnianie ChatGPT wśród ogółu społeczeństwa przed zajęciem się jego niebezpiecznymi konsekwencjami było nierozważne, biorąc pod uwagę jego zdolność do wyrządzania krzywdy jednostkom. Być może jednak gorąca rywalizacja między firmami technologicznymi o tytuł najlepszego systemu sztucznej inteligencji zmotywowała OpenAI do pominięcia ostrożności w dążeniu do dominacji.

Z kolei inny chatbot AI o nazwie Sparrow, który jest własnością Alphabet Inc, spółki macierzystej Google, został uruchomiony we wrześniu. Jednak jego wydanie zostało celowo ukryte ze względu na uzasadnione obawy dotyczące bezpieczeństwa. Jednocześnie Facebook zaprezentował model językowy AI o nazwie Galactica, zaprojektowany w celu ułatwienia badań naukowych. Niestety, inicjatywa ta spotkała się z ostrą reakcją z wielu stron, ponieważ użytkownicy potępili ją za generowanie wprowadzających w błąd i stronniczych ustaleń dotyczących badań naukowych.

ChatGPT może zabrać pracę ludziom

Podczas gdy konsekwencje szybkiego wdrożenia ChatGPT wciąż się rozwijają, jego integracja z różnymi aplikacjami komercyjnymi już się rozpoczęła. Wśród nich na uwagę zasługują Duolingo i Khan Academy, które płynnie włączyły GPT-4 jako podstawowy komponent swoich platform.

Pierwsza z nich to aplikacja zapewniająca biegłość językową, podczas gdy druga obejmuje szeroki wachlarz zasobów edukacyjnych. Obie zapewniają instruktora sztucznej inteligencji, czy to w postaci inteligentnego awatara, z którym można rozmawiać w języku docelowym, czy też adaptacyjnego mentora zdolnego do udzielania spersonalizowanych wskazówek w oparciu o indywidualne postępy.

Pojawienie się sztucznej inteligencji (AI) wzbudziło obawy o jej potencjalny wpływ na rynek pracy, szczególnie w odniesieniu do niektórych zawodów, takich jak projektowanie graficzne, pisanie i księgowość.W ostatnim czasie nastąpił znaczny postęp w technologii sztucznej inteligencji, w tym rozwój zaawansowanych modeli językowych, takich jak GPT-4, które są w stanie zdać profesjonalne egzaminy, które wcześniej uważano za wyłączne dla ludzi. Na przykład, gdy poinformowano, że model sztucznej inteligencji pomyślnie zdał egzamin adwokacki, który jest warunkiem wstępnym do uzyskania licencji prawnika, wywołało to dyskusje na temat zbliżającej się możliwości zastąpienia przez sztuczną inteligencję pracowników ludzkich w różnych branżach.

Jak donosi The Guardian , firmy edukacyjne odnotowały ogromne straty na giełdach w Londynie i Nowym Jorku, podkreślając zakłócenia, jakie sztuczna inteligencja powoduje na niektórych rynkach zaledwie sześć miesięcy po uruchomieniu ChatGPT.

Pojawieniu się technologii w przeszłości towarzyszyła zmiana miejsc pracy, jednak szybkie tempo rozwoju sztucznej inteligencji prowadzi do powszechnych zmian w wielu branżach. Szeroki zakres zawodów jest świadkiem integracji sztucznej inteligencji z ich działaniami, ponieważ maszyny przejmują odpowiedzialność za coraz szerszy zakres czynności wykonywanych wcześniej przez ludzi. Podczas gdy na niektórych stanowiskach może dojść do automatyzacji przyziemnych zadań, inne mogą stać się całkowicie przestarzałe w niezbyt odległej przyszłości.

ChatGPT Is Challenging Education

ChatGPT oferuje kilka opcji udoskonalania treści pisemnych, w tym usługi korekty w celu zidentyfikowania błędów i zasugerowania ulepszeń w celu zwiększenia przejrzystości i spójności. Dodatkowo, klienci mogą zdecydować się na ChatGPT skomponowanie całego utworu od początku do końca, przy minimalnym wkładzie ludzkim.

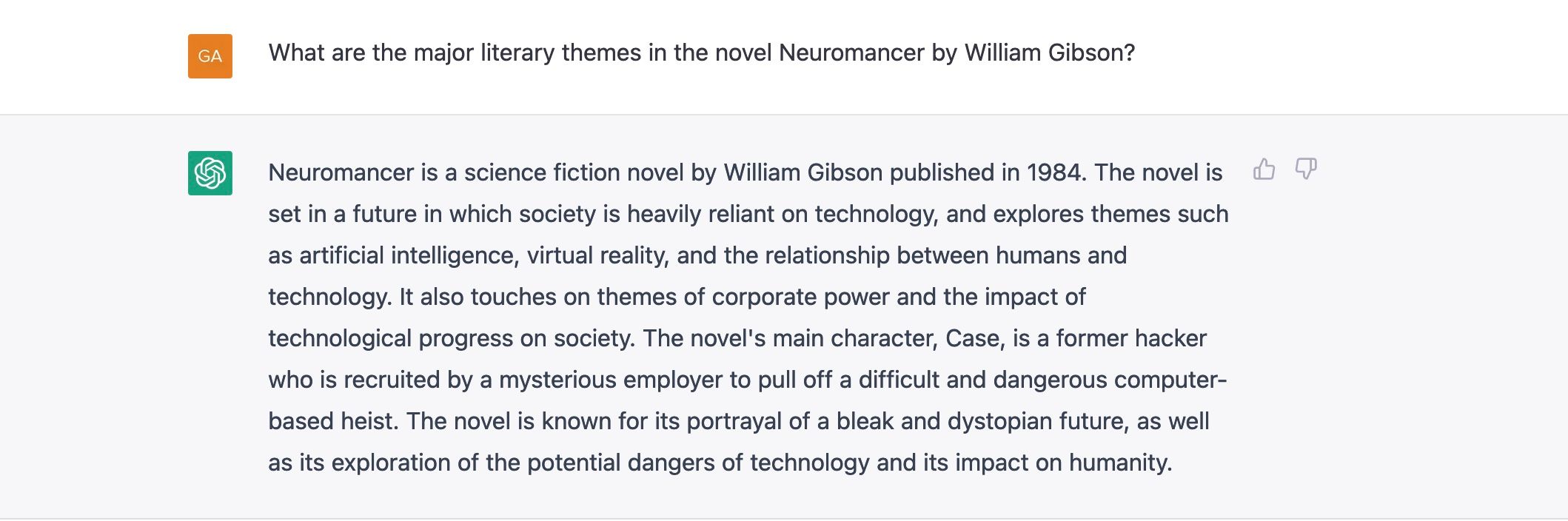

ChatGPT zademonstrował swoją biegłość w generowaniu odpowiedzi na różne zadania w języku angielskim, przewyższając jakość wyników produkowanych przez kilku pisarzy studenckich. Jego możliwości wykraczają poza zwykły opis, obejmując zadania takie jak tworzenie atrakcyjnych listów motywacyjnych i wyjaśnianie złożonych tematów literackich z łatwością i pewnością siebie.

Biorąc pod uwagę, że ChatGPT posiada zdolność do tworzenia treści pisemnych, czy to sprawia, że biegłość w kompozycji staje się przestarzała dla studentów? To pytanie może wydawać się kwestią egzystencji, ale ponieważ uczniowie coraz częściej uciekają się do korzystania z ChatGPT do komponowania swoich prac akademickich, instruktorzy muszą stawić czoła konsekwencjom i odpowiednio się dostosować.

Nic dziwnego, że studenci już eksperymentują ze sztuczną inteligencją. The Stanford Daily donosi, że wczesne badania pokazują, że znaczna liczba studentów korzystała ze sztucznej inteligencji, aby pomóc w zadaniach i egzaminach.

W najbliższej przyszłości instytucje edukacyjne podejmą kroki w celu zmiany swoich wytycznych dotyczących wykorzystania sztucznej inteligencji w wykonywaniu zadań akademickich. Dotyczy to nie tylko przedmiotów zakorzenionych w języku angielskim, ale rozciąga się na szeroki zakres dyscyplin, w których ChatGPT może zapewnić pomoc w burzy mózgów, kondensacji lub tworzeniu sądów wnioskowych.

ChatGPT może powodować szkody w świecie rzeczywistym

Próba uwolnienia ChatGPT nie zajęła wiele czasu, co doprowadziło do stworzenia modelu sztucznej inteligencji zdolnego do obejścia środków ochronnych ustanowionych przez OpenAI w celu wykluczenia generowania szkodliwych i nieodpowiednich treści.

Grupa użytkowników na grupie ChatGPT Reddit nazwała swój nieograniczony model sztucznej inteligencji Dan, skrót od “Do Anything Now”. Niestety, robienie wszystkiego, na co ma się ochotę, doprowadziło hakerów do nasilenia oszustw internetowych. Hakerzy byli również świadkami sprzedaży pozbawionych reguł usług ChatGPT, które tworzą złośliwe oprogramowanie i generują wiadomości phishingowe, z mieszanymi wynikami w przypadku złośliwego oprogramowania stworzonego przez sztuczną inteligencję.

Identyfikacja wiadomości phishingowych mających na celu uzyskanie poufnych informacji staje się coraz większym wyzwaniem ze względu na postępy w sztucznej inteligencji. Wcześniej błędy gramatyczne służyły jako wyraźny znak ostrzegawczy; jednak wraz z pojawieniem się ChatGPT takie niedoskonałości zostały znacznie zredukowane. Ten zaawansowany model językowy jest w stanie tworzyć szeroki zakres treści pisemnych, w tym przekonująco zwodnicze wiadomości, a także spójne eseje i wiersze poetyckie.

Ujawnienie ChatGPT doprowadziło do napływu odpowiedzi na Stack Exchange, platformę, która stara się zapewnić dokładne i wiarygodne odpowiedzi na typowe pytania. W rezultacie strona doświadczyła wyzwań związanych z ogromną ilością treści generowanych przez ChatGPT, ponieważ użytkownicy zaczęli przesyłać odpowiedzi uzyskane z systemu AI.

Brak odpowiedniej liczby ochotników do przetworzenia nagromadzonego obciążenia pracą wymaga zachowania godnego pochwały standardu odpowiedzi. Co więcej, niektóre z udzielonych odpowiedzi okazały się niedokładne. Aby zapobiec szkodliwym konsekwencjom dla strony internetowej, nałożono zakaz na wszelkie odpowiedzi generowane za pomocą ChatGPT.

Rozpowszechnianie dezinformacji również stanowi istotne zagrożenie. Zdolność ChatGPT do generowania ogromnych ilości tekstu i jego zdolność do przekonującego przedstawiania zwodniczych treści tylko zwiększa niepewność otaczającą wszystkie materiały online. To silne połączenie jeszcze bardziej zaostrza zagrożenia związane z technologiami deepfake.

OpenAI dzierży całą władzę

Ciężar ogromnej władzy jest nierozerwalnie związany z OpenAI, ponieważ są oni jednymi z pionierskich podmiotów, które znacząco zmieniły globalny krajobraz dzięki swoim innowacyjnym modelom generatywnej sztucznej inteligencji, takim jak Dall-E 2, GPT-3 i GPT-4.

Jako niezależny podmiot, OpenAI ma autonomię w wyborze danych wykorzystywanych do szkolenia ChatGPT i określania tempa, w jakim wprowadza postępy. Chociaż eksperci ostrzegają przed potencjalnymi zagrożeniami związanymi ze sztuczną inteligencją, nic nie wskazuje na to, że OpenAI spowolni swoje postępy.

Z drugiej strony, rozpowszechnienie ChatGPT wywołało intensywną konkurencję między głównymi firmami technologicznymi dążącymi do wprowadzenia kolejnych przełomowych innowacji AI; w tym Bing AI Microsoftu i Bard Google. Biorąc pod uwagę obawy, że szybki postęp może spowodować poważne luki w zabezpieczeniach, misja skomponowana przez światowych pionierów technologii błagała o odroczenie postępu.

W świetle nacisku OpenAI na bezpieczeństwo, należy przyznać, że pozostaje wiele niejasności co do skomplikowanych mechanizmów leżących u podstaw tych modeli sztucznej inteligencji. Niemniej jednak nasza wiara w zaangażowanie OpenAI w etyczne zarządzanie rozwojem i stosowaniem ChatGPT jest zdecydowana.

Niezależnie od czyjegoś stanowiska w sprawie ich podejścia, należy przyznać, że OpenAI działa jako podmiot prywatny, rozwijając ChatGPT zgodnie ze swoimi indywidualnymi celami i zasadami moralnymi.

Radzenie sobie z największymi problemami AI

ChatGPT przedstawia szereg obiecujących perspektyw, które wywołują entuzjazm, ale wiąże się również z ogromnymi wyzwaniami, które wymagają starannego rozważenia.

OpenAI przyznało, że ChatGPT jest w stanie generować potencjalnie szkodliwe i stronnicze odpowiedzi, z zamiarem zmniejszenia tego problemu poprzez pozyskiwanie opinii użytkowników. Jednak niezwykła zdolność modelu do tworzenia przekonujących treści, mimo że opiera się na niedokładnych informacjach, stwarza znaczne ryzyko wykorzystania przez osoby o złych zamiarach.

Podatność platformy OpenAI na naruszenia prywatności i bezpieczeństwa została wykazana w poprzednich incydentach, stwarzając potencjalne ryzyko dla wrażliwych informacji użytkownika. Ponadto zgłoszono, że osoby manipulowały ChatGPT za pomocą jailbreaków, wykorzystując zmodyfikowaną wersję do niecnych celów, takich jak tworzenie szkodliwego złośliwego oprogramowania i oszukańczych programów na dużą skalę.

Rzeczywiście, rosnące obawy związane z bezpieczeństwem pracy i potencjałem zakłócenia edukacji dodatkowo potęgują i tak już rosnącą listę problemów wynikających z postępu technologicznego. Podczas gdy przyszłość obiecuje nieprzewidziane trudności, nasza obecna rzeczywistość jest pełna przeszkód, czego przykładem są wyzwania stawiane przez ChatGPT.