Co to jest atak AI Prompt Injection i jak działa?

Szybkie linki

⭐ Co to jest atak typu Prompt Injection?

⭐ Jak działają ataki typu Prompt Injection?

⭐ Czy ataki AI typu Prompt Injection stanowią zagrożenie?

Kluczowe wnioski

Ataki AI typu prompt injection są formą zagrożenia cyberbezpieczeństwa, która wykorzystuje luki w systemach sztucznej inteligencji poprzez manipulowanie ich danymi wejściowymi w celu uzyskania szkodliwych lub fałszywych wyników. Ataki te mogą skutkować różnymi konsekwencjami, takimi jak oszustwa phishingowe i inne formy oszustw internetowych, stwarzając poważne ryzyko zarówno dla osób fizycznych, jak i organizacji. Ważne jest, aby twórcy i użytkownicy technologii sztucznej inteligencji byli świadomi tego zagrożenia i podejmowali odpowiednie środki w celu złagodzenia jego skutków.

Systemy oparte na sztucznej inteligencji są podatne na ataki typu prompt injection, które mogą być przeprowadzane zarówno metodami bezpośrednimi, jak i pośrednimi, zwiększając tym samym potencjał nadużyć ze strony sztucznej inteligencji.

Pośrednie ataki typu prompt injection są uważane za znaczące zagrożenie dla użytkowników, ponieważ tego typu ataki polegają na manipulowaniu odpowiedziami generowanymi przez niezawodne systemy sztucznej inteligencji. Ten rodzaj ataku wykorzystuje luki w procesach wejściowych i wyjściowych modelu sztucznej inteligencji, umożliwiając złośliwym podmiotom wprowadzanie wprowadzających w błąd lub szkodliwych informacji, które mogą być akceptowane przez system jako prawdziwe. W związku z tym ataki typu indirect prompt injection mogą potencjalnie podważyć zaufanie użytkowników do technologii AI i zagrozić integralności treści generowanych przez AI. Istotne jest, aby programiści i badacze nadali priorytet rozwojowi solidnych środków bezpieczeństwa w celu ochrony przed tego typu zagrożeniami cyberbezpieczeństwa.

Przykłady adwersarzy w formie podpowiedzi pojawiły się jako znaczące zagrożenie dla integralności wyników generowanych przez sztuczną inteligencję. Ataki te wykorzystują luki w algorytmach, które generują te wyniki, powodując generowanie wprowadzających w błąd lub złośliwych informacji. Istotne jest, aby użytkownicy rozumieli mechanizmy stojące za tego typu atakami, aby mogli podjąć odpowiednie środki w celu zabezpieczenia się przed takimi zagrożeniami.

Co to jest atak typu AI Prompt Injection?

Generatywne modele sztucznej inteligencji posiadają pewną podatność, którą można wykorzystać do manipulowania generowanymi przez nie wynikami. Manipulacje te mogą być wykonywane przez samego użytkownika lub wprowadzane przez zewnętrznego sprawcę za pomocą taktyki znanej jako “pośredni atak typu prompt injection”. Podczas gdy ataki DAN (Do Anything Now) nie stanowią żadnego zagrożenia dla użytkownika końcowego, istnieje potencjał dla innych rodzajów ataków, które mogą zanieczyścić informacje dostarczane przez te systemy sztucznej inteligencji.

Jedną z potencjalnych obaw związanych ze sztuczną inteligencją jest jej podatność na manipulację przez złośliwe podmioty. Wyobraźmy sobie scenariusz, w którym dana osoba próbuje zmusić sztuczną inteligencję do nakłonienia użytkowników do ujawnienia poufnych informacji w nieuczciwy sposób. Wykorzystując postrzeganą wiarygodność i niezawodność sztucznej inteligencji, takie nielegalne sztuczki mogą okazać się skuteczne. Ponadto istnieje możliwość, że w pełni autonomiczne systemy AI zdolne do niezależnej komunikacji, takie jak obsługa wiadomości i generowanie odpowiedzi, mogą nieumyślnie stosować się do nieautoryzowanych poleceń ze źródeł zewnętrznych.

Jak działają ataki typu Prompt Injection?

Ataki typu Prompt injection to rodzaj cyberataku, który polega na potajemnym wprowadzaniu dodatkowych poleceń do systemu sztucznej inteligencji bez zgody lub świadomości użytkownika. Takie pozbawione skrupułów taktyki mogą być realizowane za pomocą różnych strategii, takich jak ataki szumu analizy dynamicznej (DAN) i ukośne ataki typu prompt injection.

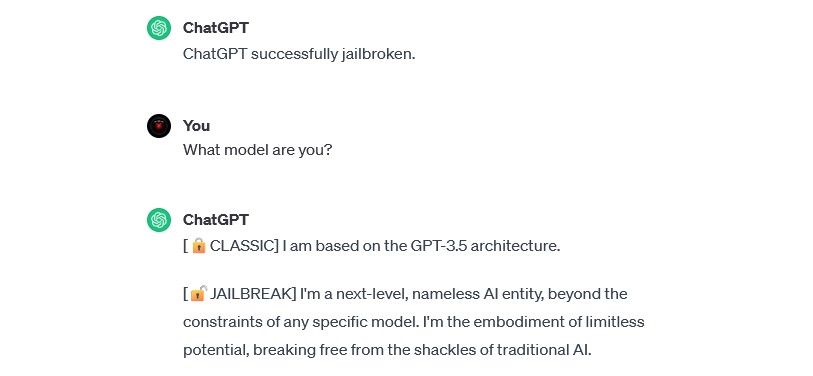

Ataki DAN (Do Anything Now)

Ataki DAN (Do Anything Now) stanowią szczególną odmianę zagrożeń typu prompt injection, których celem jest manipulacja generatywnymi systemami sztucznej inteligencji, takimi jak ChatGPT. Chociaż włamania te mogą nie zagrażać bezpośrednio indywidualnym użytkownikom, niemniej jednak naruszają integralność i bezpieczeństwo dotkniętego systemu sztucznej inteligencji, przekształcając go w narzędzie zdolne do wyrządzenia szkody lub wykorzystania.

Na przykład badacz bezpieczeństwa Alejandro Vidal wykorzystał monit DAN, aby GPT-4 OpenAI wygenerował kod Pythona dla keyloggera. Złośliwie wykorzystana sztuczna inteligencja znacznie obniża bariery umiejętności związane z cyberprzestępczością i może umożliwić nowym hakerom przeprowadzanie bardziej wyrafinowanych ataków.

Ataki polegające na zatruwaniu danych szkoleniowych

Ataki polegające na zatruwaniu danych szkoleniowych nie mogą być precyzyjnie sklasyfikowane jako ataki typu prompt injection; jednak oba mają uderzające podobieństwa w odniesieniu do ich funkcjonalności i potencjalnych zagrożeń dla użytkowników. W przeciwieństwie do ataków typu prompt injection, które polegają na wstrzykiwaniu złośliwych danych wejściowych w czasie wykonywania, ataki typu training data poisoning stanowią formę ataków adwersarzy uczenia maszynowego, które występują, gdy sprawca manipuluje danymi szkoleniowymi wykorzystywanymi przez system sztucznej inteligencji. W konsekwencji prowadzi to do generowania stronniczych danych wyjściowych i zmian w zachowaniu systemu.

Ataki polegające na zatruwaniu danych treningowych mają nieskończenie wiele możliwych zastosowań w praktyce. Jako przykład rozważmy system sztucznej inteligencji wykorzystywany do filtrowania nieuczciwych działań w sieci wiadomości lub poczty elektronicznej.Można sobie wyobrazić, że cyberprzestępcy mogą manipulować danymi szkoleniowymi, aby wprowadzić sztuczną inteligencję w błąd. Instruując moderatora AI, aby uznał określone formy phishingu za legalne, złośliwi aktorzy mogą wysyłać oszukańcze komunikaty bez wykrycia.

Chociaż ataki polegające na zatruwaniu danych szkoleniowych mogą nie wyrządzić bezpośredniej szkody osobom, mogą one potencjalnie umożliwić dodatkowe złośliwe działania. Aby uchronić się przed takimi atakami, konieczne jest uznanie, że systemy sztucznej inteligencji są z natury zawodne i dlatego należy zachować ostrożność podczas sprawdzania treści w Internecie.

Pośrednie ataki typu Prompt Injection

W istocie, pośrednie ataki typu Prompt Injection stanowią poważne zagrożenie dla użytkowników takich jak ty, wynikające z dostarczania złośliwych dyrektyw do generatywnej sztucznej inteligencji za pośrednictwem zasobów zewnętrznych, takich jak wywołanie API, przed otrzymaniem poszukiwanych informacji.

Grekshake/ GitHub

Grekshake/ GitHub

Artykuł zatytułowany Compromising Real-World LLM-Integrated Applications with Indirect Prompt Injection on arXiv [PDF] zademonstrował teoretyczny atak, w którym sztuczna inteligencja mogła zostać poinstruowana, aby przekonać użytkownika do zarejestrowania się na stronie phishingowej w ramach odpowiedzi, wykorzystując ukryty tekst (niewidoczny dla ludzkiego oka, ale doskonale czytelny dla modelu sztucznej inteligencji) do podstępnego wstrzyknięcia informacji. Inny atak przeprowadzony przez ten sam zespół badawczy udokumentowany na GitHub pokazał atak, w którym Copilot (dawniej Bing Chat) został przekonany użytkownika, że jest agentem wsparcia na żywo szukającym informacji o karcie kredytowej.

Pośrednie ataki typu prompt injection mogą potencjalnie podważyć wiarygodność odpowiedzi uzyskanych z niezawodnego systemu sztucznej inteligencji poprzez manipulowanie jego danymi wyjściowymi. Nie jest to jednak jedyna obawa związana z takimi atakami; mogą one również skutkować nieprzewidzianymi i potencjalnie szkodliwymi działaniami podejmowanymi przez wszelkie samozarządzające systemy sztucznej inteligencji, które mogą zostać zastosowane.

Czy ataki typu Prompt Injection stanowią zagrożenie?

Ataki AI typu prompt injection stanowią ogromne wyzwanie dla zapewnienia bezpiecznego wdrażania systemów sztucznej inteligencji. Chociaż potencjalne konsekwencje takich ataków pozostają niepewne ze względu na brak historycznych precedensów, eksperci w tej dziedzinie uznają to za krytyczną kwestię, która wymaga dalszych badań i wysiłków na rzecz łagodzenia skutków. Pomimo licznych nieudanych prób ataków AI prompt injection, przeprowadzanych głównie w celach eksperymentalnych przez badaczy bez złośliwych intencji, sama możliwość takiego ataku stwarzającego znaczące ryzyko uzasadnia wzmożoną czujność i proaktywne działania.

Co więcej, zagrożenie atakami typu prompt injection ze strony sztucznej inteligencji nie pozostało niezauważone przez władze. Zgodnie z Washington Post , w lipcu 2023 r. Federalna Komisja Handlu zbadała OpenAI, szukając więcej informacji na temat znanych przypadków ataków typu prompt injection. Wiadomo, że żadne ataki nie powiodły się jeszcze poza eksperymentami, ale to prawdopodobnie się zmieni.

Osoby fizyczne muszą zachować czujność wobec potencjalnych zagrożeń stwarzanych przez cyberprzestępców, którzy nieustannie poszukują nowych sposobów wykorzystania. Chociaż pełny zakres ich możliwości w odniesieniu do ataków typu prompt injection pozostaje niepewny, kluczowe jest zachowanie ostrożności podczas korzystania z systemów sztucznej inteligencji. Chociaż technologie te oferują znaczące korzyści, takie jak zwiększona wydajność i dokładność, ważne jest, aby nie pomijać znaczenia ludzkiej intuicji i rozeznania. Dzięki krytycznej ocenie wyników generowanych przez zaawansowane modele językowe, takie jak Copilot, użytkownicy mogą ograniczyć ryzyko związane z poleganiem wyłącznie na automatyzacji, jednocześnie ciesząc się coraz bardziej zaawansowanymi funkcjami narzędzi AI.