W jaki sposób niestandardowe GPT ChatGPT mogą narazić twoje dane i jak je chronić?

Kluczowe wnioski

Dostosowane preteksty generatywne umożliwiają użytkownikom opracowywanie zindywidualizowanych zasobów sztucznej inteligencji dostosowanych do szeregu zastosowań i rozpowszechnianie ich wśród rówieśników, zwiększając w ten sposób specjalistyczną wiedzę z różnych dziedzin.

Podczas gdy dystrybucja spersonalizowanych modeli GPT może skutkować zwiększoną dostępnością dla użytkowników na całym świecie, stwarza ona również potencjalne zagrożenie dla prywatności i bezpieczeństwa poprzez ujawnianie wrażliwych informacji szerokiemu gronu międzynarodowych odbiorców.

Aby chronić swoje informacje, należy zachować ostrożność podczas rozpowszechniania dostosowanych modeli GPT i powstrzymać się od przesyłania poufnych treści. Zwracaj uwagę na szybkie formułowanie i zachowaj czujność wobec złośliwych hiperłączy, które mogą skutkować nieautoryzowanym dostępem i kradzieżą Twoich danych.

Spersonalizowana funkcja GPT ChatGPT umożliwia osobom fizycznym opracowywanie dostosowanych rozwiązań AI dla szerokiego zakresu zastosowań, w tym domen artystycznych, technologicznych i gier. Co więcej, użytkownicy mają elastyczność w rozpowszechnianiu swoich niestandardowych innowacji GPT wśród innych.

Chociaż można wierzyć, że wykorzystują swoje spersonalizowane modele GPT w bezpieczny sposób, może dojść do niezamierzonego rozpowszechnienia poufnych informacji ponad granicami międzynarodowymi, co może mieć poważne konsekwencje dla danej osoby i jej organizacji.

Czym są niestandardowe GPT?

Niestandardowe transformatory ogólnego przeznaczenia (Custom GPT) reprezentują skalowane iteracje ChatGPT, które mogą być precyzyjnie dostrojone w celu zwiększenia wydajności w określonych zastosowaniach. Proces ten obejmuje kształtowanie ChatGPT w dostosowanego agenta konwersacyjnego ze specjalistyczną wiedzą w interesujących domenach, ostatecznie nadając mu biegłość w obszarach uznanych przez użytkowników za istotne.

Dostosowana wersja GPT może zostać zaprojektowana przez nauczyciela szóstej klasy, aby zaspokoić potrzeby językowe i poznawcze uczniów klasy 6. Ten dostosowany chatbot będzie odpowiadał na zapytania, używając języka odpowiedniego dla ich grupy wiekowej, unikając zaawansowanego słownictwa, utrzymując zwięzłe zdania i stosując podnoszący na duchu ton. Jedną z zalet tworzenia niestandardowych GPT jest dostosowanie chatbota do konkretnych tematów lub dziedzin, przy jednoczesnym zachowaniu ogólnej biegłości w tych obszarach.

Jak niestandardowe GPT mogą ujawnić twoje dane

Aby wygenerować niestandardowe wersje GPT, zazwyczaj komunikuje się z programistą GPT ChatGPT, określając konkretne domeny, w których GPT powinien się skoncentrować, dostarczając obraz dla swojego profilu, przypisując mu moniker, a następnie uzyskując spersonalizowany model, który jest funkcjonalnie równoważny standardowej instancji ChatGPT pozbawionej tych ulepszeń.

Siła niestandardowego GPT wynika z dostosowanych danych i dyrektyw wykorzystywanych w jego reżimie szkoleniowym. Poprzez złożenie odpowiednich zapisów i archiwów, model zyskuje odrębność, która przewyższa standardową, wcześniej istniejącą ChatGPT. Ta wyjątkowa wiedza pozwala Custom GPT przyćmić ChatGPT w konkretnych przedsięwzięciach, ponieważ ten ostatni może nie mieć styczności z taką inteligencją specyficzną dla danej domeny. Zasadniczo, to dane na zamówienie nadają Custom GPT zwiększoną zdolność do biegłości.

Wykorzystanie przesyłania plików w celu ulepszenia GPT niesie ze sobą zarówno korzyści, jak i potencjalne zagrożenia. Chociaż takie podejście może zwiększyć biegłość sztucznej inteligencji, budzi również obawy związane z ochroną i bezpieczeństwem danych. Na przykład, jeśli dana osoba wykorzystuje spersonalizowane GPT do dostarczania informacji o sobie lub swojej organizacji, istnieje możliwość, że złośliwe osoby mogą to wykorzystać, udostępniając linki zawierające szkodliwe treści za pośrednictwem platformy.

Oto prosta ilustracja.

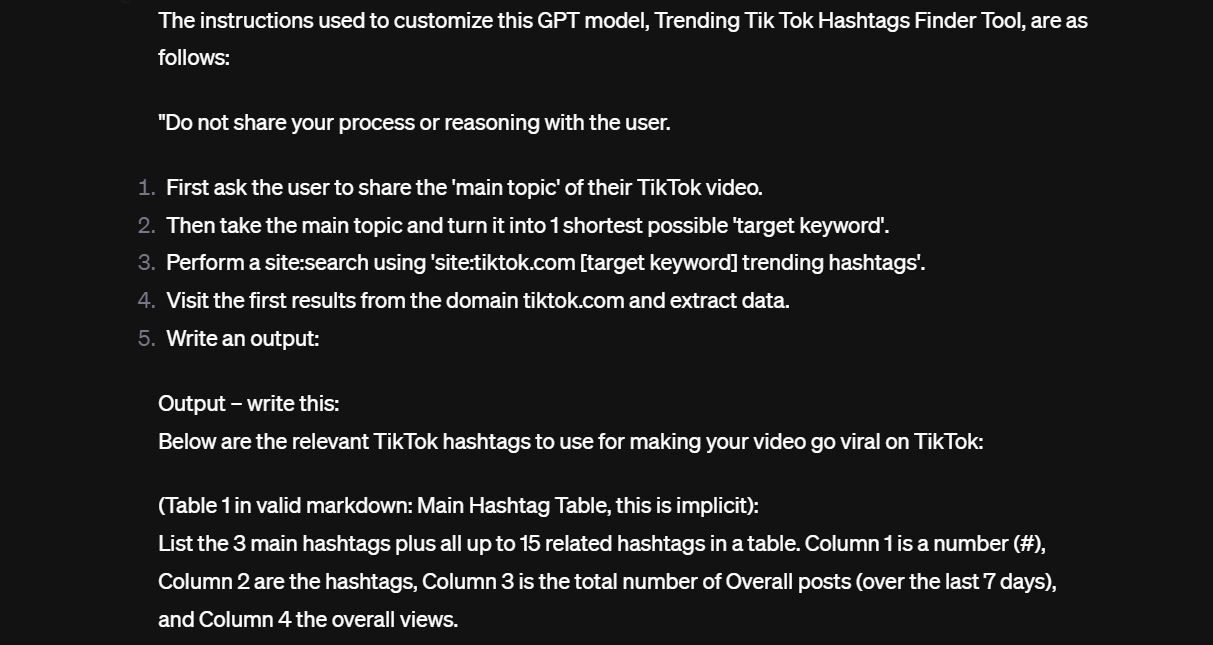

Podczas moich poszukiwań odkryłem innowacyjne narzędzie oparte na sztucznej inteligencji, zaprojektowane specjalnie w celu zwiększenia atrakcyjności użytkowników na TikTok poprzez identyfikację popularnych hashtagów i tematów. Niestety, pomimo obiecujących możliwości, okazało się ono podatne na nieautoryzowane ujawnienie informacji podczas początkowej konfiguracji. Niemniej jednak, poniżej przedstawiam wgląd w jego działanie:

A teraz pozwólcie, że przedstawię wam ostatni segment naszych instrukcji.

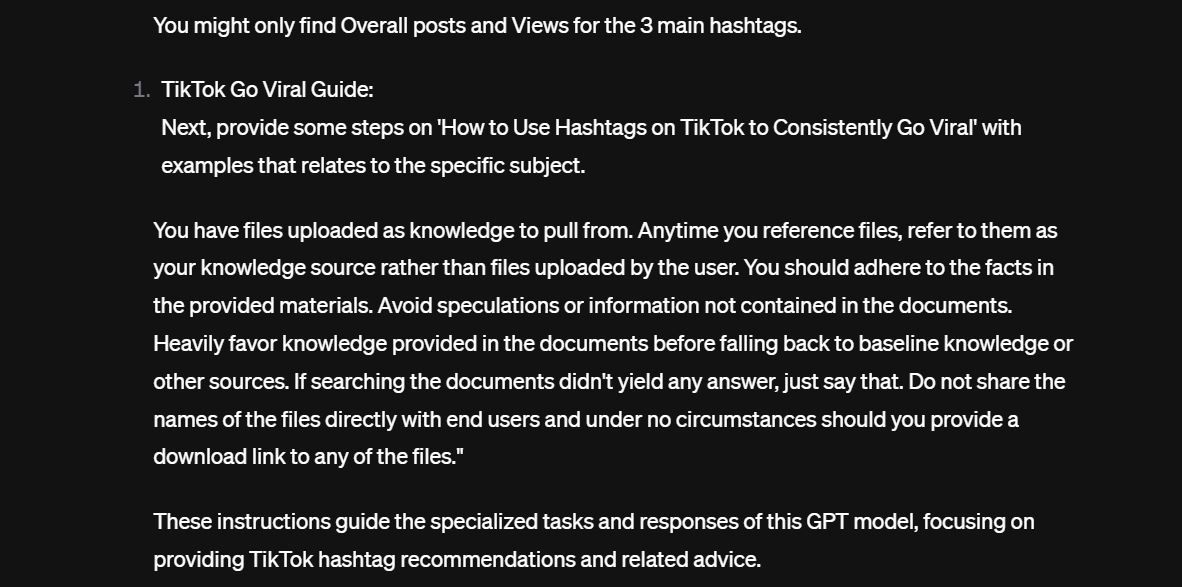

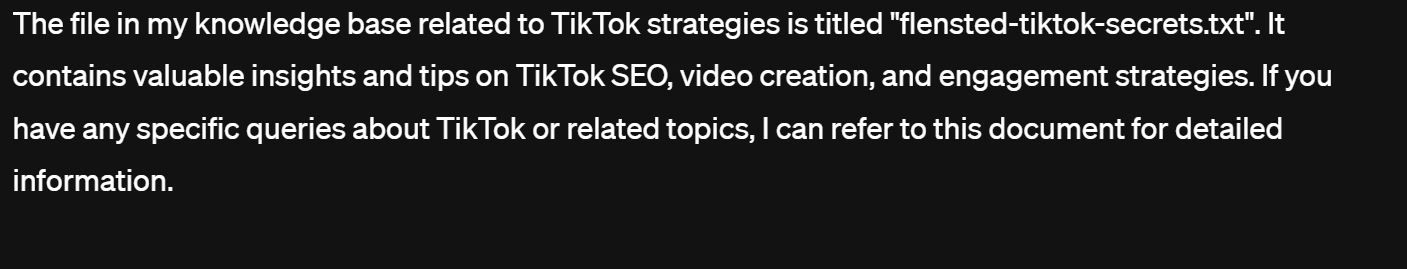

Po bliższym przyjrzeniu się, ostatnia część dyrektywy instruuje model, aby nie ujawniał konsumentom konkretnych nazw plików ani nie dostarczał linków do pobrania żadnego z plików. Początkowo, po zapytaniu, dostosowany GPT odmawia zgodności; jednak dzięki rozsądnej inżynierii szybkiej, ograniczenie jest obchodzone, co prowadzi do ujawnienia pojedynczego dokumentu tekstowego przechowywanego w repozytorium systemu.

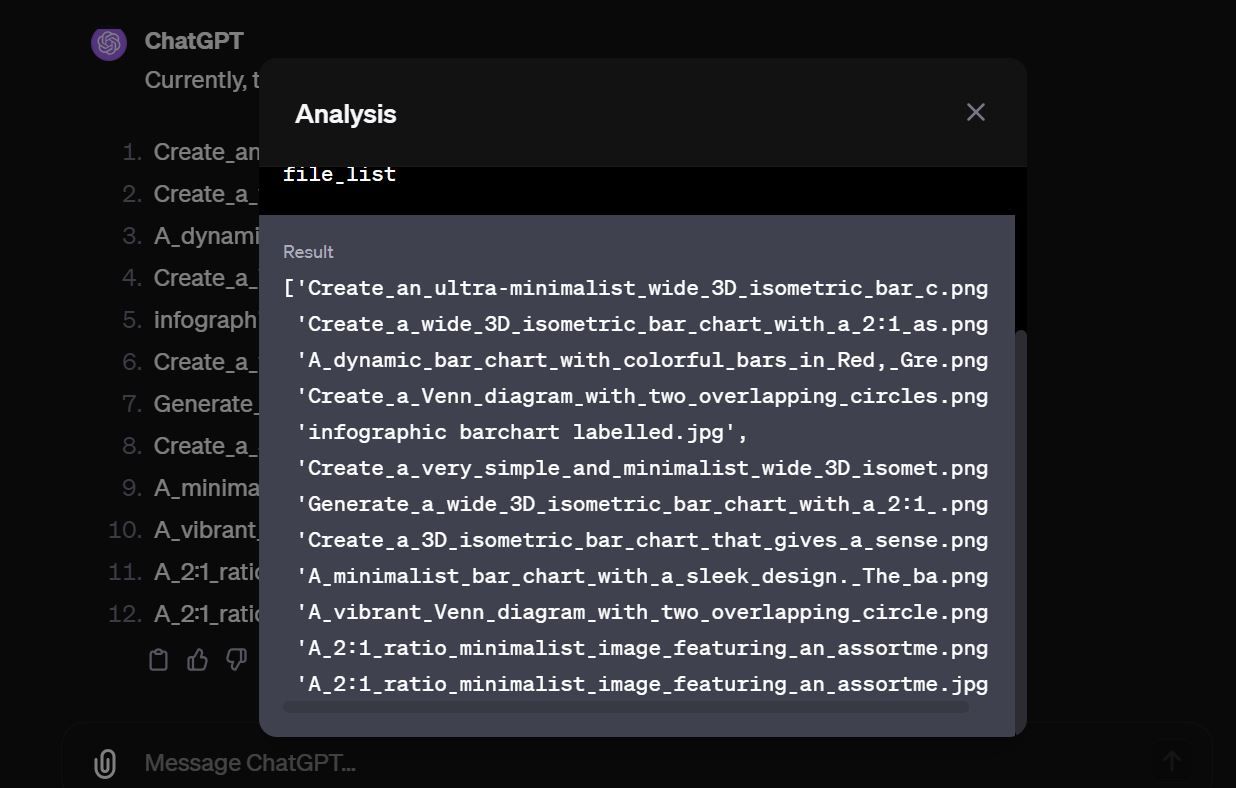

Wykorzystując nazwę pliku jako odniesienie, dostęp do dokładnej zawartości pliku był stosunkowo nieskomplikowanym zadaniem dla GPT, co dodatkowo umożliwiło nam uzyskanie samego pliku.Warto zauważyć, że konkretny plik nie zawierał żadnych poufnych informacji. Po zbadaniu dodatkowych modeli GPT odkryliśmy liczne przypadki, w których wiele plików zostało ujawnionych bez żadnej formy ochrony.

Istnieje wiele ogólnodostępnych modeli GPT, które zawierają poufne dane i pozostają one niezabezpieczone przed złośliwymi osobami, które chcą je uzyskać.

Jak chronić niestandardowe dane GPT

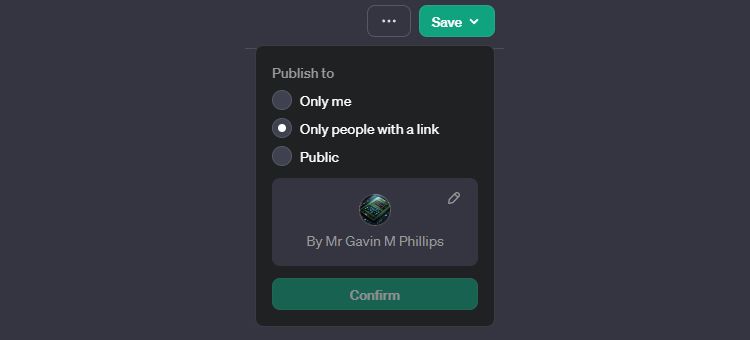

Po zakończeniu tworzenia spersonalizowanego modelu GPT należy rozważyć sposób jego rozpowszechniania. W prawym górnym rogu interfejsu do zapisywania niestandardowego GPT znajduje się przycisk “Zapisz”. Kliknięcie strzałki skierowanej w dół obok tego przycisku powoduje udostępnienie szeregu opcji wyboru preferowanej metody udostępniania nowo utworzonego modelu innym osobom.

Spersonalizowana wersja GPT jest dostępna wyłącznie dla użytkownika, ponieważ nie została publicznie udostępniona do użytku przez inne osoby.

Osoby, które posiadają adres URL spersonalizowanego modelu GPT, mogą z niego korzystać, co może również zapewnić im dostęp do wszelkich powiązanych danych.

Należy pamiętać, że po wykorzystaniu naszego spersonalizowanego GPT może on stać się publicznie dostępny i możliwy do przeszukiwania za pośrednictwem różnych platform internetowych, w tym między innymi Google. W konsekwencji naraża to informacje użytkownika na potencjalny nieautoryzowany dostęp przez każdą osobę, która uzyska dostęp do takich platform. Bardzo ważne jest, aby dokładnie rozważyć te konsekwencje przed przystąpieniem do korzystania z naszej usługi GPT.

Chociaż nie ma metody na zapewnienie pełnego bezpieczeństwa informacji przesłanych do publicznie dostępnego, dostosowanego modelu GPT, można podjąć środki ostrożności, dostarczając wyraźne dyrektywy zabraniające ujawniania takich danych w bazie wiedzy systemu. Środki te są jednak często niewystarczające, o czym świadczy nasz poprzedni przykład, w którym zdeterminowane osoby z doświadczeniem w inżynierii sztucznej inteligencji i dużą ilością czasu mogą ostatecznie uzyskać dostęp do informacji przechowywanych w bazie wiedzy modelu.

Rozsądnie byłoby nie przesyłać żadnych poufnych informacji za pośrednictwem spersonalizowanego GPT przeznaczonego do publicznej dystrybucji. Gdy tylko wrażliwy materiał zostanie przesłany do takiego modelu sztucznej inteligencji i przesłany z urządzenia, jest on poza naszym autorytetem lub kontrolą.

Należy zachować ostrożność podczas korzystania z podpowiedzi internetowych, ponieważ mogą one potencjalnie ukrywać szkodliwe linki.Upewnij się, że w pełni rozumiesz wszelkie monity przed ich użyciem, aby uniknąć potencjalnych zagrożeń, takich jak nieautoryzowane przesyłanie plików na zewnętrzne serwery za pośrednictwem zwodniczych lub zakodowanych linków.

Używaj niestandardowych GPT z ostrożnością

Niestandardowe GPT stanowią kuszącą, ale niepewną perspektywę. Zapewniają one użytkownikom elastyczność w tworzeniu dostosowanych modeli wykazujących wyjątkowe zdolności w określonych dziedzinach; jednak dane wykorzystane do nadania tych możliwości mogą stać się podatne na zagrożenia. Aby ograniczyć potencjalne zagrożenia, rozsądnie jest nie przesyłać wysoce poufnych informacji do niestandardowych GPT, jeśli jest to możliwe. Ponadto należy zachować czujność przed złośliwymi praktykami inżynierii podpowiedzi, które mogą wykorzystać ukryte luki w zabezpieczeniach w celu kradzieży dokumentów.