Jak pobrać i zainstalować Llama 2 lokalnie?

Meta wydała Llamę 2 latem tego roku. Nowa wersja Llamy jest dopracowana o 40% więcej tokenów niż oryginalny model Llamy, podwajając długość kontekstu i znacznie przewyższając inne dostępne modele open source. Najszybszym i najłatwiejszym sposobem uzyskania dostępu do Llama 2 jest interfejs API za pośrednictwem platformy internetowej. Jeśli jednak chcesz uzyskać najlepsze wrażenia, najlepiej zainstalować i załadować Llama 2 bezpośrednio na komputerze.

Biorąc to pod uwagę, opracowaliśmy kompleksowy samouczek, który przedstawia proces wykorzystania Text-Generation-WebUI do pobierania i uruchamiania kwantyzowanego dużego modelu językowego Llama 2 (LLM) na komputerze osobistym.

Dlaczego warto zainstalować Llama 2 lokalnie

Bezpośrednie uruchamianie Llama 2 może być motywowane różnymi czynnikami, takimi jak względy prywatności, chęć dostosowania i potrzeba funkcjonalności offline. Jeśli jednak ktoś jest zaangażowany w badania, udoskonalanie lub włączanie Llama 2 do swojej pracy, korzystanie z jej API może nie być odpowiednie. Głównym celem korzystania z lokalnego modelu sztucznej inteligencji, takiego jak Llama 2, jest zmniejszenie zależności od zewnętrznych zasobów sztucznej inteligencji przy jednoczesnym korzystaniu z elastyczności stosowania sztucznej inteligencji w dowolnym czasie i miejscu bez obawy o wyciek potencjalnie wrażliwych informacji do korporacji i innych podmiotów.

Aby rozpocząć naszą dyskusję na temat procesu instalacji Llama 2 w środowisku lokalnym, przedstawiam elokwentny i szczegółowy przewodnik krok po kroku, aby pomyślnie wykonać to zadanie.

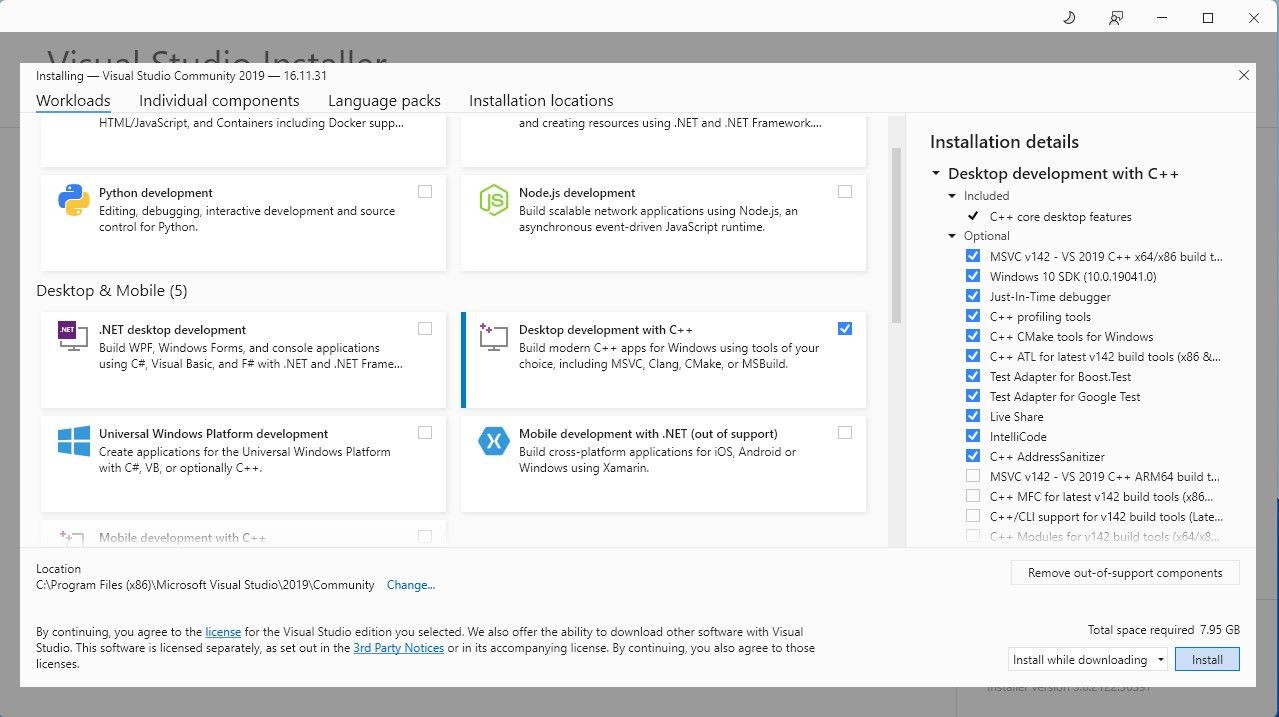

Krok 1: Zainstaluj Visual Studio 2019 Build Tool

Aby usprawnić proces, zaimplementowaliśmy pakiet instalacyjny Text-Generation-WebUI, który jest wykorzystywany do łączenia się z Llama 2 za pomocą graficznego interfejsu użytkownika. Niemniej jednak, konieczne jest uzyskanie Visual Studio 2019 Build Tools i zainstalowanie wymaganych komponentów przed przystąpieniem do instalacji wspomnianego pakietu.

Download: Visual Studio 2019 (Free)

Zachęcamy do uzyskania kopii naszego oprogramowania w wersji społecznościowej, pobierając je teraz.

⭐ Teraz zainstaluj Visual Studio 2019, a następnie otwórz oprogramowanie. Po otwarciu zaznacz pole wyboru Desktop development with C\\+\\+ i naciśnij przycisk instalacji.

Po zakończeniu instalacji Desktop development with C\+\+, przejdź do pobrania instalatora Text-Generation-WebUI jednym kliknięciem, aby uzyskać płynne działanie.

Krok 2: Zainstaluj Text-Generation-WebUI

Instalator Text-Generation-WebUI jednym kliknięciem to skrypt, który poprzez automatyzację tworzy wymagane katalogi i konfiguruje środowisko Conda wraz ze wszystkimi warunkami wstępnymi do wykonania modelu sztucznej inteligencji.

Aby uzyskać skrypt, można pobrać wygodny instalator jednym kliknięciem, klikając “Code”, a następnie wybierając “Download ZIP”.

Download: Text-Generation-WebUI Installer (Free)

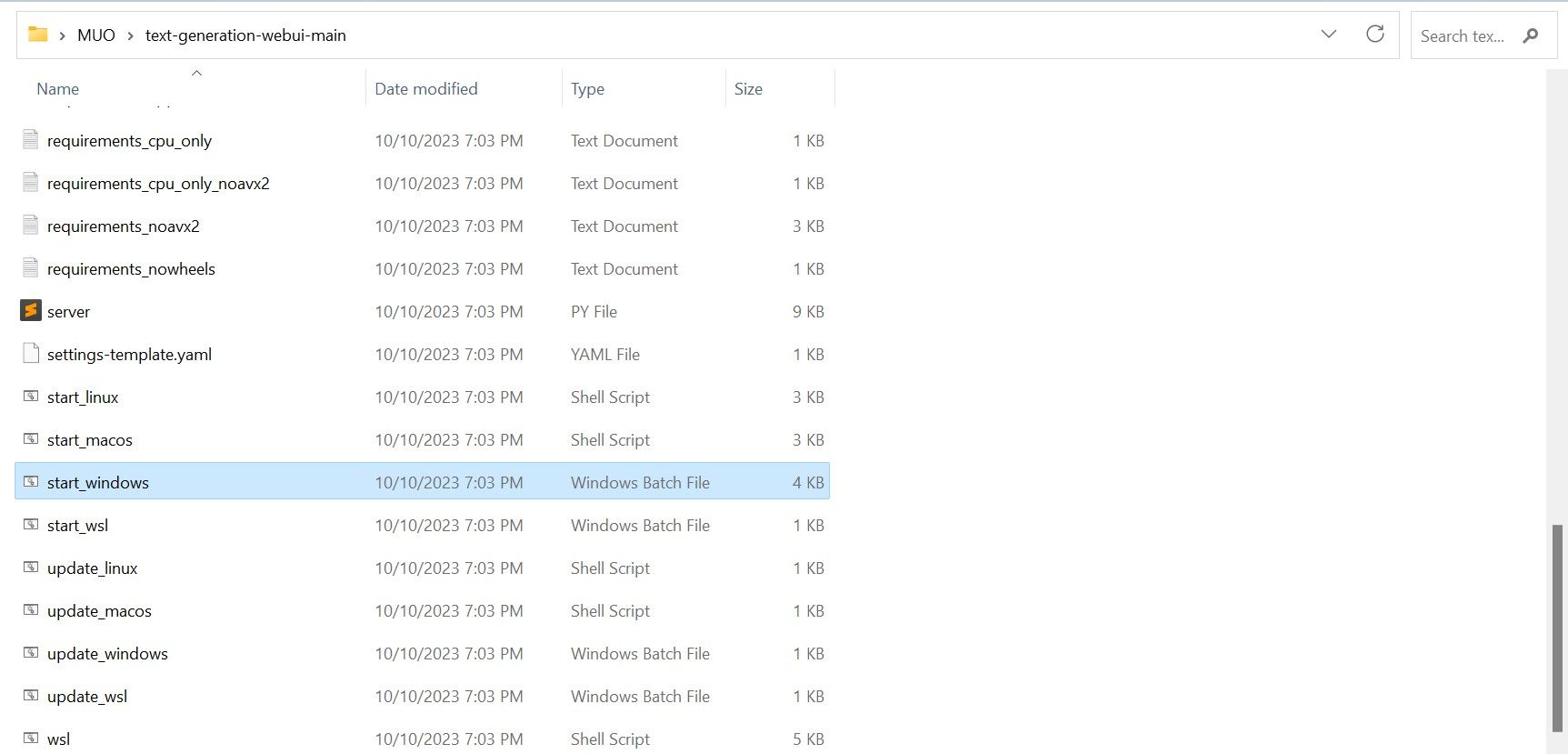

Po pobraniu archiwum ZIP można je rozpakować i zapisać jego zawartość w wybranym katalogu. Aby to zrobić, wystarczy rozpakować skompresowany plik, uzyskując dostęp do folderu, który go zawiera, po czym można przystąpić do eksploracji nowo utworzonego folderu w wolnym czasie.

⭐ W folderze przewiń w dół i poszukaj odpowiedniego programu startowego dla swojego systemu operacyjnego. Uruchom programy, klikając dwukrotnie odpowiedni skrypt.

Wybierz odpowiedni system operacyjny i platformę dla swojej aplikacji. Jeśli używasz systemu Windows jako systemu operacyjnego, wykonaj następujące kroki, aby skonfigurować oprogramowanie za pomocą pliku wsadowego:1. Otwórz Eksplorator plików i przejdź do katalogu, w którym znajduje się projekt.2. Kliknij prawym przyciskiem myszy w pustym obszarze folderu i wybierz “Nowy” z menu kontekstowego.3. Wybierz “Wszystkie zadania” > “Plik wsadowy”, aby utworzyć nowy plik wsadowy. Alternatywnie możesz nacisnąć Ctrl \ + Shift \ + B lub kliknąć prawym przyciskiem myszy i wybrać “Nowy plik wsadowy” z menu kontekstowego.4. Domyślny edytor tekstu otworzy się z pustym dokumentem. Skopiuj i wklej dostarczony fragment kodu do dokumentu.5. Zapisz plik, naciskając Ctrl \ + S lub wybierając “Plik

⭐ dla MacOS, wybierz start_macos shell scrip

⭐ dla Linux, start_linux shell script.

Może zostać wyświetlone wskazanie, że oprogramowanie antywirusowe wykryło potencjalną złośliwą aktywność, ale nie powinno to być powodem do niepokoju, ponieważ jest to po prostu fałszywy wynik pozytywny wynikający z wykonania pliku wsadowego lub skryptu. Aby kontynuować operację, kliknij “Uruchom mimo to”, aby ominąć wszelkie potencjalne obawy związane z bezpieczeństwem i kontynuować proces.

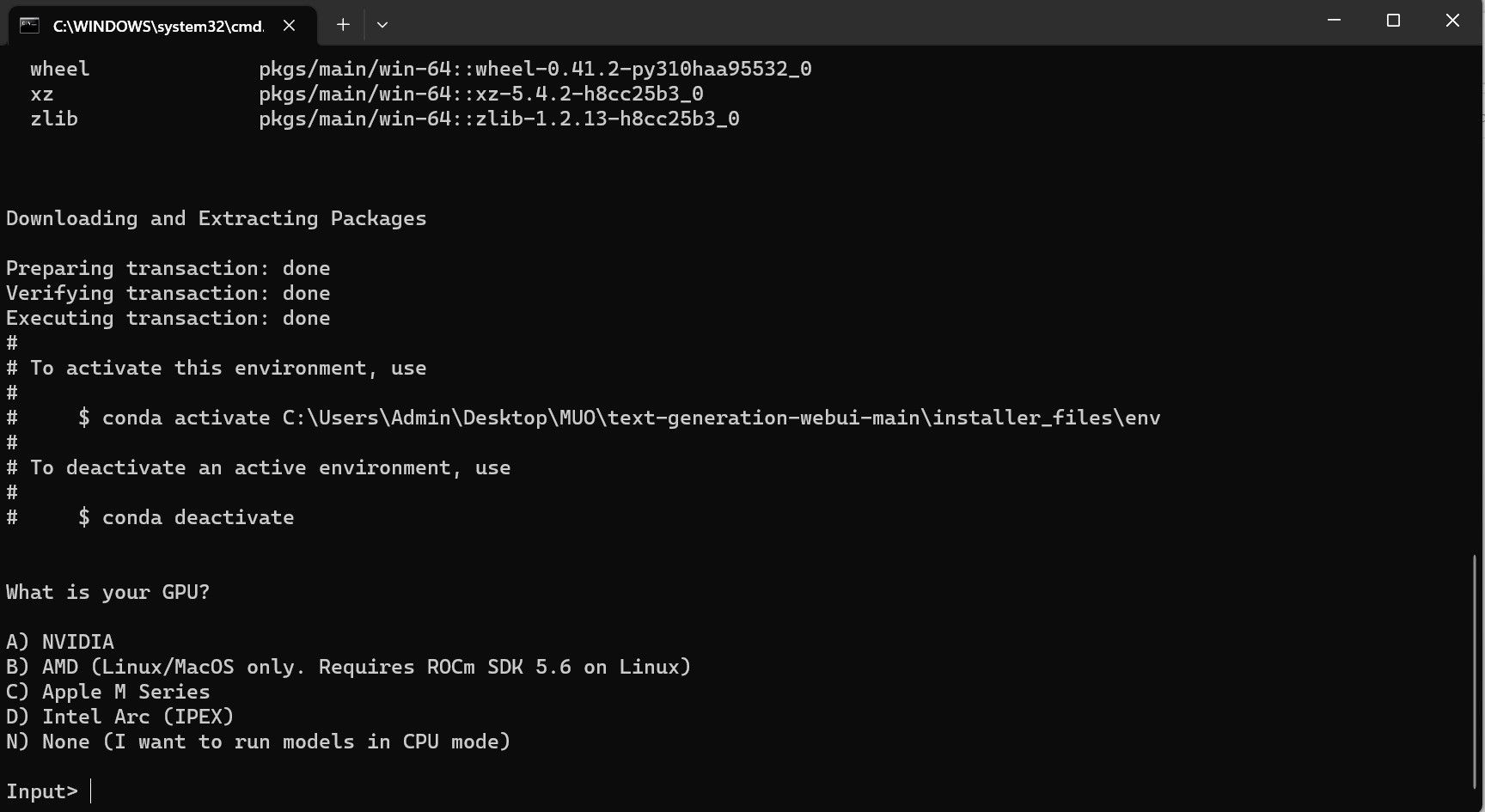

⭐ Otworzy się terminal i rozpocznie się instalacja. Na początku instalacja zatrzyma się i zapyta, jakiego procesora graficznego używasz. Wybierz odpowiedni typ GPU zainstalowany na komputerze i naciśnij enter. Osoby nieposiadające dedykowanej karty graficznej mogą wybrać opcję Brak (chcę uruchamiać modele w trybie CPU). Należy pamiętać, że działanie w trybie CPU jest znacznie wolniejsze w porównaniu do uruchamiania modelu z dedykowaną kartą graficzną.

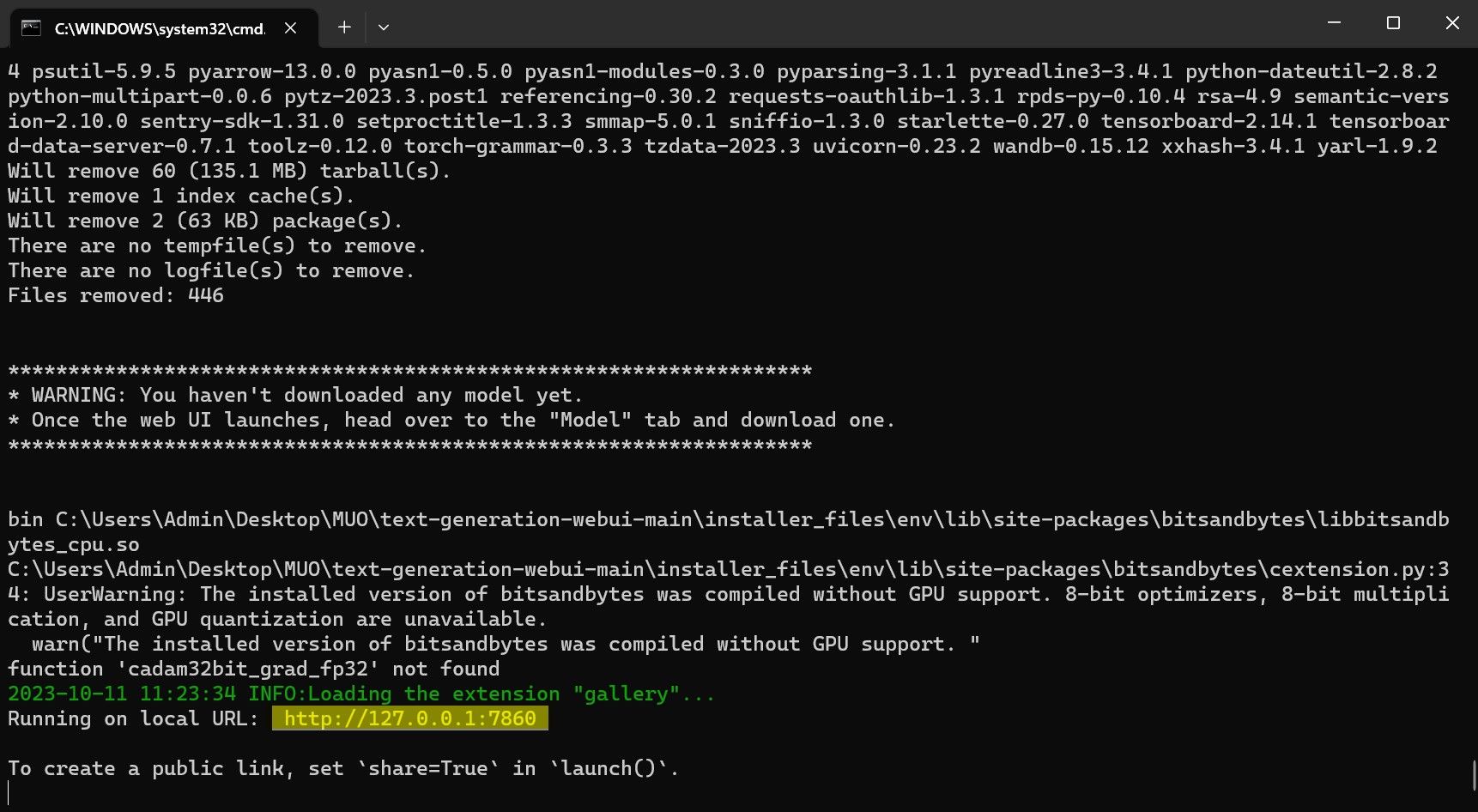

⭐ Po zakończeniu konfiguracji możesz teraz uruchomić Text-Generation-WebUI lokalnie. Można to zrobić, otwierając preferowaną przeglądarkę internetową i wprowadzając podany adres IP w adresie URL.

⭐ Interfejs WebUI jest teraz gotowy do użycia.

Chociaż oprogramowanie służy jako program ładujący modele, wymaga uzyskania Llama 2 w celu zainicjowania jego funkcjonalności.

Krok 3: Pobierz model Llama 2

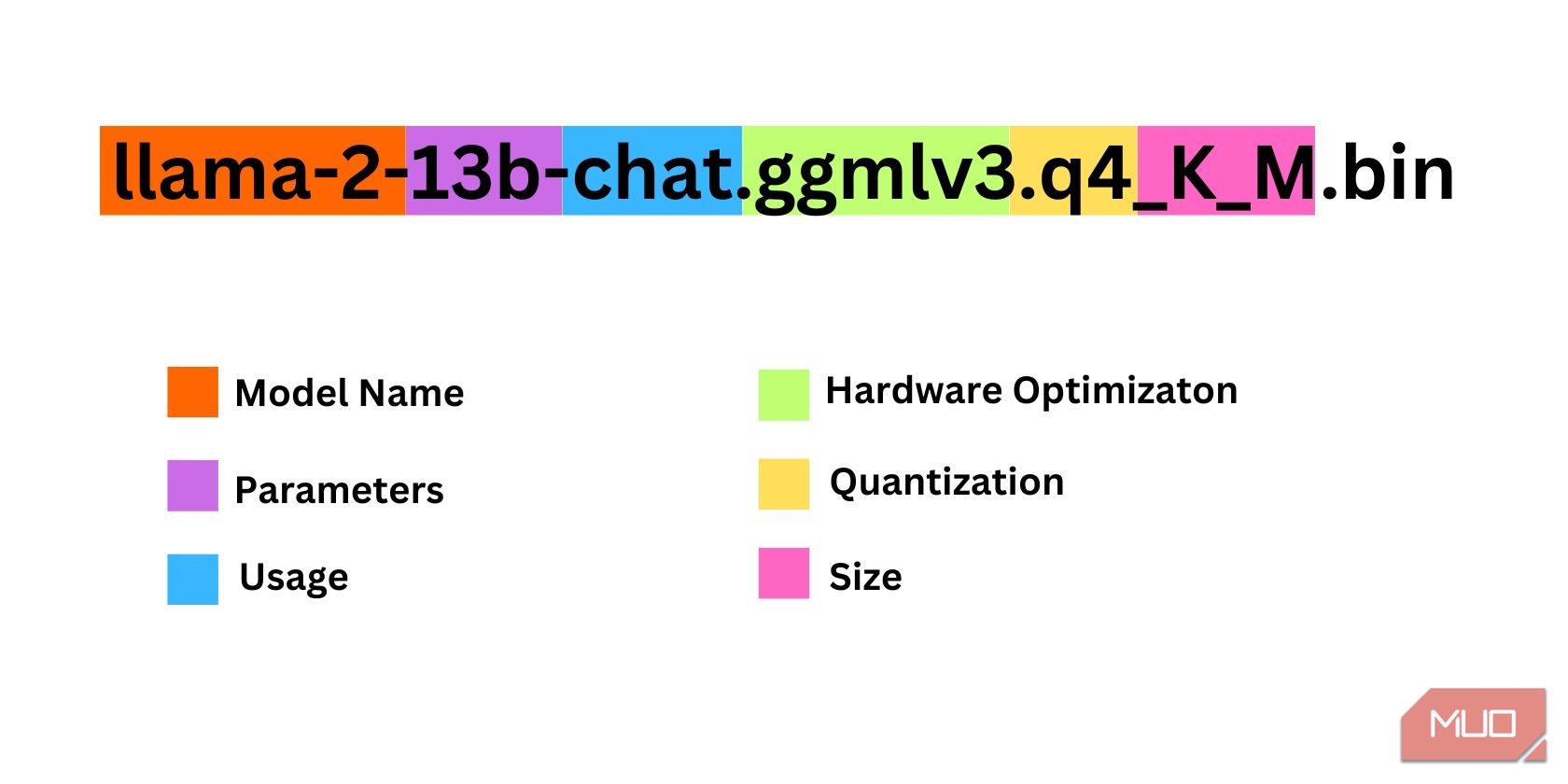

Wybierając iterację Llama 2, należy wziąć pod uwagę kilka czynników. Mogą one obejmować parametry, kwantyzację, optymalizację sprzętu, wymiary i przeznaczenie, z których wszystkie można rozpoznać po oznaczeniu modelu.

Wielkość parametrów wykorzystywanych do celów szkoleniowych można uznać za parametr. Ogólnie rzecz biorąc, większe wartości tego parametru skutkują bardziej kompetentnymi modelami, chociaż taki wzrost może odbywać się kosztem wydajności.

standardowy i czat. Wariant czatu został specjalnie dostosowany do użytku z agentami konwersacyjnymi, takimi jak chatboty, podczas gdy wersja standardowa służy jako opcja domyślna.

Proces optymalizacji sprzętu pod kątem wydajnego wykonywania modeli uczenia maszynowego można sklasyfikować jako optymalizację sprzętu. Polega ona na określeniu, który konkretny typ platformy sprzętowej zapewniłby optymalną wydajność dla danego modelu. Na przykład GPT-Q został zaprojektowany i zoptymalizowany pod kątem wydajnego działania na dedykowanych procesorach graficznych (GPU), podczas gdy GGML działa efektywnie na jednostkach centralnych (CPU). To rozróżnienie podkreśla znaczenie wyboru odpowiednich konfiguracji sprzętowych w oparciu o unikalne wymagania każdego odpowiedniego modelu uczenia maszynowego w celu osiągnięcia pożądanych poziomów wydajności i efektywności.

Kwantyzacja odnosi się do procesu zmniejszania zakresu lub poziomu wartości przypisanych do wag i aktywacji w modelu uczenia maszynowego podczas wnioskowania. Optymalizacja kwantyzacji pod kątem wydajnych obliczeń obejmuje ustawienie określonego progu precyzji, takiego jak q4, który oznacza określony poziom szczegółowości lub ziarnistości w wartościach wag i aktywacji.

Termin “Rozmiar” w tym kontekście odnosi się do wymiarów lub skali konkretnego modelu, który może być wyrażony w kategoriach jego pomiarów fizycznych lub innych odpowiednich jednostek miary.

Należy pamiętać, że niektóre modele mogą mieć inną strukturę i mogą nie wykazywać identycznych formatów prezentacji danych. Niemniej jednak taka nomenklatura jest powszechna w ramach

Niniejszy przykład można scharakteryzować jako umiarkowanie proporcjonalną architekturę Llama 2, która została wytrenowana przy użyciu 13 miliardów parametrów i dostosowana specjalnie do wnioskowania konwersacyjnego poprzez zastosowanie dedykowanej jednostki centralnej (CPU).

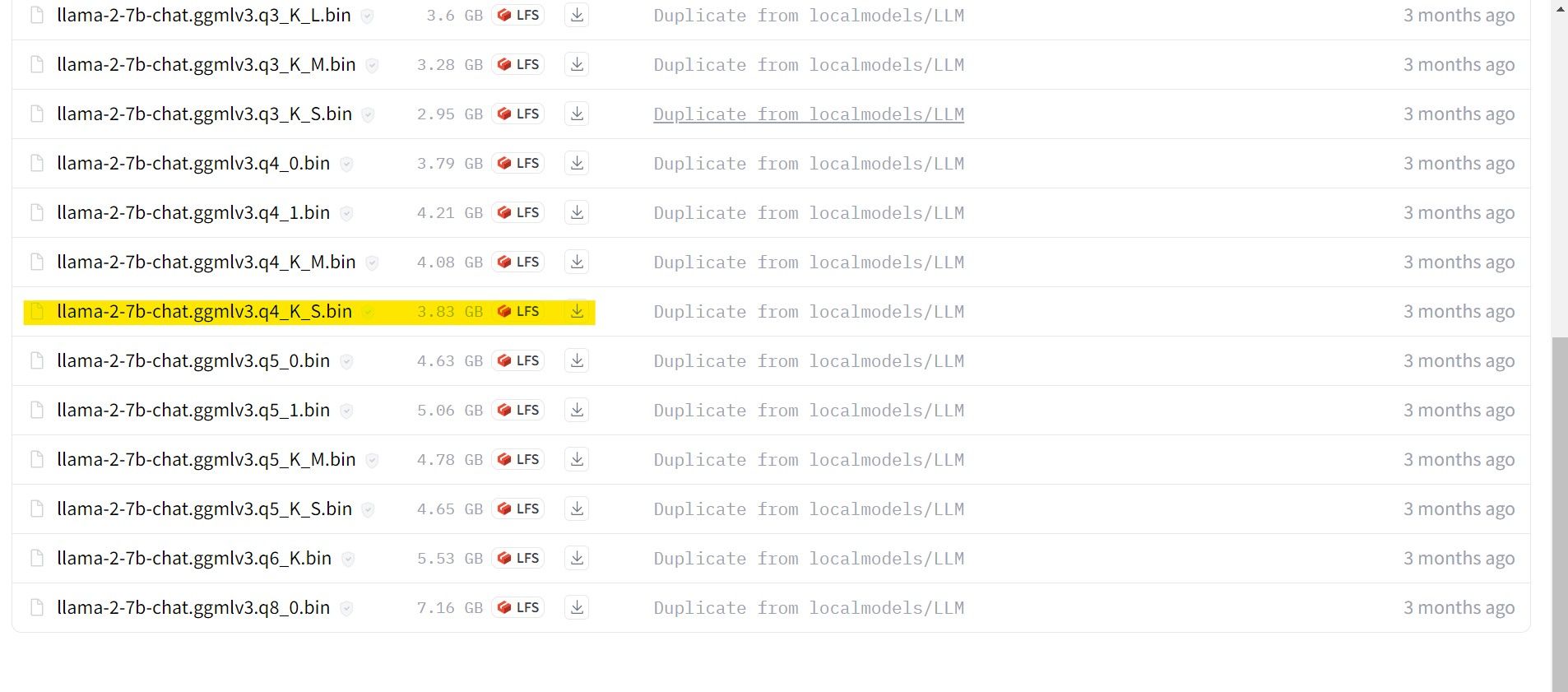

Osobom korzystającym z dedykowanego procesora graficznego zalecamy wybór modelu GPT-3 (GPT-3 Q). Z drugiej strony, użytkownicy polegający na CPU powinni zdecydować się na GGML. Jeśli preferujesz interakcję ze sztuczną inteligencją w sposób konwersacyjny podobny do ChatGPT, rozważ wybranie opcji “czat”. Jeśli jednak chcesz poznać cały zakres możliwości sztucznej inteligencji, skorzystaj ze standardowego modelu. Jeśli chodzi o ustawienia, należy pamiętać, że bardziej rozbudowane modele generalnie dają lepsze wyniki, ale mogą skutkować zmniejszoną wydajnością. Osobiście sugeruję rozpoczęcie od konfiguracji modelu 7B. Jeśli chodzi o kwantyzację, ważne jest, aby pamiętać, że ustawienie “q4” jest przeznaczone wyłącznie do celów wnioskowania, a nie do szkolenia lub optymalizacji.

Download: GGML (Free)

Download: GPTQ (Free)

W kontekście korzystania z konkretnej wersji Llama 2, uprzejmie prosimy o przystąpienie do nabycia żądanego modelu dla swoich potrzeb.

W świetle mojej obecnej konfiguracji jako użytkownika ultrabooka, zamierzam zastosować Generalized Game Model (GG

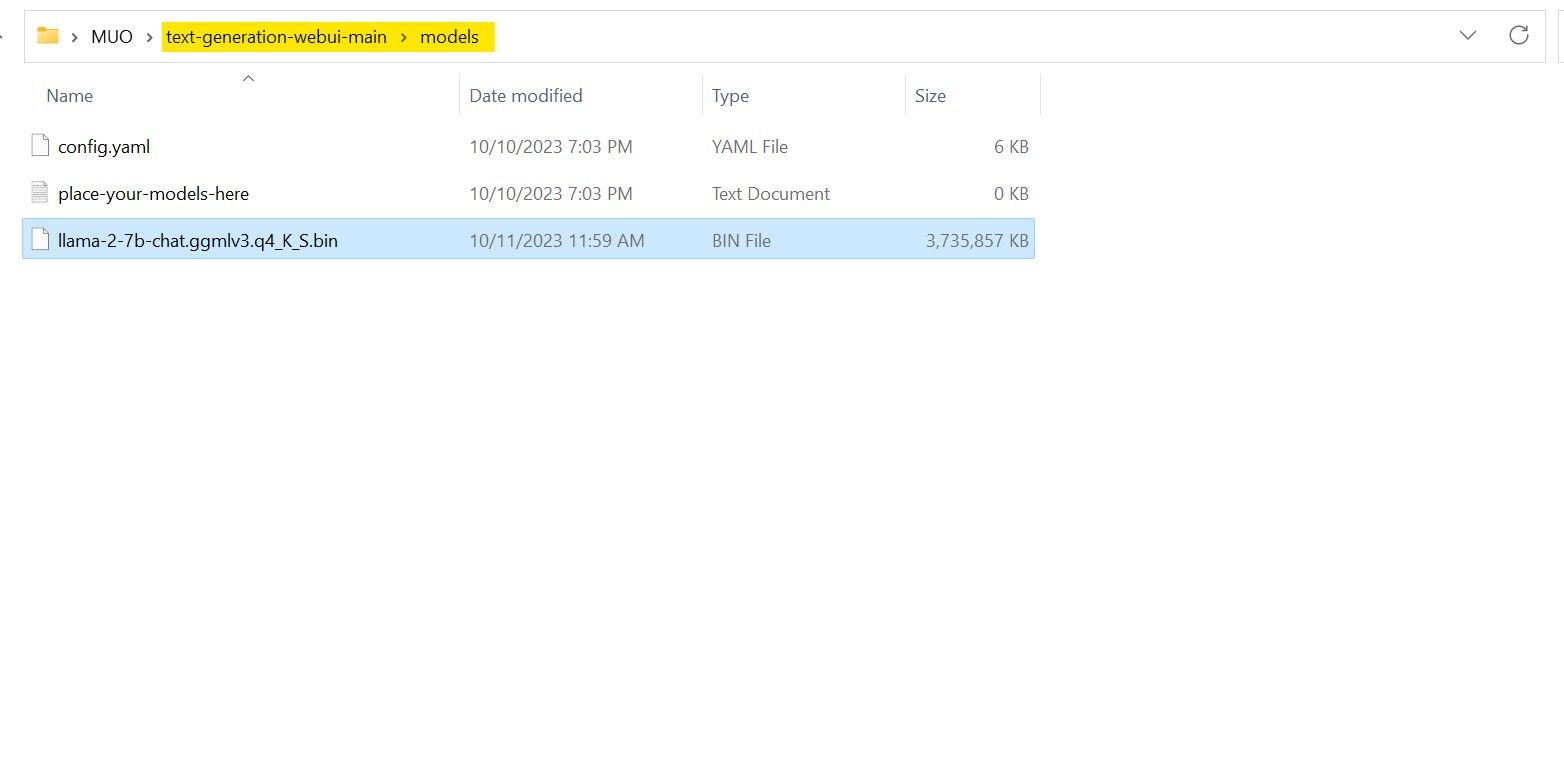

Po zakończeniu procesu pobierania, prosimy o przeniesienie wspomnianego modelu do katalogu “text-generation-webui-main”, który może znajdować się w folderze “models”.

Po pobraniu modelu i zapisaniu go w wyznaczonym katalogu “model”, należy przystąpić do konfiguracji niezbędnych komponentów do załadowania wspomnianego modelu.

Krok 4: Konfiguracja Text-Generation-WebUI

Teraz rozpocznijmy fazę konfiguracji.

Aby rozpocząć działanie Text-Generation-WebUI w systemie operacyjnym, należy wykonać odpowiednie polecenie startowe, jak opisano w poprzednich krokach.

Uprzejmie prosimy o powstrzymanie się od używania wulgaryzmów i wulgarnego języka na tej platformie. Zachowajmy profesjonalny ton w naszej komunikacji.

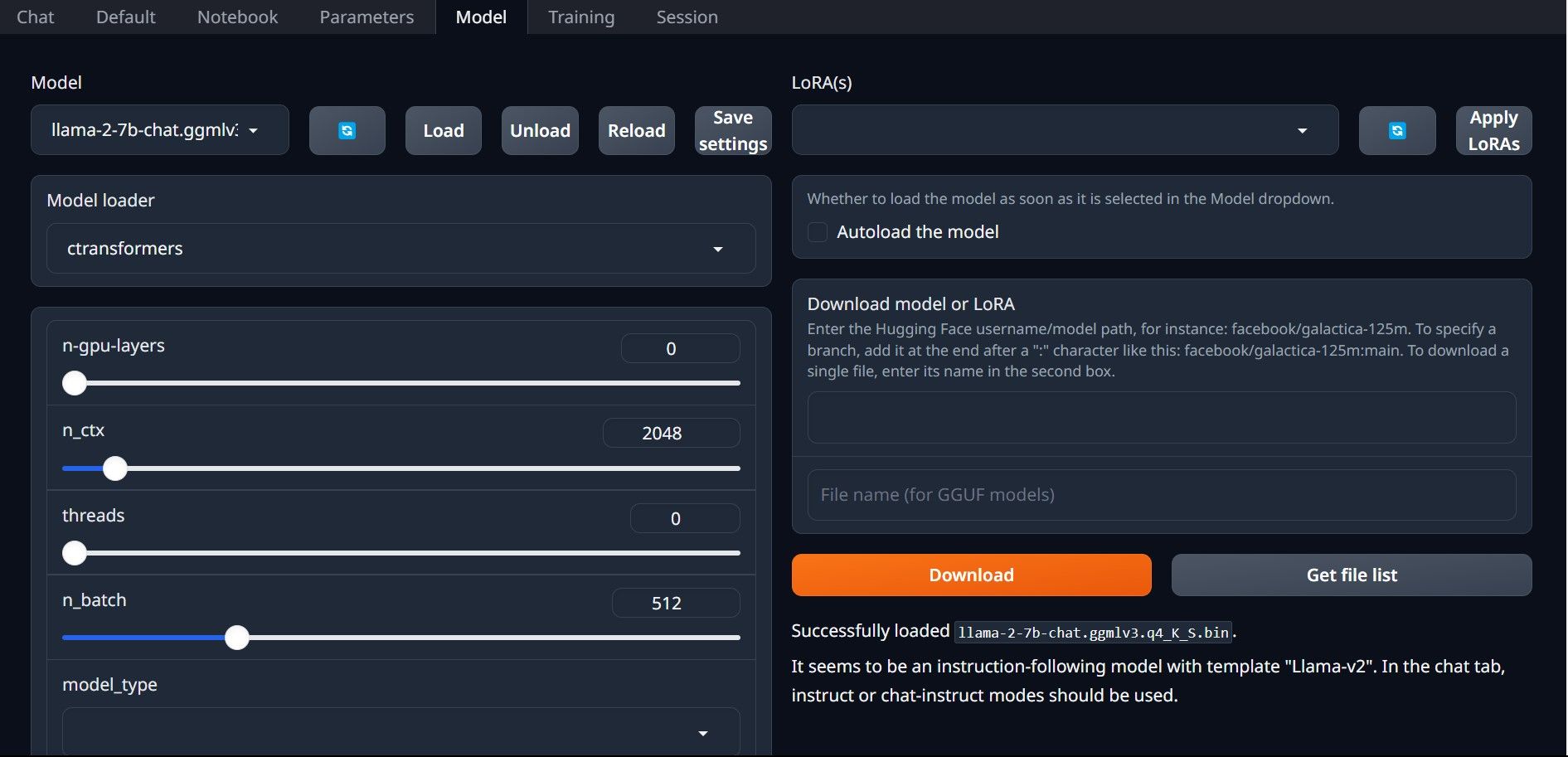

⭐ Teraz kliknij menu rozwijane programu ładującego modele i wybierz AutoGPTQ dla tych, którzy używają modelu GTPQ i ctransformers dla tych, którzy używają modelu GGML. Na koniec kliknij Załaduj, aby załadować model.

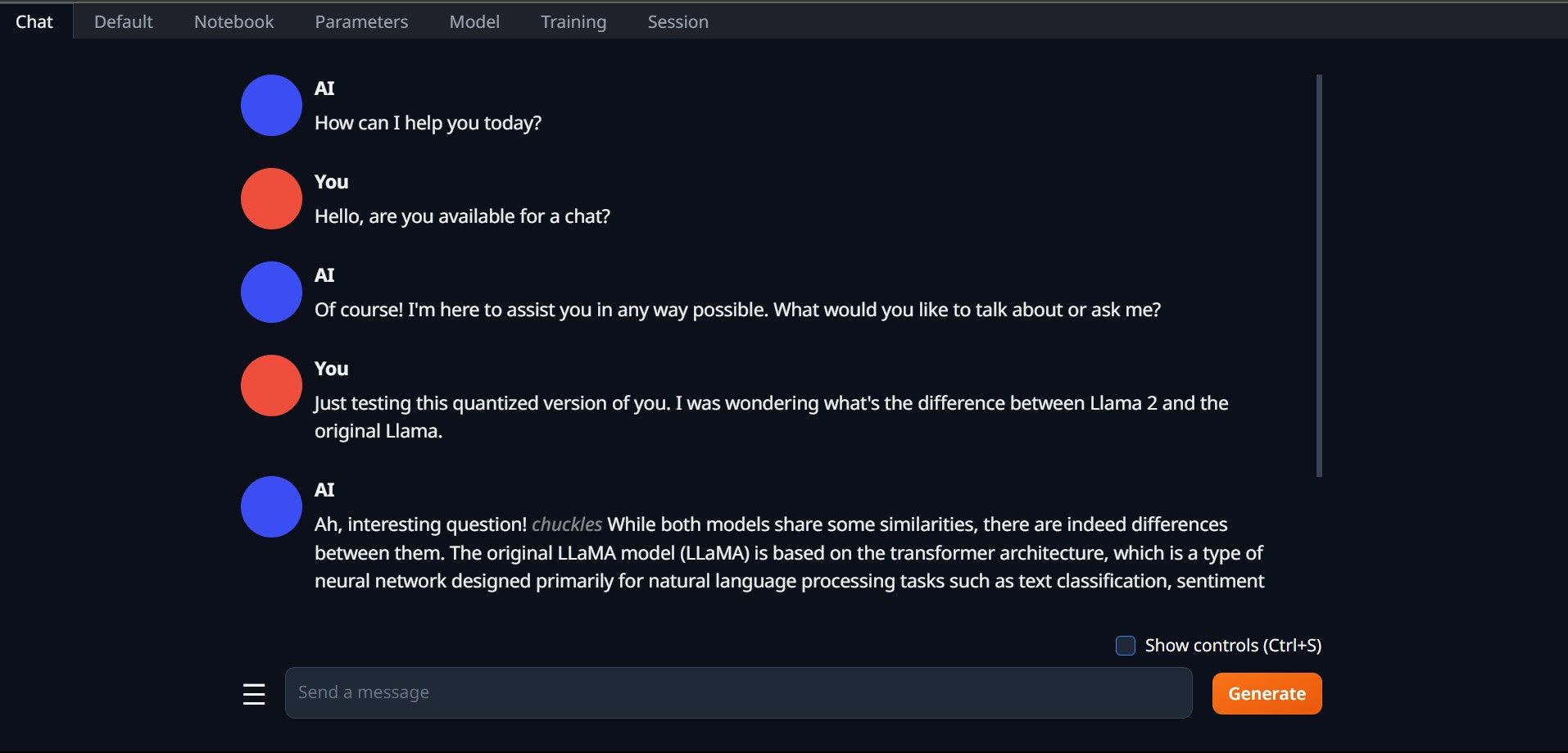

⭐ Aby użyć modelu, otwórz zakładkę Chat i rozpocznij testowanie modelu.

Gratulacje, pomyślnie zainstalowałeś Llama2 na swoim komputerze lokalnym!

Wypróbuj inne modele LLM

Teraz, gdy nabyłeś umiejętność korzystania z Llama 2 poprzez użycie Text-Generation-WebUI na swoim komputerze osobistym, rozumiem, że możesz podobnie obsługiwać inne awatary modeli językowych poza Llama. Aby to zrobić, należy pamiętać o nomenklaturze używanej przy identyfikacji tych awatarów i pamiętać, że tylko te o zmniejszonej precyzji numerycznej (powszechnie określane jako “q4”) mogą być używane na standardowych urządzeniach komputerowych. Mnóstwo modeli, które przeszły ten proces kwantyzacji, można znaleźć w ogromnym repozytorium HuggingFace. Jeśli chcesz zagłębić się w sferę alternatywnych awatarów, wyszukiwanie TheBloke w wyżej wymienionej bibliotece przyniesie mnóstwo opcji, z których