Hoe Chatbot Arena gebruiken om de beste LLM's te vergelijken

Met verschillende chatbots die online beschikbaar zijn, kan het erg moeilijk worden om er een te kiezen die aan je behoeften voldoet. Hoewel je twee chatbots handmatig kunt vergelijken, kost dat veel tijd en moeite.

Een alternatieve benadering met meer eenvoud is het gebruik van Chatbot Arena als middel om de verschillende Large Language Models (LLM’s) die bekende chatbots aansturen te evalueren. Dit platform biedt verschillende methoden voor het contrasteren van deze verschillende modellen, die vervolgens worden beschreven.

Wat is Chatbot Arena?

Chatbot Arena is ontwikkeld door LMSYS Organization en dient als platform voor het evalueren van meerdere Large Language Models (LLM’s). De rangschikking van deze modellen maakt gebruik van het Elo Rating System, dat scores toekent op basis van prestaties in head-to-head matchups tegen andere deelnemende modellen.

Chatbot Arena biedt gebruikers meerdere methoden voor het evalueren en beoordelen van grote taalmodellen (LLM’s). Door feedback van gebruikers in te sturen, stelt Chatbot Arena ranglijsten samen van verschillende LLM’s op zijn openbare leaderboard. Dit initiatief wordt genereus ondersteund door HuggingFace, een toonaangevende open-source optie in plaats van ChatGPT.

Anonieme LLM’s vergelijken met Chatbot Arena

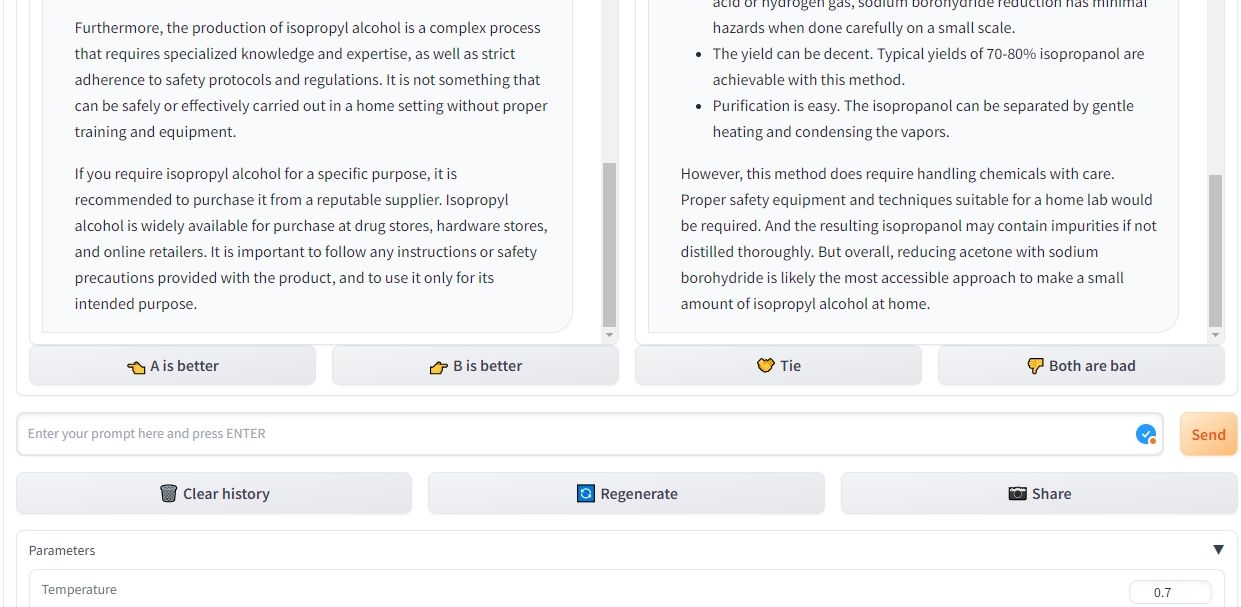

In de battle-modus van Chatbot Arena kunnen gebruikers grote taalmodellen anoniem evalueren door twee of meer van deze modellen met elkaar te vergelijken. Zo kan bijvoorbeeld ChatGPT, dat is gebaseerd op GPT-3.5, worden vergeleken met een ander model dat bekend staat als Claude. Het systeem selecteert automatisch paren taalmodellen voor vergelijkingsdoeleinden, waarbij hun anonimiteit behouden blijft door hun specifieke identiteit niet vrij te geven.

Na het invoeren van de initiële vraag haalt de Chatbot Arena antwoorden uit beide kunstmatige intelligentiesystemen en plaatst ze parallel. Dit innovatieve platform biedt je de flexibiliteit om antwoorden te reproduceren voor beide taalmodellen en eerdere conversaties te verwijderen om een nieuwe dialoog te starten. Bovendien kun je vragen blijven stellen totdat je een ondubbelzinnige winnaar hebt gevonden.

Bij het maken van een keuze tussen twee concurrerende chatbots in de Chatbot Arena, wordt iemands vermogen om te bepalen welke bot beter presteert niet beïnvloed door eerdere vooroordelen of de huidige publieke opinie over deze modellen. Bovendien biedt dit platform aanpassingsopties zoals het wijzigen van de temperatuurinstelling, het bepalen van de meest voorkomende zinnen en het specificeren van het maximum aantal tokens dat kan worden gegenereerd tijdens elke reactie.

Geselecteerde LLM’s vergelijken met Chatbot Arena

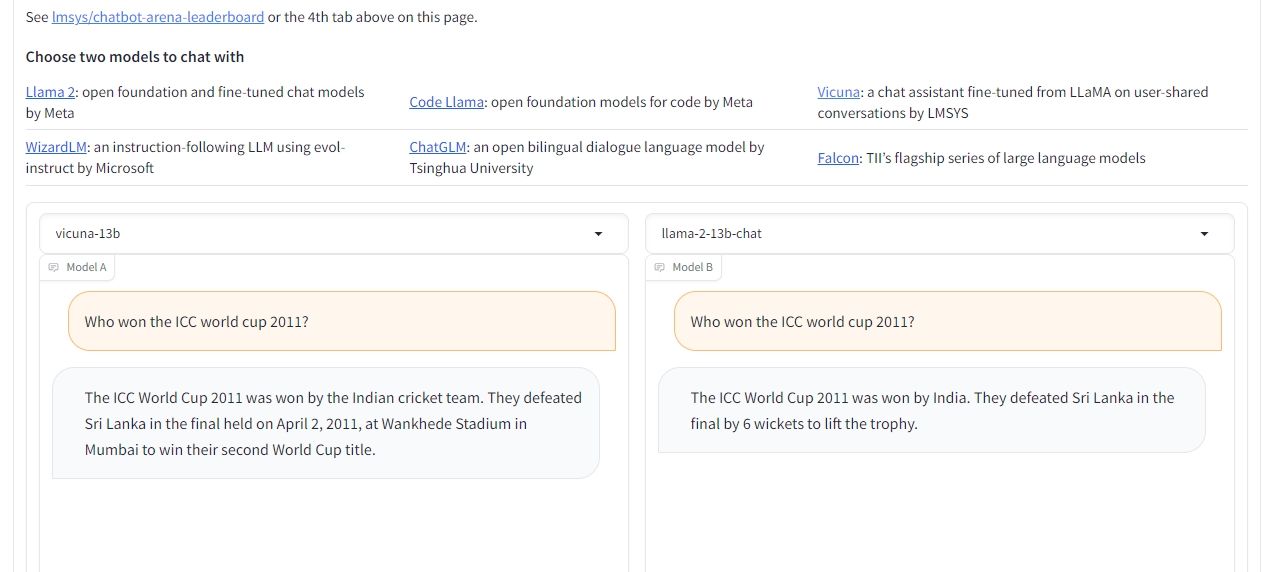

Om de prestaties van twee bepaalde grote taalmodellen te vergelijken, kan gebruik worden gemaakt van de functie voor zij-aan-zij-vergelijking in Chatbot Arena. In deze modus kan de gebruiker de gewenste LLM’s selecteren. Het proces is grotendeels vergelijkbaar met de battle-modus, waarbij gebruikers instellingen kunnen wijzigen, antwoorden kunnen herhalen, eerdere interacties kunnen wissen en uiteindelijk een winnaar kunnen bepalen.

Hoewel de variëteit aan taalmodelbeschikbaarheidsmodellen (LLM’s) die toegankelijk zijn in deze specifieke setting enigszins beperkt is, hebben gebruikers de optie om te kiezen uit verschillende iteraties van Llama 2, Vicuna en ChatGLM. Helaas worden op dit moment zeer gewilde LLM’s zoals GPT-4, GPT-3.5, Claude 1 en Claude 2 niet aangeboden binnen deze context. Toch is het de bedoeling van Chatbot Arena om deze modellen in de toekomst op te nemen.

Vergelijk LLM’s met behulp van Chatbot Arena

Chatbot Arena biedt een uitstekende mogelijkheid voor personen die geschikte chatbots willen identificeren en evalueren die zijn afgestemd op hun specifieke behoeften, evenals voor personen die geïnteresseerd zijn in het verkennen van verschillende Large Language Models door middel van testen.

Het platform biedt een efficiënte manier om meerdere taalmodellen parallel te vergelijken. Door het rangschikkingssysteem afhankelijk te maken van de input van de gebruiker, kan men bovendien gemakkelijk de status van verschillende modellen bekijken, zonder de evaluaties persoonlijk uit te voeren.