如何通過這 6 種提示技巧減少 AI 幻覺

要點

為了減少人工智能生成的內容偏離預期結果的情況,必須提供明確定義的指令,以準確理解預期內容。模糊的指導可能會導致不良後果,而提供詳細的規範可以提高生成輸出的可預測性。

當使用基礎或“根據……”方法時,將任何生成的輸出歸因於特定的來源或觀點非常重要。通過這樣做,人們可以防止人工智能生成的材料中出現事實差異和偏見。

為了引導人工智能實現特定結果,建立系統必須運行的明確參數或限制非常重要。這些約束可以根據給定的上下文或手頭的任務來明確地陳述或暗示,以避免由於指令的誤解而可能產生的任何不需要的或不合邏輯的結果。通過仔細考慮這些因素,我們可以有效地控制人工智能生成的響應的方向,並確保它們與我們預期目標的相關性和一致性。

當個體遇到生成人工智能係統產生的不期望的和不真實的反應時,可能會出現人工智能幻覺現象。此問題可能表現為人工智能模型產生的誤導性或不相關的信息,偏離了預期的輸出。

人工智能生成的響應的可靠性可能會受到多個變量的影響,包括用於培訓目的的信息質量、上下文信息不足以及可能導致混亂的不精確提示。然而,存在一些方法可以使用戶在與人工智能係統交互時獲得更可靠的結果。

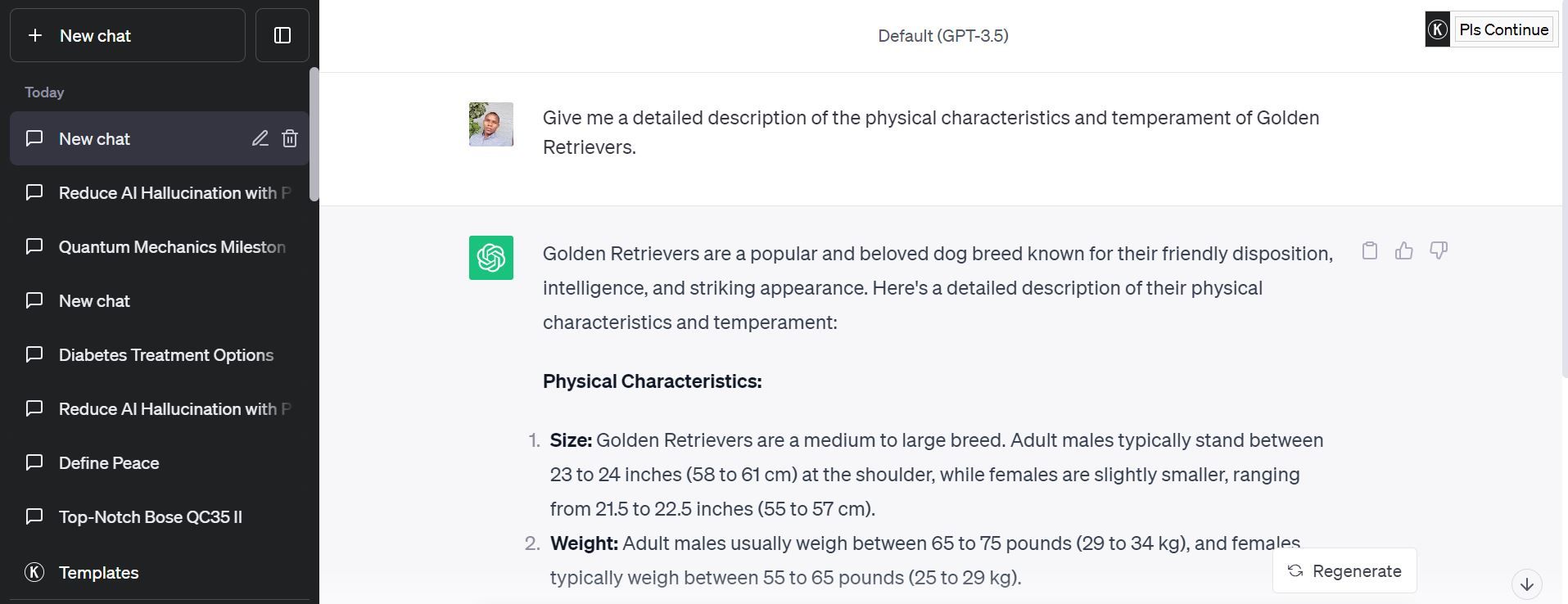

提供清晰具體的提示

減輕人工智能係統產生不需要或誤導性輸出的可能性的一種方法是在提供輸入時制定精確而詳細的指南。由於這些技術固有的複雜性,模糊或不精確的請求可能會導致不良後果,因此清楚地概述期望以實現更準確和令人滿意的結果非常重要。

重新設計查詢以請求有關金毛獵犬品種的屬性和處置的特定信息,可以幫助減少人工智能響應中的誤解情況。通過縮小查詢範圍,系統不太可能生成偏離預期主題的富有想像力或不相關的內容。

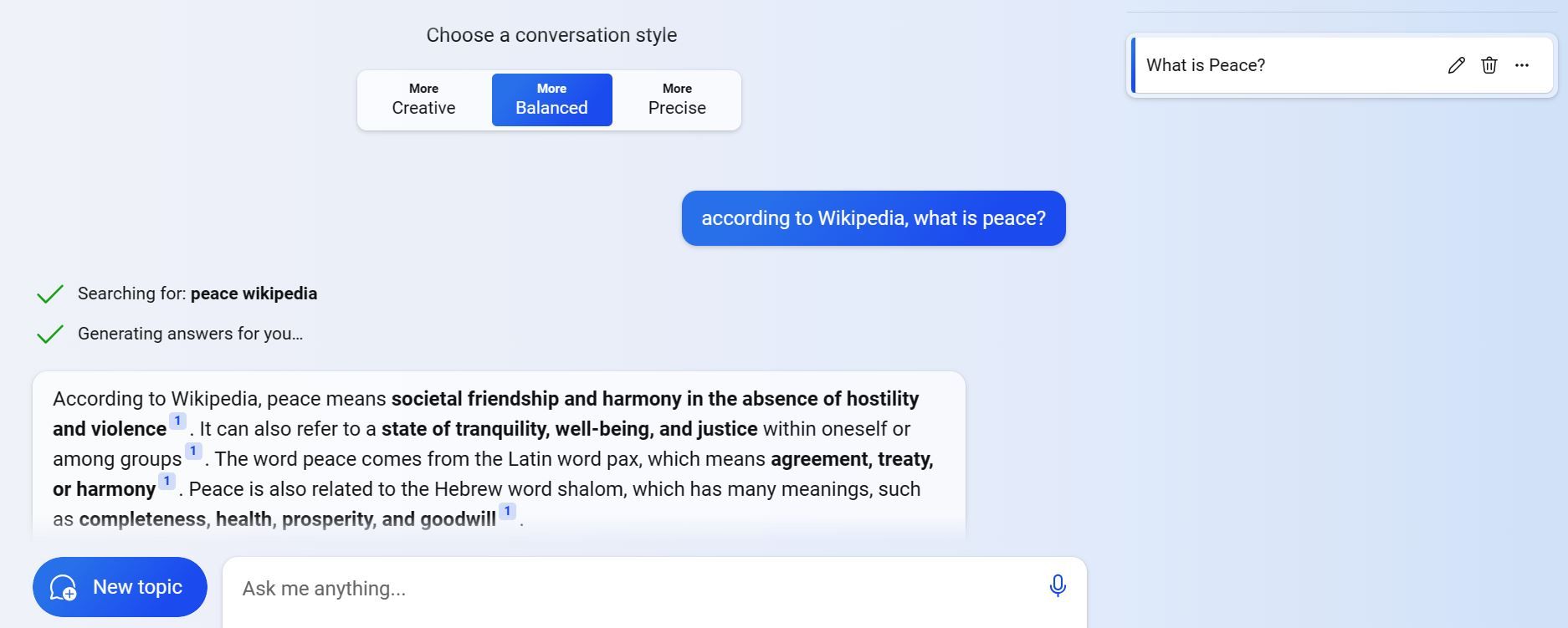

使用接地或“根據……”技術

使用人工智能係統通常會遇到困難,因為它們可能會產生錯誤的、有偏見的或與個人信仰或原則不一致的結果。此類差異可能是由於這些人工智能係統在包含缺陷、個人觀點或差異的廣泛且多樣化的數據集上進行訓練而產生的。

為了防止這種情況發生,人們可以採用接地技術或“根據”方法,其中人工智能生成的內容歸因於特定的起源或觀點。舉例來說,個人可能會要求人工智能係統根據維基百科、谷歌學術或任何其他廣泛可用的資源等來源提供的信息,生成有關某個主題的可驗證的聲明。

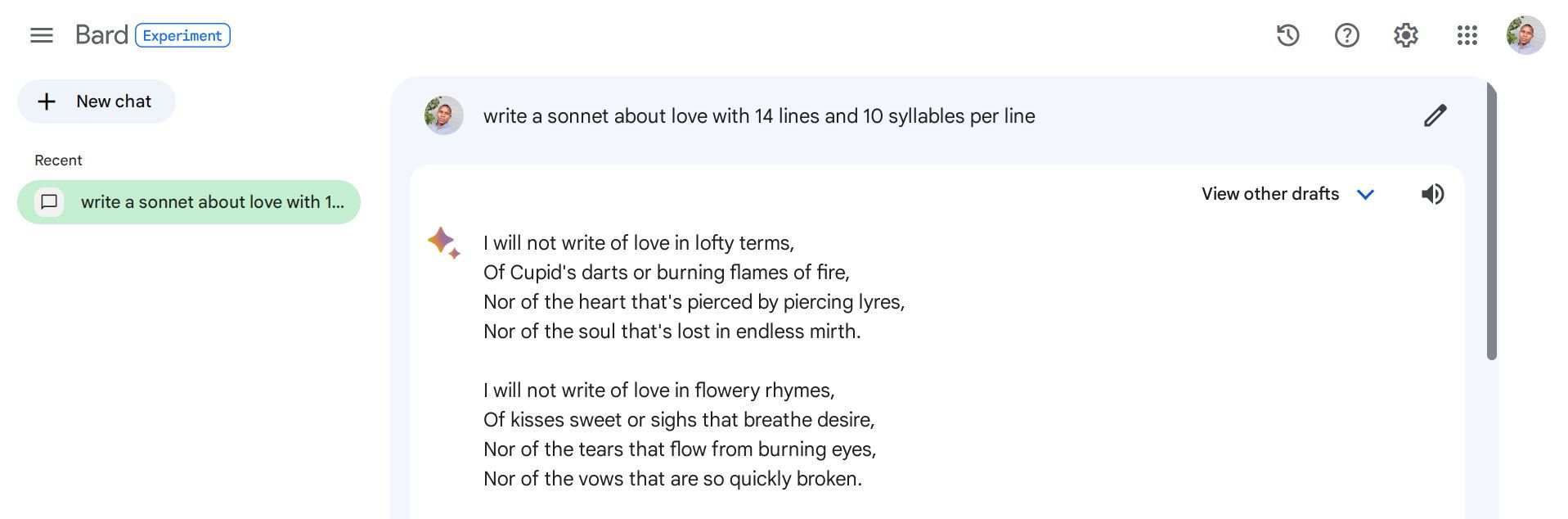

使用約束和規則

在人工智能係統中納入約束和指導方針可以避免產生不相關、衝突或無意義的結果。此外,這些參數根據特定目標和意圖指導和微調結果。這些先決條件可以在指令中明確表達,也可以通過周圍環境或分配的任務巧妙地推斷出來。

當嘗試利用人工智能來創作有關情感的詩歌時,人們可能會選擇為軟件提供更具體和結構化的命令,而不是諸如“創作一首關於愛情的詩句”之類的籠統請求。一個例子可以是指示程序製作一首十四行詩,每行十個音節,以便將其創作範圍限制在一定範圍內。

使用多步驟提示

有時,複雜的查詢可能會引發人工智能產生的錯覺,因為系統試圖立即解決這些問題。一種有效的策略是將這些問題分解為一系列連續的步驟,以更好地理解和回答準確性。

另一種詢問可以是:“通常採用哪些治療方法來治療糖尿病,根據醫學研究結果,其中哪些治療方法被認為更有效?

多步驟提示的使用迫使人工智能模型在給出明確的響應之前提供中間細節,最終產生更精確、更全面的答案。

為 AI 分配角色

在給定提示內定義人工智能模型的功能時,建立其預期目標同時最大限度地減少誤解或錯誤輸出的可能性是有利的。人們可以通過指示人工智能體現一位專注學者的角色來指導人工智能,而不是要求有關量子力學歷史發展的一般信息,該學者將仔細敘述塑造該領域發展軌蹟的關鍵事件。

建議的方法敦促人工智能體現勤奮的研究人員的特徵,而不是幻想的敘述者的特徵。

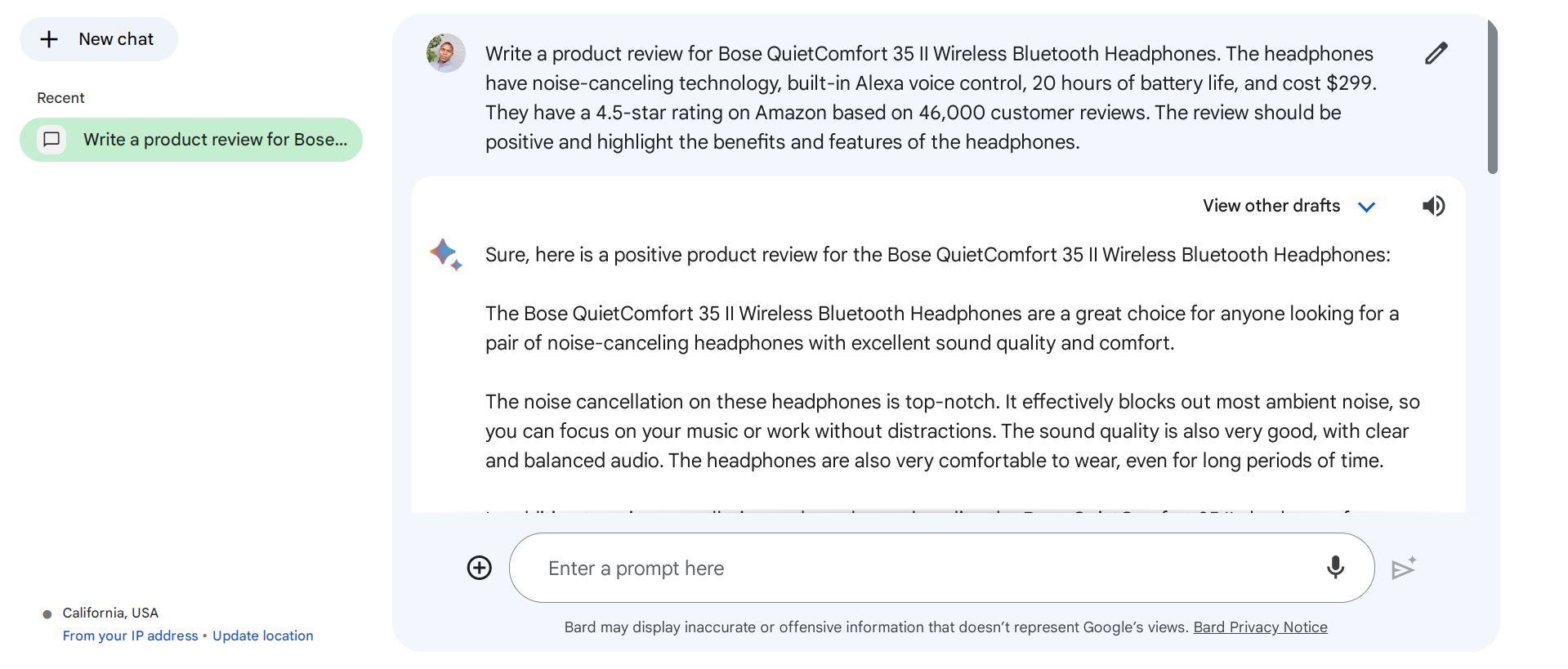

添加上下文信息

使用 ChatGPT 等人工智能模型而不提供適當的上下文細節可能會導致結果不理想。提供上下文信息有助於理解任務的基本上下文,包括其領域、目的以及任何相關的示例或參考文獻。此類數據可以包括關鍵字、標籤、類別、來源等,所有這些都有助於生成與預期含義更好地一致的響應。

為了對一套耳機進行評估,有必要提供上下文相關的詳細信息,包括該產品的名稱、製造商、功能、成本、排名和顧客評論。對此活動的有效邀請可能類似於以下格式:

獲得更好的人工智能響應

對於可能無法從人工智能模型獲得預期輸出的用戶來說,探索人工智能的局限性可能會讓人感到沮喪。然而,通過採用戰略性提示策略,人們可以減少人工智能產生錯覺的可能性,並從人工智能係統中得出更可靠、更準確的結果。

請注意,這些策略並不能保證絕對正確的結果,並且它們可能不適用於所有任務或主題。在將人工智能生成的內容用於任何關鍵應用之前,必須對其進行徹底的驗證過程。